HPE внедрила генеративный ИИ в облачную платформу Aruba Networking Central

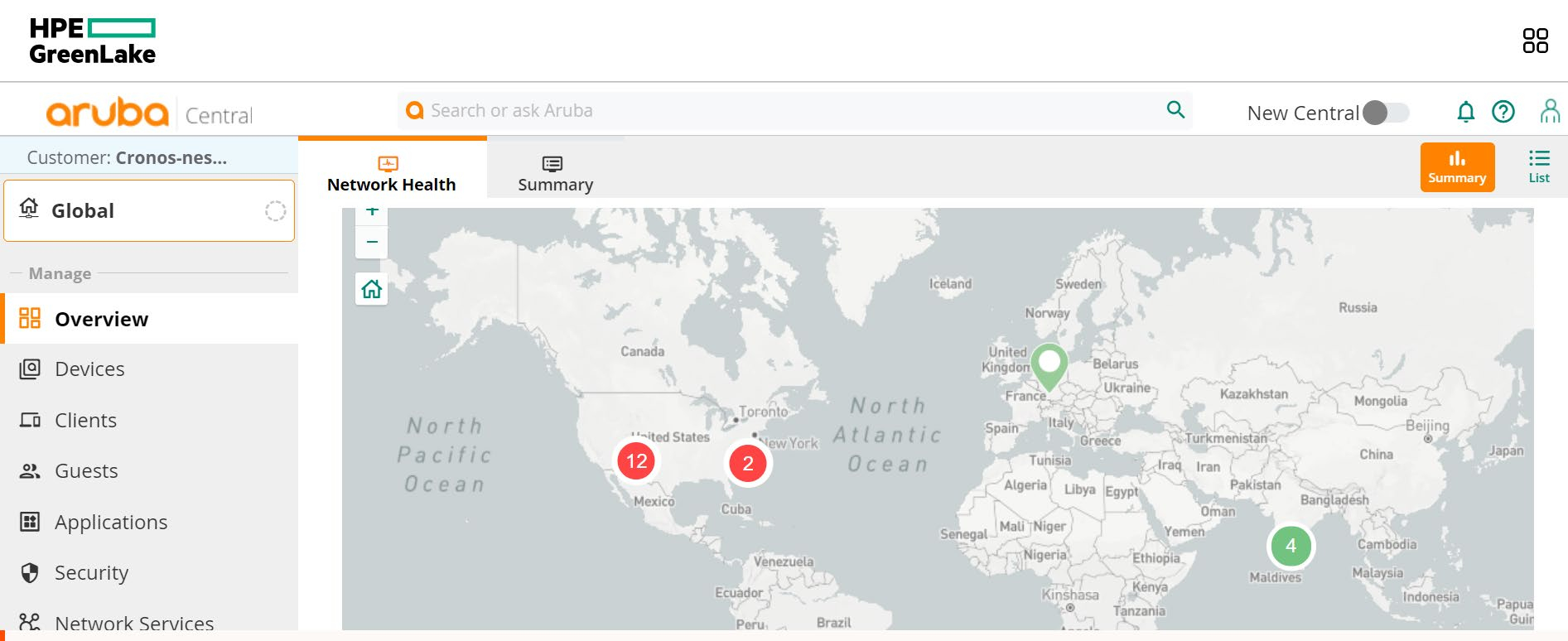

Компания HPE объявила о внедрении нескольких больших языковых моделей (LLM) в облачную платформу Aruba Networking Central, которая предоставляет IT-специалистам аналитическую информацию, интуитивно понятную визуализацию данных, средства автоматизации рабочих процессов и пр.

Сообщается, что LLM отвечают за работу функций на основе генеративного ИИ. Это, в частности, чат-бот, интегрированный в поисковый интерфейс. После ввода запроса система выдаёт контекстуализированный ответ, на подготовку которого, как утверждается, уходят доли секунды. При этом ИИ не принимает никакие административные решения самостоятельно.

Модели обучены на собственных наборах данных компании. Это всевозможные документы службы поддержки, примерно 3 млн запросов клиентов и другие сведения, собранные за годы работы. HPE подчёркивает, что модели помещены в песочницу. При этом реализованы специальные средства, предназначенные для исключения личной и корпоративной информации из запросов, чтобы предотвратить её попадание в будущие наборы обучающих данных.

HPE Aruba Networking собрала телеметрию почти с 4 млн сетевых устройств и более чем с 1 млрд уникальных конечных точек клиентов. В результате было сформировано одно из крупнейших озёр данных в сетевой отрасли. Эта информация используется в сервисах машинного обучения HPE Aruba Networking Central для прогнозного анализа и рекомендаций. Внедрение LLM поможет расширить ИИ-возможности платформы.

На базе LLM, как отмечается, также будет работать функция обобщения документов, которая заработает в апреле нынешнего года. Она позволит клиентам задавать вопросы вида «Как сделать…», после чего система создаст соответствующее руководство и предоставит ссылки на нужную техническую документацию. Это позволит ускорить решение проблем и снизить вероятность ошибок.