Гипервизор KVM (Kernel-based Virtual Machine) — модуль ядра Linux, который превращает обычный сервер под управлением Linux в гипервизор первого типа. То есть сама хост-система Linux выступает в роли bare-metal платформы для запуска виртуальных машин без отдельной промежуточной операционной системы. Именно это объясняет запрос «гипервизор kvm что это»: не отдельная программа, а часть ядра, которая реализует систему виртуализации на KVM внутри Linux.

KVM загружается в ядро в виде модулей kvm.ko и kvm-intel.ko или kvm-amd.ko. После загрузки ядро создаёт устройство /dev/kvm, через которое пользовательские процессы (обычно эмулятор QEMU) создают виртуальные машины и виртуальные процессоры. По формулировке Wikipedia, KVM — «бесплатный модуль ядра Linux, который позволяет ядру работать как гипервизор» — так описан гипервизор KVM в статье «Kernel-based Virtual Machine» на wikipedia.org.

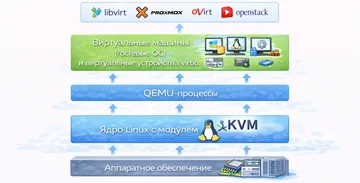

Гипервизор в целом — это слой, который абстрагирует физические ресурсы (процессор, процессор, диски, сеть) и отдаёт каждому гостю свой комплект виртуального «железа». В стеке виртуализации в Linux гипервизор KVM занимает уровень ядра, QEMU работает в пространстве пользователя и эмулирует устройства, а libvirt предоставляет единый API для управления.

Гипервизор KVM используют для виртуализации серверов, построения частных и публичных облаков, VPS-платформ, VDI и тестовых стендов. Ubuntu в обзоре «KVM hypervisor» описывает KVM как технологию, которая превращает любой современный дистрибутив Linux в промышленный гипервизор для дата-центров.

Место KVM в иерархии виртуализации и типах гипервизоров

Виртуализация ресурсов означает, что один физический сервер делит процессор, оперативную память, диски и сеть между несколькими изолированными средами. Для гостевой системы это выглядит как отдельный компьютер: с собственным набором ядер CPU, объёмом RAM, виртуальным диском и сетевым адаптером.

Гипервизор (Virtual Machine Monitor, VMM) управляет этим разделением. Он создаёт виртуальные процессоры, контролирует доступ к памяти, маршрутизирует операции ввода-вывода и следит, чтобы гостевые ОС не вмешивались в работу друг друга и хоста. В статье Enginyring.com «KVM explained: a deep dive into Kernel-based Virtual Machine technology» это описано как «абстракция физических ресурсов и выдача каждому гостю стандартизированного виртуального железа».

Контейнеры решают другую задачу. Они не создают отдельное ядро для каждого экземпляра, а изолируют процессы в рамках одного ядра хоста. Из-за этого контейнерные технологии вроде LXC или Docker удобны для лёгких Linux-нагрузок, но не подходят, если требуется гостевая Windows, собственное ядро или максимальная изоляция.

Отсюда место KVM: это гипервизор полной виртуализации, который создаёт полноценные виртуальные машины поверх Linux, а не контейнеры.

KVM в иерархии гипервизоров

С точки зрения реализации KVM относится к гипервизорам первого типа. Виртуализирующая логика живёт в ядре, использует аппаратные расширения Intel VT-x или AMD-V и работает практически напрямую с железом. Red Hat в документации по Red Hat Virtualization прямо указывает, что RHV построен на KVM как bare-metal гипервизоре.

Путаница возникает из-за того, что KVM всегда идёт в паре с QEMU, который запускается как обычный пользовательский процесс и эмулирует устройства. С этой стороны стек напоминает гипервизоры второго типа, которые выглядят как отдельная программа поверх хостовой ОС. Поэтому в нестрогих обзорах KVM иногда ошибочно относят к типу 2.

По сути картина такая: ядро Linux с модулем KVM выполняет роль гипервизора первого типа, а QEMU добавляет уровень эмуляции и сервисов в пространстве пользователя.

Сравнение гипервизоров 1-го и 2-го типов

| Параметр | Тип 1 (bare-metal) | Тип 2 (hosted) |

|---|---|---|

| Уровень работы | Непосредственно на «голом» железе без хостовой ОС | Как приложение поверх полноценной ОС |

| Производительность | Высокая, потери близки к нескольким процентам при аппаратной виртуализации | Дополнительные накладные расходы из-за слоя хостовой ОС |

| Примеры | KVM, VMware ESXi, Microsoft Hyper-V, Xen | VMware Workstation, VirtualBox |

| Типичные кейсы | ЦОД, облака, критичные БД и сервисы, высокая доступность | Разработка, тестирование, персональные лаборатории |

Архитектура KVM

Архитектура KVM строится вокруг трёх уровней: хост-машина с ядром Linux и модулем KVM, виртуальная машина KVM как гостевая ОС и набор виртуальных устройств, через которые гость взаимодействует с дисками, сетью и прочей периферией. Работа KVM основана на аппаратной виртуализации CPU и памяти и паравиртуализованных драйверах ввода-вывода, поэтому именно архитектуры KVM определяют предсказуемость и производительность всей системы.

Хост-машина — это сервер под управлением Linux с загруженным модулем KVM. Ядро Linux на хост-машине (хост машины) планирует процессы, управляет памятью и устройствами, а модуль KVM берёт на себя привилегированные операции гостевых систем. Вся виртуальная инфраструктура живёт внутри одного или нескольких таких хостов.

Виртуальная машина KVM с точки зрения Linux выглядит как процесс QEMU. Внутри гостевой ОС есть виртуальный процессор, виртуальная оперативная память, виртуальные устройства дисков, сетевые адаптеры и другие компоненты. Код ядра гостя выполняется на виртуальном процессоре, который сопоставлен с физическими ядрами хоста.

Виртуальный процессор (vCPU) — это абстракция, которую KVM показывает гостю вместо реальных ядер. Для гостя каждый vCPU — полноценный CPU, а KVM через аппаратные расширения переводит его инструкции на физический процессор. Соотношение vCPU и физических ядер настраивается и напрямую влияет на производительность виртуализации KVM.

Виртуальные устройства — диски, сетевые карты, шины, консоли. QEMU эмулирует аппаратную часть таких устройств, а модуль KVM ускоряет те пути, где есть аппаратная поддержка. Virtio-драйверы в гостевой ОС позволяют работать с диском и сетью через паравиртуализованный интерфейс и обходить тяжёлую полную эмуляцию в ВМ.

Роль ядра Linux и модуля KVM

Ядро Linux загружает модуль kvm.ko и процессор-специфичный модуль вроде kvm-intel.ko или kvm-amd.ko. Эти модули регистрируют устройство /dev/kvm и включают режим аппаратной виртуализации. При запуске виртуальной машины QEMU через системные вызовы и ioctl обращается к /dev/kvm, создаёт структуру ВМ и один или несколько vCPU.

Когда гостевая ОС выполняет привилегированную инструкцию, доступ к регистрам управления или памяти, процессор с VT-x или AMD-V генерирует событие VM-exit и передаёт управление обратно в хостовое ядро и модуль KVM. Модуль решает, как обработать операцию, обновляет виртуальное состояние процессора и возвращает гостя в режим выполнения. Для работы с памятью используется виртуальная MMU (vMMU) и аппаратные таблицы страниц EPT или NPT.

Связка выглядит так: ядро Linux управляет ресурсами хоста, модуль KVM виртуализирует CPU и память, vCPU представляют гостю абстрактные ядра, vMMU и EPT/NPT изолируют память разных ВМ.

Связка KVM + QEMU и управление устройствами

QEMU запускается как пользовательский процесс и отвечает за эмуляцию устройств и общий жизненный цикл виртуальной машины. Именно QEMU:

- создаёт процессы ВМ и выделяет им виртуальную память;

- конфигурирует виртуальные диски, сетевые адаптеры и другие виртуальные устройства;

- при каждом VM-exit, связанном с вводом-выводом, получает управление, обрабатывает операцию и снова отдаёт его в модуль KVM.

Virtio-драйверы в гостевой ОС заменяют тяжёлую эмуляцию реального железа на более простой паравиртуализованный протокол. Virtio-net ускоряет сеть, virtio-blk и virtio-scsi — диски, vhost-net выносит часть обработки в ядро хоста. Lightbits Labs в обзоре «Guide to KVM-based virtualization with SDS» подчёркивает, что именно virtio даёт KVM «near-metal performance» для I/O.

Libvirt и уровни управления

Libvirt даёт единый API для управления виртуальными машинами, сетями и хранилищем. Демон libvirtd или virtqemud принимает команды от CLI-утилит и панелей, переводит их в XML-описания доменов, сетей и пулов хранения и вызывает соответствующие команды QEMU и KVM.

На этом API основаны:

virsh,virt-install,virt-manager— инструменты для управления отдельными хостами;- Proxmox VE, oVirt, OpenStack, ZStack и другие платформы — системы, которые строят над libvirt собственные панели, кластеры, мониторинг и автоматизацию.

Подробное описание API KVM приведено в официальной документации ядра Linux на docs.kernel.org/virt/kvm/api.html, а архитектура libvirt и работа с различными драйверами представлены на libvirt.org/docs.html и в руководствах по OpenStack Compute (Nova), использующим libvirt-драйвер для KVM.

Использование гипервизора KVM

Гипервизор KVM применяют как основу системы виртуализации серверов и облачных платформ. Виртуализация KVM подходит там, где требуется надёжная изоляция, высокая производительность и контроль над средой. В отличие от узкоспециализированных решений гипервизор KVM адаптирован к широкому спектру систем и сценариев: от тестовых стендов до крупных систем KVM в корпоративных ЦОД.

Основные направления использования KVM как гипервизора:

- виртуализация серверов в корпоративных и коммерческих дата-центрах на системах KVM;

- частные и публичные облака на системах виртуализации KVM;

- VPS и IaaS-платформы, где гипервизоров KVM развёрнуто десятки и сотни;

- тестовые стенды, среды CI/CD, лаборатории разработчиков;

- виртуализация рабочих столов (VDI);

- специализированные нагрузки: базы данных, высоконагруженные сервисы, edge-узлы;

- платформы на KVM вроде Proxmox VE, oVirt, OpenStack.

Примеры задач:

- Виртуализация серверов в дата-центре: консолидация десятков физических серверов в несколько мощных узлов KVM, запуск виртуальных машин с веб-серверами, СУБД, сервисами 1С.

- Частные и гибридные облака: OpenStack или oVirt работают как платформа на KVM и предоставляют инфраструктуру как сервис с учётом политик компании.

- Публичные облака и VPS/IaaS: хостинг-провайдеры строят виртуальные серверы на KVM, чтобы выдавать клиентам полноценные виртуальные машины с root-доступом.

- Тестовые стенды и CI/CD: разработчики поднимают на KVM короткоживущие среды для тестов, сборок, регрессионных прогонов без зависимости от «железа».

- VDI: виртуальные рабочие столы на серверах KVM для сотрудников, которым нужен удалённый доступ к корпоративным приложениям.

- Специализированные нагрузки: виртуальные серверы с интенсивной работой диска и сети, в том числе базы данных и микросервисы на edge-узлах.

Основные преимущества и минусы KVM как гипервизора

В 2025 году KVM представляет собой зрелый гипервизор, который конкурирует с коммерческими платформами по производительности и гибкости. При этом остаются ограничения, связанные с управлением и требованиями к компетенциям команды, и именно плюсы и минусы KVM определяют выбор платформы.

Ключевые преимущества KVM:

- Высокая производительность. Аппаратная виртуализация VT-x/AMD-V и virtio-драйверы дают результат, близкий к «голому» железу, особенно для диска и сети. Enginyring.com называет KVM «full, true virtualization solution» с near-native производительностью.

- Открытый исходный код. KVM встроен в ядро Linux под GPL, нет платы за лицензии, обновления безопасности поступают через стандартный механизм обновления дистрибутива.

- Гибкая настройка. Поддерживаются тонкая раздача памяти и CPU, over-commit ресурсов, NUMA-осведомлённость, live migration, snapshots.

- Широкая поддержка в экосистеме Linux и облаков. KVM — базовый гипервизор для OpenStack, Proxmox VE, oVirt, многих публичных облаков.

Основные недостатки и ограничения:

- Порог входа. Без опыта Linux администрирование KVM затруднено: придётся разбираться с libvirt, сетевыми мостами, хранилищем.

- Зависимость от качества хранилища и сети. Медленные диски или перегруженная сеть мгновенно ухудшают производительность всей виртуализации KVM.

- Особенности работы с гостевыми Windows. Требуются гостевые virtio-драйверы, внимательная настройка, учёт лицензионных ограничений.

- Отсутствие монолитного графического интерфейса «из коробки». Для удобного управления кластерами нужны платформы вроде Proxmox VE, oVirt, коммерческие панели.

Таблица преимуществ и недостатков KVM

| Преимущества KVM | Недостатки KVM |

|---|---|

| Близость к железу и высокая производительность | Требуется уверенное владение Linux и инструментами CLI |

| Интеграция в ядро Linux, нет отдельной установки гипервизора | Сложность полноценной настройки сети, хранилища и безопасности |

| Открытый код и отсутствие лицензионных платежей | Нет единого официального GUI уровня vSphere |

| Сильная изоляция ВМ и поддержка SELinux/AppArmor | Качество работы сильно зависит от дисковой подсистемы и сети |

| Гибкая работа с ресурсами, поддержка over-commit и миграций | Для тонкого тюнинга нужны глубокие знания виртуализации |

Сравнение KVM с другими гипервизорами

При выборе гипервизора инженеры учитывают несколько групп критериев:

- Архитектура: тип гипервизора и его реализация (bare-metal, ядро Linux, разделённые домены).

- Производительность: насколько близко платформа подходит к нативной скорости при целевых нагрузках.

- Лицензирование и стоимость владения: лицензии, поддержка, скрытые расходы на интеграцию.

- Масштабируемость и управление: кластеры, миграции, отказоустойчивость, удобство панелей.

- Экосистема и поддержка: наличие готовых интеграций, документации, сообщества и коммерческих партнёров.

KVM vs VMware ESXi

KVM и VMware ESXi относятся к гипервизорам первого типа, но отличаются подходом.

- Архитектура. KVM реализован в ядре Linux, использует общий стек драйверов и сервисов. ESXi — собственное минималистичное ядро VMkernel, заточенное под виртуализацию.

- Лицензирование. KVM распространяется свободно, платят только за поддержку дистрибутива или платформы (Red Hat, Proxmox). ESXi требует лицензии vSphere, крупнейшие функции (vMotion, DRS, VDS) доступны только в платных редакциях.

- Стоимость владения. Для инфраструктур с десятками серверов затраты на лицензии ESXi значительны. KVM выгоден при ограниченном бюджете и готовности инвестировать в собственную автоматизацию.

- Управление. ESXi вместе с vCenter и vSphere даёт зрелый стек: централизованное управление, DR-инструменты, развитая экосистема. KVM требует внешних решений — Proxmox, oVirt, OpenStack.

В обзорах от интеграторов и вендоров повторяется вывод: гипервизор KVM рационален для open-source сред и тех, кто строит собственные облака на KVM и технологиях Linux, ESXi удобен там, где важна готовая корпоративная экосистема и стандарт де-факто для ИТ-подразделений.

KVM vs Microsoft Hyper-V

Hyper-V — гипервизор Microsoft, плотно интегрированный в Windows Server.

- Платформа. Hyper-V логичен в инфраструктуре, где преобладают Windows-серверы, Active Directory, System Center. KVM естественно вписывается в стеки Linux и open-source.

- Лицензирование. В Windows-окружении Hyper-V часто идёт как часть лицензии Windows Server, что упрощает расчёт бюджета. Для смешанных сред без привязки к Microsoft KVM обходит Hyper-V по гибкости и стоимости.

- Интеграция. Hyper-V выдаёт гостям интеграционные сервисы, тесно работает с AD и системами Microsoft. KVM аналогично интегрируется с Linux-миром и облачными оркестраторами.

KVM vs Xen и другие решения

Xen исторически ориентирован на паравиртуализацию и многоуровневую архитектуру с доменом управления (dom0). Это даёт сильную изоляцию и предсказуемый QoS для критичных систем, но усложняет стек.

KVM, по сравнению с Xen, выглядит проще: нет отдельного домена управления, используется базовое ядро Linux. Это облегчает сопровождение, но накладывает ограничения на гарантии жёсткой изоляции на уровне планировщика ядра.

Proxmox VE, популярная платформа виртуализации, использует KVM как основной гипервизор и LXC для контейнеров. То есть здесь KVM выступает базой, а платформа добавляет удобный веб-интерфейс, кластеризацию и бэкапы.

Сводная таблица сравнения гипервизоров

| Критерий | KVM (Linux) | VMware ESXi | Microsoft Hyper-V | Xen |

|---|---|---|---|---|

| Тип/архитектура | Тип 1, модуль ядра Linux | Тип 1, собственное ядро VMkernel | Тип 1, гипервизор с управляющей Windows-ОС | Тип 1, микроядро с доменом управления dom0 |

| Лицензия | Открытый код (GPL), без лицензий за гипервизор | Проприетарная, платные редакции vSphere | Входит в Windows Server, лицензирование по ядрам | Открытый код, коммерческие сборки Citrix |

| Производительность | Близка к нативной при virtio и тюнинге | Высокая, особенно в типичных enterprise-нагрузках | Высокая в Windows-нагрузках | Высокая, особенно при паравиртуализации |

| Управление | Libvirt, Proxmox, oVirt, OpenStack | vCenter, vSphere, развитый enterprise-стек | SCVMM, интеграция с AD и Windows-инструментами | Инструменты Citrix и open-source панели |

| Экосистема | OpenStack, Proxmox, RHV, множество OSS-проектов | Богатая партнёрская экосистема, VDI, DR | Экосистема Microsoft и Azure | Использование в облаках и специализированных решениях |

| Типичные сценарии | Open-source облака, VPS, импортозамещение | Крупные корпоративные ЦОД и VDI | Windows-центричные корпоративные среды | Системы с повышенными требованиями к изоляции |

KVM и LXC: сравнение технологий виртуализации и контейнеризации

KVM и LXC решают схожую задачу — изоляцию приложений на одном сервере, однако делают это на разных уровнях технологий виртуализации.

Гипервизор KVM предоставляет полную виртуализацию: каждая виртуальная машина имеет собственное ядро, видит виртуальное железо и не зависит от ядра хоста. Это даёт сильную изоляцию, поддержку любых гостевых ОС и привычную модель работы «как с отдельным сервером».

Контейнеры LXC относятся к технологиям контейнеризации. Они используют общее ядро хоста, а изолируют процессы с помощью namespaces и cgroups. Такой подход экономит ресурсы и ускоряет запуск, но ограничивает круг гостевых систем Linux-дистрибутивами и усиливает влияние ядра хоста на все контейнеры.

KVM целесообразен, когда нужна отдельная гостевая ОС, переносимость окружения, строгая изоляция и возможность запустить Windows или BSD. LXC уместен для множества лёгких Linux-сервисов, где важны плотность и скорость масштабирования. В гибридных решениях облако на KVM и технологиях контейнеризации позволяет держать тяжёлые сервисы в ВМ, а статeless-нагрузки в контейнерах.

Таблица сравнения KVM и LXC

| Параметр | KVM | LXC |

|---|---|---|

| Уровень изоляции | Полная: отдельное ядро, виртуальное железо | Ядро общее, изоляция на уровне процессов |

| Накладные расходы | Есть оверхед гипервизора и эмуляции, снижается с VT-x | Минимальные, близки к bare-metal |

| Типичные сценарии | Универсальные ВМ, любые ОС, миграции, снапшоты | Масштабируемые Linux-сервисы, высокая плотность |

| Безопасность | Выше из-за раздельных ядер и аппаратной виртуализации | Зависит от ядра хоста, риск выхода за пределы контейнера |

| Удобство управления | Управление как серверами, запуск дольше, сложнее | Быстрый старт, лёгкое клонирование и масштабирование |

| Гибкость | Любые ядра и драйверы, глубокий тюнинг | Привязка к Linux, проще модель ресурсов |

| Зависимость от ОС | Гостевые системы разных семейств | Только Linux-системы на общем ядре |

Оборудование для виртуализации KVM: серверы Lenovo, Rikor, XFusion и СХД Dell

Для виртуализации KVM сервер нужна платформа с поддержкой аппаратной виртуализации, достаточным объёмом памяти и надёжной дисковой и сетевой подсистемами. Типичный вариант — стойковый 2U сервер с двумя процессорами и большим количеством слотов под диски. Такой профиль подходит для стойковых серверов в ЦОД и в серверных комнатах среднего бизнеса.

Ключевые требования:

- CPU с поддержкой Intel VT-x или AMD-V, лучше серверные линейки Intel Xeon или AMD EPYC.

- Объём RAM, достаточный для планируемого числа ВМ с запасом: для десятков гостевых машин — сотни гигабайт.

- Наличие отсеков под SSD и NVMe для быстрых пулов хранения, особенно при I/O-интенсивных нагрузках.

- Несколько портов 10G или выше для сетевых подключений и изоляции трафика хранения и управления.

По опыту Kvantech в проектах серверной виртуализации KVM для средних и крупных организаций оптимально использовать 2U сервер для виртуализации с двумя процессорами и SSD/NVMe-пулом: такие конфигурации хорошо выдерживают десятки виртуальных серверов и нагрузку от систем KVM резервного копирования и мониторинга.

Примеры профилей:

- Стойковые 2U серверы Lenovo ThinkSystem, такие как SR650 V3/V4, с двумя процессорами Xeon, поддержкой до десятков терабайт RAM и множеством отсеков под диски. Официальные спецификации размещены на сайте Lenovo в разделе servers-storage.

- Серверы Rikor ориентированы на российский рынок и импортозамещение, обеспечивают поддержку современных процессоров и модулей памяти. Сервер Rikor в типичной конфигурации под KVM использует два процессора AMD EPYC и быстрые NVMe-диски.

- Серверы XFusion (бывшее серверное направление Huawei) предлагают линейки 1U и 2U с поддержкой Intel Xeon и AMD EPYC, большим числом слотов под RAM и диски, что подходит для платформ виртуализации KVM.

- СХД Dell (серии PowerVault, PowerStore и др.) используется как внешнее хранилище для кластеров KVM. Через iSCSI, Fibre Channel или NVMe-over-Fabrics такие системы становятся общим пулом хранения для нескольких гипервизоров; это типичный сценарий использования СХД Dell для виртуализации.

Таблица примерных конфигураций оборудования под KVM

| Позиция | Форм-фактор | CPU | RAM | Диски | Сценарий использования |

|---|---|---|---|---|---|

| Стойковый 2U сервер Lenovo | 2U Rack | 2× Intel Xeon с VT-x | 128–512 ГБ ECC DDR4/5 | SSD/NVMe в 8–24 отсеках | Средний и крупный кластер |

| Сервер Rikor | 2U Rack | 2× AMD EPYC с AMD-V | 128–512 ГБ ECC | NVMe/SSD + подключение к СХД | Крупный кластер, импортозамещение |

| Сервер XFusion | 1–2U Rack | 1–2× Intel Xeon или AMD EPYC | 64–256 ГБ ECC | SSD + сетевое хранилище | Малый и средний кластер |

| СХД Dell для виртуализации KVM | Rack | Управляющий контроллер | 64–256 ГБ под кеш | Пул NVMe/SSD от единиц ТБ | Внешнее хранилище для кластеров |

Примеры серверов

За точными параметрами лучше обращаться к техническим описаниям на официальных сайтах Lenovo, Rikor, XFusion и Dell, где указаны поддерживаемые процессоры, максимальный объём RAM, типы контроллеров и допустимая нагрузка. Это снижает риск ошибок при подборе оборудования для серверов под KVM.

Производительность, масштабируемость и оптимизация KVM

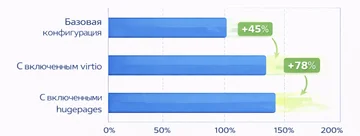

Тюнинг CPU и памяти

Для высоконагруженных систем на KVM важна корректная настройка процессора и памяти:

- CPU pinning. Привязка vCPU к конкретным физическим ядрам уменьшает задержки и колебания производительности, особенно для баз данных и сетевых приложений. Настройка выполняется через параметры

cputuneиvcpupinв libvirt. - NUMA-осведомлённость. На многопроцессорных серверах память и ядра распределены по NUMA-нодам. Важно закреплять ВМ в рамках одной ноды и соответствующим образом раздавать память, чтобы избежать лишних задержек при межнодовых обращениях.

- Выбор модели CPU гостя. Режимы

host-modelиhost-passthroughпозволяют гостю использовать практически весь набор инструкций хоста, что повышает эффективность и упрощает перенос приложений. - Hugepages. Крупные страницы памяти снижают нагрузку на TLB и ускоряют доступ к памяти для больших баз данных и in-memory приложений. Включаются на хосте и подключаются к ВМ как backing store.

Red Hat в Virtualization Tuning and Optimization Guide отдельно расписывает выгоды CPU pinning и hugepages для реального времени и БД.

Оптимизация дисковой и сетевой подсистем

Для дисковой подсистемы:

- Использование виртуальных дисков

rawна LVM или блочных устройствах вместо сильно вложенныхqcow2. - Применение virtio-blk или virtio-scsi с выделенными I/O-потоками, настройка параметров кэширования

cache=noneилиwritethroughв зависимости от требований к целостности. - Правильный выбор планировщика I/O в гостях и на хосте, обычно

noneилиmq-deadlineдля современных SSD.

Для сети:

- Использование virtio-net с включёнными многократными очередями (multiqueue) для многоядерных ВМ.

- Включение аппаратных offload-функций сетевых карт, таких как checksum offload и segmentation offload, при условии стабильной работы драйверов.

- Разделение трафика управления, пользовательского трафика и трафика хранения по разным интерфейсам и VLAN.

Рекомендации для разных типов нагрузок

- Базы данных: закреплённые vCPU, NUMA-осведомлённость, hugepages,

raw-диски на LVM или SAN, приоритизация I/O. - Web-приложения: virtio-net, мостовая сеть, умеренная оверсубскрипция CPU, эффективное кэширование диска.

- VDI: достаточный запас RAM, аккуратное использование KSM, мониторинг диска и сети.

- CI/CD: быстрые

qcow2-образы с шаблонами, автоматическое создание/удаление ВМ, ограничение ресурсоёмких задач.

| Тип нагрузки | CPU и топология | RAM и память | Хранилище | Сеть |

|---|---|---|---|---|

| Базы данных | CPU pinning, NUMA-согласованность | Фиксированный объём, hugepages | RAW на LVM или SAN, высокий IOPS | Стандартный virtio-net |

| Web-приложения | Умеренный over-commit | Динамическое выделение | SSD/qcow2 для гибкости | Virtio-net, bridge-сеть |

| VDI | Запас vCPU на пользователя | Фиксированный объём | SSD-пул, учёт профиля I/O | Сегментация трафика, QoS |

| CI/CD и тесты | Высокая плотность vCPU | Ballooning и KSM | qcow2 c шаблонами | NAT или изолированные сети |

Безопасность виртуализации на базе KVM

Безопасность в KVM складывается из аппаратной виртуализации, механизмов ядра Linux и дополнительной политики доступа.

Изоляция ВМ и механизмы безопасности

- Аппаратная безопасность: расширения VT-x/AMD-V и таблицы страниц EPT/NPT обеспечивают раздельные адресные пространства для гостевых ОС. Гость не имеет прямого доступа к памяти хоста и других ВМ.

- sVirt и SELinux/AppArmor: процессы QEMU, обслуживающие ВМ, запускаются с отдельными SELinux-контекстами и профилями AppArmor. Это уменьшает риск выхода из ВМ из-за уязвимости в эмуляторе устройств.

- Изоляция устройств: VFIO и IOMMU позволяют отдавать ВМ физические устройства (GPU, сетевые карты) без доступа к остальным устройствам хоста.

Эти механизмы подробно описаны в официальных руководствах по безопасности дистрибутивов (RHEL Security Guide, Ubuntu Security Features), а также в документации sVirt.

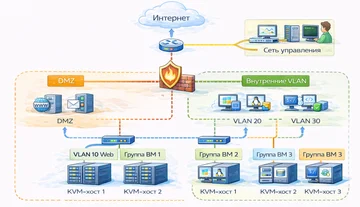

Сетевая безопасность и сегментация

Виртуальная инфраструктура на KVM использует обычные сетевые механизмы Linux, поэтому доступны:

- iptables, nftables, firewalld для фильтрации трафика на хосте;

- VLAN для разделения сетей ВМ на уровне 802.1Q;

- DMZ-сегменты для вынесения публичных сервисов на отдельные подсети;

- отдельные management-сети для изоляции доступа к гипервизорам и панелям управления.

Практический чек-лист безопасной эксплуатации:

- ограничить доступ к портам управления libvirt, панелям и SSH;

- вынести управление в отдельную VLAN, не связанную с пользовательским трафиком;

- регулярно обновлять ядро, QEMU, libvirt и гостевые ОС;

- использовать SELinux/AppArmor и sVirt в рекомендованном режиме дистрибутива;

- следить за актуальными security-advisories выбранного дистрибутива.

Обновления и уязвимости (Spectre, Meltdown и др.)

Спектр уязвимостей Spectre, Meltdown и схожих классов показал, насколько важны актуальные ядро и микрокод процессора для гипервизоров. Патчи для ядра и микрокодов обычно публикуются дистрибутивами через security-обновления.

Безопасный процесс обновления для KVM-хостов включает:

- тестирование новых ядер и версий QEMU на стенде, а не сразу в продакшене;

- планирование окон обслуживания и наличие стратегии отката;

- учёт влияния патчей на производительность и пересмотр лимитов ресурсов.

Актуальные рекомендации по уязвимостям и патчам публикуются в разделах безопасности дистрибутивов: Debian Security Tracker, Red Hat Security Advisories, SUSE security bulletins и аналогичных ресурсах. Это позволяет своевременно прикрывать уязвимости в гипервизоре KVM и ядре.

Типичные ошибки и подводные камни при работе с KVM

Недооценка RAM, CPU или IOPS приводит к тому, что виртуальные машины периодически «замирают», приложения отвечают рывками, а дисковая подсистема уходит в постоянные очереди. Типичная картина:

- высокий уровень использования swap на хосте и в гостях;

- рост среднего времени отклика диска;

- состояния OOM в гостях.

Решение — мониторинг ресурсов, разумная оверсубскрипция, отделение I/O-интенсивных ВМ на отдельные пулы и дисковые группы.

Ошибки в сети и безопасности

Распространённые проблемы:

- неправильно настроенный bridge, когда физическому интерфейсу и мосту одновременно назначают IP-адреса;

- отсутствие VLAN и сегментации, все ВМ и хосты находятся в одной вещательной домене;

- открытые management-интерфейсы без брандмауэра и аутентификации.

Для KVM-инфраструктуры эти ошибки означают как минимум нестабильную сеть, как максимум прямой путь к компрометации гипервизоров.

Обновления ядра и совместимость

Обновление ядра или модулей KVM без предварительного тестирования грозит:

- несовместимостью модулей и драйверов;

- регрессиями в подсистемах памяти, I/O или сети;

- падениями ВМ и снижением производительности.

Выход — отдельный тестовый контур, staged-обновления, чёткий план отката и контроль версий QEMU/libvirt и ядра.

| Типичная ошибка | Симптомы | Как исправить |

|---|---|---|

| Нет поддержки VT-x/AMD-V | virt-host-validate ругается на отсутствие KVM | Включить виртуализацию в BIOS/UEFI, обновить прошивку |

| Хранилище переполнено | ВМ не стартуют, ошибки создания дисков | Освободить место, настроить мониторинг и квоты |

| Неверный bridge | ВМ не получают IP, сеть не отвечает | Переназначить IP мосту, проверить конфигурацию |

| Чрезмерный over-commit CPU/RAM | Высокие задержки, нагрузка на CPU близка к 100% | Снизить плотность ВМ, закрепить ресурсы критичным |

| Снапшоты без контроля | Диск замедляется, растут файлы qcow2 | Регулярно сливать и удалять старые снапшоты |

| Обновление ядра без теста | Периодические падения ВМ | Вернуть стабильную версию, ввести этап тестирования |

Эти ошибки регулярно всплывают в проектах по внедрению и аудиту инфраструктуры на KVM по описаниям технических форумов, документации и кейсов интеграторов.

Как выбрать гипервизор: когда KVM — лучший вариант

При выборе гипервизора учитываются:

- требования к лицензированию и бюджету;

- доминирующий стек технологий (Linux или Windows);

- масштаб инфраструктуры и требования к управлению;

- компетенции команды;

- требования к сертификации и официальной поддержке.

Если приоритет — открытый код, отсутствие зависимостей от конкретного вендора и интеграция с Linux, KVM обычно оказывается в числе первых кандидатов.

Сценарии, где KVM максимально выгоден

KVM особенно выгоден:

- в open-source средах и проектах с жёстким бюджетом;

- при построении крупных кластеров и облаков, где стоимость лицензий коммерческих гипервизоров становится критичной;

- в инфраструктурах с преобладанием Linux-систем и потребностью в глубокой интеграции с существующими инструментами;

- в проектах импортозамещения и у компаний, которым важен контроль над стеком до уровня исходного кода.

Когда альтернативы могут быть лучше

VMware ESXi или Hyper-V предпочтительны:

- в полностью Windows-ориентированных инфраструктурах;

- при строгих требованиях к сертификации и формальной поддержке, где важен один вендор и SLA;

- при ставке на специфические функции корпоративных платформ (VDI, комплексные DR-решения, tightly integrated management).

Комментарии(0)

Новый комментарий

Новый комментарий отправлен на модерацию