GPU или графический процессор — это специализированный электронный компонент, который действует как мощный «мозг» для обработки и вывода графики, обеспечивая плавность изображения в играх, видео и сложных программах. В отличие от центрального процессора (CPU), он способен выполнять тысячи мелких задач одновременно, что делает его незаменимым для современных вычислений.

Что такое GPU (ГПУ) и для чего он нужен?

Графический процессор (GPU или ГПУ) — это основной вычислительный чип, своего рода «двигатель» видеокарты. Его главная задача — выполнять огромное количество параллельных вычислений для рендеринга, то есть отрисовки изображений, видео и трехмерной анимации. Именно ГПУ отвечает за то, чтобы на экране монитора появлялись сложные визуальные эффекты, текстуры и модели. Это устройство стало неотъемлемой частью современных компьютеров, ноутбуков, игровых консолей и даже смартфонов, разгружая центральный процессор от тяжелой графической работы.

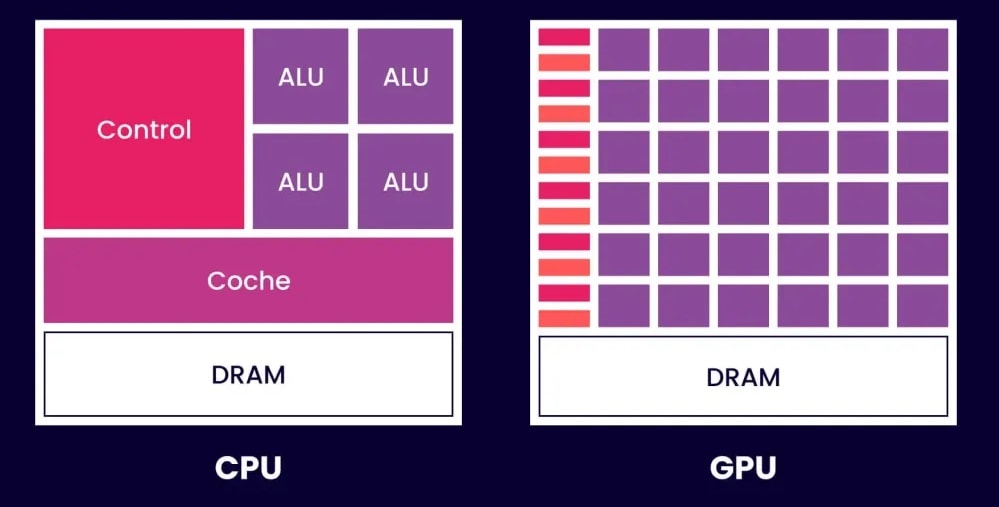

Главное отличие GPU от CPU: два "мозга" для разных задач

Центральный процессор (CPU) и графический процессор (GPU) не заменяют, а дополняют друг друга, работая в команде. Если CPU можно сравнить с универсальным менеджером, который силен в последовательном выполнении разноплановых и сложных задач, то GPU — это команда узких специалистов, гениально справляющихся с массовыми однотипными операциями.

Что делает CPU: последовательный король задач

Центральный процессор (CPU) специализируется на последовательном выполнении команд и управлении общей логикой системы. Он обладает несколькими (от 4 до 24 в современных моделях) высокопроизводительными ядрами, каждое из которых способно быстро решать сложные и нелинейные задачи одну за другой. CPU идеален для запуска операционной системы, работы программного обеспечения, обработки игровой логики и других операций, где важна низкая задержка и быстрое переключение между разными типами вычислений.

В чем сила GPU: специалист по массовым операциям

Сила графического процессора (GPU) заключается в его архитектуре, созданной для массового параллелизма. Он содержит тысячи более простых ядер, которые одновременно обрабатывают огромные массивы однотипных данных. Самый наглядный пример — обработка пикселей на экране. Чтобы отрисовать один кадр в 4K-разрешении, нужно рассчитать цвет более 8 миллионов пикселей. GPU справляется с этим за доли секунды, назначая каждому ядру свою небольшую часть работы.

| Параметр | CPU (Центральный процессор) | GPU (Графический процессор) |

|---|---|---|

| Основная задача | Универсальные вычисления, управление системой, последовательные задачи | Высокопараллельные вычисления, обработка графики и массивных данных |

| Архитектура | Несколько мощных ядер со сложной логикой управления и большим кэшем | Тысячи более простых ядер, оптимизированных для параллельной обработки |

| Количество ядер | От 4 до 24 в настольных моделях 2025 года | От нескольких тысяч до более 18 000 в современных моделях |

| Тип вычислений | Последовательные и разнородные операции общего назначения | Массивно-параллельные однотипные вычисления (например, матричные) |

| Примеры задач | Работа ОС, игровая логика, офисные приложения, браузеры | Рендеринг 3D-графики, машинное обучение, видеообработка, научные симуляции |

Как работает GPU: принцип параллельных вычислений

Принцип работы GPU основан на массово-параллельных вычислениях. Вместо того чтобы решать одну большую задачу последовательно, как это делает CPU, графический процессор разбивает ее на тысячи мелких, независимых подзадач и выполняет их все одновременно. Эта архитектура обеспечивает колоссальную производительность при обработке графических данных и других вычислений, где требуется постоянное взаимодействие с большими объемами информации. Процесс работы GPU можно разложить на несколько ключевых этапов.

- Архитектура с тысячами ядер. В основе любого современного GPU лежит огромное количество вычислительных ядер. У компании NVIDIA они называются CUDA Cores, у AMD — Stream Processors. Если в производительном CPU в 2025 году может быть 16 или 24 ядра, то в топовом GPU их число превышает 18 000. Каждое из этих ядер проще, чем ядро CPU, но их совместная работа обеспечивает невероятную вычислительную мощь.

- Потоковая обработка. Когда GPU получает большую задачу, к примеру, отрисовать кадр в игре, он разбивает ее на тысячи мелких потоков (threads). Каждый поток представляет собой небольшую операцию, как расчет цвета одного пикселя или положения одной вершины 3D-модели. Эти потоки распределяются между тысячами ядер, которые выполняют их параллельно.

- Специализированная память (VRAM). Для своей работы GPU использует собственную сверхбыструю видеопамять, известную как VRAM (Video RAM). В 2025 году это стандарты GDDR6X и GDDR7. В этой памяти хранятся текстуры, модели, кадровые буферы и другие данные, которые нужны для мгновенного доступа. Наличие собственной быстрой памяти позволяет GPU не конкурировать с CPU за доступ к общей оперативной памяти (RAM), что значительно ускоряет обработку.

GPU и видеокарта — это одно и то же?

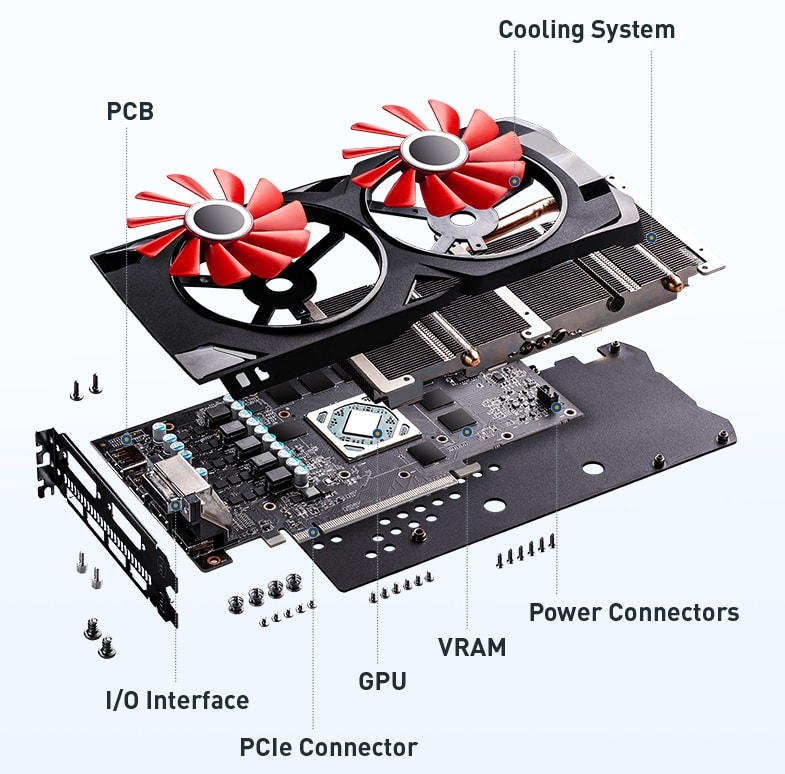

Эти понятия часто путают, но они не взаимозаменяемы. Если представить аналогию с автомобилем, то видеокарта — это весь автомобиль, а GPU — это его двигатель. GPU является сердцем и мозгом видеокарты, но сама видеокарта представляет собой более сложное и комплексное устройство.

GPU — "мозг" видеокарты

GPU — это непосредственно сам процессор, чип, который выполняет все графические и параллельные вычисления. Именно его характеристики (архитектура, количество ядер, тактовая частота) определяют основную производительность видеокарты. Он является главным, но далеко не единственным компонентом.

Что еще есть на видеокарте?

Помимо графического процессора, на печатной плате (PCB) видеокарты размещаются другие критически важные компоненты:

- Видеопамять (VRAM). Чипы памяти, где хранятся данные для обработки.

- Система охлаждения. Радиатор и вентиляторы (или водоблок) для отвода тепла от горячего GPU.

- Видеовыходы. Порты, такие как HDMI и DisplayPort, для подключения мониторов.

- Система питания (VRM). Компоненты, которые регулируют и стабилизируют напряжение для GPU и памяти.

Сферы применения современных GPU

Если раньше графические процессоры ассоциировались исключительно с играми, то сегодня их применение вышло далеко за эти рамки. Благодаря своей способности эффективно выполнять параллельные вычисления, современные GPU стали ключевым ускорителем для самых требовательных задач в науке, бизнесе, искусстве и технологиях.

Гейминг и 3D-графика в реальном времени

Исторически первое и до сих пор основное применение GPU — это игры. Именно графические процессоры отвечают за рендеринг фотореалистичных игровых миров, обработку сложной физики объектов и освещения. Современные технологии, такие как трассировка лучей (Ray Tracing) для реалистичных отражений и теней, а также интеллектуальное масштабирование изображения (NVIDIA DLSS, AMD FSR), полностью зависят от мощи GPU.

Использование GPU в анализе данных, машинном обучении и ИИ

Параллельная архитектура GPU идеально подходит для задач машинного обучения и работы с искусственным интеллектом (ИИ). Обучение нейросетей требует выполнения миллиардов однотипных математических операций, и GPU справляются с этим в десятки и даже сотни раз быстрее, чем CPU. Именно благодаря GPU произошла революция в области глубокого обучения (deep learning).

Эти технологии позволили создать современные нейросети для генерации изображений, текста и анализа больших наборов данных (Big Data).

GPU для майнинга криптовалют

Способность GPU быстро выполнять однотипные математические вычисления сделала их идеальным инструментом для майнинга многих криптовалют. Такие алгоритмы, как Ethash (использовался в Ethereum), требовали интенсивного перебора хеш-функций, с чем графические процессоры справлялись намного эффективнее центральных. Хотя с переходом на другие алгоритмы и появлением специализированных ASIC-устройств роль GPU в майнинге снизилась, они сыграли ключевую роль в становлении криптоиндустрии.

Профессиональная работа с видео, фото и 3D-моделированием

В творческих профессиях GPU ускоряет множество процессов. Программы для видеомонтажа, такие как Adobe Premiere Pro и DaVinci Resolve, используют GPU для ускорения рендеринга, применения эффектов и плавного воспроизведения видео высокого разрешения. В 3D-моделировании (Blender, 3ds Max) GPU сокращает время рендеринга сложных сцен с часов до минут. Даже в Adobe Photoshop многие фильтры и операции ускоряются с помощью графического процессора.

Серверы с GPU: для чего они нужны?

В дата-центрах и облачных инфраструктурах серверы с GPU применяются для решения ресурсоемких задач. К ним относятся научные расчеты и симуляции, облачные вычисления, удаленный рендеринг (render farms) и инфраструктура виртуальных рабочих столов (VDI). Наш опыт в Kvantech показывает, что спрос на такие решения для научных расчетов и ИИ-моделей постоянно растет, так как они позволяют бизнесу и научным институтам получать доступ к передовым вычислительным мощностям для цифровой трансформации.

Основные типы графических процессоров

Графические процессоры бывают разными по форм-фактору, производительности и способу интеграции в систему. Выбор конкретного типа зависит от задач, для которых собирается компьютер.

Дискретная (Dedicated) видеокарта

Это отдельная плата, которая устанавливается в слот PCIe на материнской плате. Дискретные видеокарты обладают максимальной производительностью, собственной выделенной видеопамятью (VRAM) и мощной системой охлаждения. Это стандарт для современных игровых ПК, профессиональных рабочих станций и серверов.

Интегрированная (Integrated) графика

Это GPU, который встроен непосредственно в кристалл центрального процессора (CPU). Такое решение не имеет собственной памяти и использует часть системной оперативной памяти (RAM). Интегрированная графика менее производительна, но при этом энергоэффективна и дешева. Она идеально подходит для офисных компьютеров, тонких ноутбуков и систем, где не требуется высокая графическая мощность.

Внешний GPU (eGPU)

Это полноразмерная дискретная видеокарта, размещенная в специальном внешнем боксе. Этот бокс подключается к ноутбуку через высокоскоростной порт, такой как Thunderbolt. Такое решение позволяет превратить компактный ноутбук в мощную игровую или рабочую станцию, когда это необходимо, сохраняя при этом мобильность.

Как выбрать GPU: на что обратить внимание?

Выбор графического процессора — важное решение, которое определяет производительность всей системы в графических задачах. При выборе стоит обращать внимание не только на цену, но и на ряд ключевых технических характеристик.

Ключевые характеристики: не только объем памяти

Объем видеопамяти — важный, но не единственный параметр. Часто производительность определяют другие характеристики:

- Тип и пропускная способность памяти: GDDR6X или GDDR7 работают быстрее старых стандартов.

- Ширина шины памяти: чем она шире (например, 256 или 384 бита), тем больше данных GPU обработает за один такт.

- Тактовые частоты: частота ядра и памяти напрямую влияет на скорость вычислений.

- Количество вычислительных блоков: число CUDA-ядер, тензорных ядер (для ИИ) и RT-ядер (для трассировки лучей).

Энергопотребление (TDP) и совместимость

Производительные GPU потребляют много энергии. Важно обратить внимание на показатель TDP (Thermal Design Power), который измеряется в ваттах. Убедитесь, что ваш блок питания (БП) имеет достаточную мощность с запасом и все необходимые разъемы для подключения видеокарты (например, 8-pin или 12-pin).

Программные технологии как фактор выбора

Производительность определяется не только «железом», но и программным обеспечением. Экосистема производителя играет большую роль. Технологии NVIDIA DLSS и AMD FSR повышают частоту кадров в играх за счет интеллектуального масштабирования. Технологии Reflex и Anti-Lag снижают задержку ввода, что важно в соревновательных играх. Для профессионалов важна поддержка специальных драйверов (NVIDIA Studio), которые оптимизированы для рабочих приложений.

Ключевые производители и их экосистемы

На рынке потребительских графических процессоров исторически доминируют два главных игрока, к которым недавно присоединился третий.

NVIDIA (серии GeForce, RTX)

Многолетний лидер рынка, NVIDIA известна своей архитектурой CUDA, которая широко используется для вычислений, и передовыми технологиями в играх. Серия RTX принесла в массы аппаратную трассировку лучей, а технология DLSS на базе искусственного интеллекта стала стандартом для повышения производительности.

AMD (серии Radeon, RX)

Главный конкурент NVIDIA, компания AMD предлагает производительные решения на архитектуре RDNA. Их технология масштабирования FSR является открытым стандартом, а значит, работает на видеокартах разных производителей. Видеокарты AMD часто предлагают привлекательное соотношение цены и производительности, особенно в среднем ценовом сегменте.

Intel (графика Arc и интегрированные решения Iris Xe)

Третий крупный игрок, вышедший на рынок дискретных GPU с серией Arc. Intel давно является лидером в области интегрированной графики (линейка Iris Xe), а теперь активно развивает и свои дискретные решения, создавая дополнительную конкуренцию на рынке.

Будущее графических процессоров

Развитие GPU не останавливается. В ближайшие годы нас ждут новые архитектурные решения и еще более широкое применение этих мощных вычислительных устройств.

Глубокая интеграция с CPU и гибридные чипы

Одной из главных тенденций является еще более тесная интеграция центрального и графического процессоров. Гибридные чипы (APU) и чиплетные архитектуры, где модули CPU и GPU расположены на одной подложке и соединены сверхбыстрой шиной (NVIDIA Grace Hopper), позволяют достичь максимальной скорости обмена данными и энергоэффективности.

Рост роли в AI, облаках и метавселенных

Будущий спрос на GPU будет все больше диктоваться не только играми, но и повсеместным внедрением искусственного интеллекта. Облачные сервисы, автономный транспорт, научные открытия и построение сложных виртуальных миров (метавселенных) требуют колоссальных вычислительных мощностей, и GPU находятся в центре этой революции.

Заключение: почему GPU стали неотъемлемой частью современных технологий

Графический процессор прошел долгий путь развития: от узкоспециализированного компонента для игр до универсального ускорителя вычислений. Роль и значение GPU в технологиях огромны. Его архитектура, изначально созданная для параллельной обработки графики, оказалась идеальным решением для революции в области искусственного интеллекта и анализа больших данных. Будущее обещает еще более тесную интеграцию GPU в нашу цифровую жизнь.

Часто задаваемые вопросы (FAQ)

Можно ли в ноутбуке заменить GPU?

В подавляющем большинстве случаев — нет. Графический чип в ноутбуках распаян непосредственно на материнской плате. Исключения крайне редки и дороги. Реальной альтернативой для повышения производительности является использование внешнего GPU (eGPU).

Что важнее для игр: процессор или видеокарта?

Для большинства современных игр видеокарта (GPU) оказывает гораздо большее влияние на производительность (FPS) и качество графики. Однако слабый процессор (CPU) может стать «бутылочным горлышком» и ограничивать потенциал даже самой мощной видеокарты, особенно в играх с открытым миром и сложной симуляцией.

Сколько видеопамяти (VRAM) нужно в 2025 году?

Комфортным минимумом для игр в разрешении 1080p является 8 ГБ. Для разрешения 1440p (2K) рекомендуется иметь 12–16 ГБ. Для 4K-гейминга на высоких настройках, а также для профессиональных задач, стоит ориентироваться на 16 ГБ и более.

Можно ли использовать компьютер без GPU?

Нет, для вывода изображения на монитор всегда требуется какой-либо графический процессор. Он может быть либо интегрирован в центральный процессор (CPU), либо представлен в виде дискретной видеокарты. Единственное исключение — серверы, работающие без графического интерфейса.

Как проверить, какой GPU установлен на моем ПК?

Самый простой способ в Windows: нажмите правой кнопкой мыши по меню «Пуск», выберите «Диспетчер устройств» и откройте раздел «Видеоадаптеры». Там будет указана модель вашего графического адаптера. Для более детальной информации можно использовать бесплатную утилиту GPU-Z.

Комментарии (0)

Новый комментарий

Новый комментарий отправлен на модерацию