InfiniBand — это стандарт высокопроизводительных сетей с архитектурой коммутируемой ткани, созданный для сверхбыстрого соединения серверов, систем хранения данных и вычислительных узлов. Ключевое преимущество — сверхнизкая задержка передачи данных, которая в десятки раз меньше, чем у традиционного Ethernet. Эту технологию применяют там, где каждая микросекунда имеет значение: в суперкомпьютерах (HPC), системах искусственного интеллекта (AI) и крупных центрах обработки данных.

Что такое технология InfiniBand простыми словами?

Чтобы понять, что такое InfiniBand, представьте его как выделенную трассу для обмена данными между мощными компьютерами, которая работает в обход общих дорог. Если обычная сеть Ethernet похожа на городскую улицу с пробками и светофорами, где данные обрабатываются ядром операционной системы и процессором, то InfiniBand — это прямой подземный туннель. Данные мчатся от точки А к точке Б без остановок.

Эта технология является ключевой для высокопроизводительных вычислений, поскольку обеспечивает прямое соединение между памятью разных серверов. Такой подход кардинально снижает задержки и освобождает центральный процессор от рутинных сетевых задач, позволяя ему сконцентрироваться на вычислениях.

Принцип работы и главные преимущества InfiniBand

В основе эффективности InfiniBand лежат два технологических столпа: механизм удаленного прямого доступа к памяти (RDMA) и архитектура коммутируемой ткани (Switched Fabric). Сочетание этих двух принципов обеспечивает сети уникальные характеристики производительности.

Секрет производительности: RDMA и архитектура "коммутируемой ткани"

RDMA (Remote Direct Memory Access) — это технология, которая позволяет одному компьютеру в сети читать данные из памяти другого или записывать их туда напрямую. Процесс происходит без участия операционных систем, центральных процессоров и кеш-памяти обоих устройств. Сетевой адаптер самостоятельно выполняет всю работу по передаче данных, что исключает промежуточные этапы копирования и связанные с ними задержки.

Архитектура коммутируемой ткани (Switched Fabric) обеспечивает надежную среду для работы RDMA. В отличие от Ethernet, где пакеты могут теряться и требуют повторной отправки, коммутационная ткань на основе InfiniBand гарантирует доставку пакетов без потерь. Это похоже на систему пневмопочты: каждый пакет отправляется по выделенному маршруту и гарантированно доходит до адресата. Такая надежность критически важна для RDMA, который ожидает упорядоченной и гарантированной доставки данных.

Ключевые преимущества

- Сверхнизкая задержка (Latency). Главное преимущество. Задержка в сети InfiniBand составляет менее одной микросекунды (sub-microsecond), в то время как у высокоскоростного Ethernet она измеряется десятками микросекунд. Как показывают исследования, представленные на Habr, в реальных системах задержка для малых сообщений достигает 0.8–1.1 мкс, что в 10-50 раз лучше Ethernet. Это критично для задач, где узлы кластера постоянно обмениваются небольшими порциями данных.

- Высокая пропускная способность (Bandwidth). Современные стандарты, такие как HDR (High Data Rate), обеспечивают скорость 200 Гбит/с на порт, а новое поколение NDR (Next Data Rate) — 400 Гбит/с. В разработке находятся решения на 800 Гбит/с и 1,6 Тбит/с.

- Разгрузка центрального процессора (CPU Offload). Благодаря RDMA сетевые операции почти не нагружают центральный процессор. Его ресурсы освобождаются для выполнения основных вычислительных задач, что повышает общую производительность системы.

- Масштабируемость. Архитектура позволяет строить огромные кластеры, состоящие из десятков тысяч узлов. Например, компания Meta использует кластер из 100 000 GPU, соединенных с помощью InfiniBand, для обучения своих ИИ-моделей. OpenAI для обучения GPT-4 задействовала 10 000 GPU в облаке Microsoft Azure с аналогичной сетевой инфраструктурой.

- Надежность и QoS. Встроенные механизмы контроля перегрузок и управления трафиком (QoS) гарантируют доставку данных без потерь и приоритизацию критически важного трафика. Сеть способна к самовосстановлению, автоматически перестраивая маршруты при сбое одного из каналов.

Где используется InfiniBand: основные сферы применения

Благодаря своим характеристикам InfiniBand стал стандартом де-факто в нескольких высокотехнологичных отраслях. Технологии InfiniBand используются повсеместно, где требуется максимальная производительность.

Высокопроизводительные вычисления (HPC) и научные исследования

Суперкомпьютеры, используемые для моделирования климата, разработки лекарств, геномных исследований и физических симуляций, состоят из тысяч вычислительных узлов. InfiniBand связывает их в единый организм, обеспечивая быструю и синхронную работу.

Искусственный интеллект и машинное обучение (AI/ML)

Обучение крупных нейросетей, таких как языковые модели, требует параллельной работы тысяч графических процессоров (GPU). Технология `GPUDirect RDMA` позволяет GPU обмениваться данными напрямую через сеть InfiniBand, минуя центральный процессор, что кратно ускоряет процесс обучения.

Крупные центры обработки данных (ЦОД) и облачные провайдеры

В крупных ЦОД InfiniBand используется для создания высокоскоростных соединений между серверами и системами хранения данных. Это позволяет ускорить работу баз данных, приложений для анализа больших данных (Big Data) и виртуализированных сред.

Системы хранения данных (Storage) и Big Data

InfiniBand обеспечивает сверхбыстрый доступ к распределенным файловым системам и объектным хранилищам. Это позволяет аналитическим платформам обрабатывать огромные массивы данных в режиме реального времени без "узких мест" на этапе доступа к данным. Технология InfiniBand также может применяться для построения сетей хранения поверх IP (IPoIB).

Сравнение InfiniBand и Ethernet

Хотя современные стандарты высокоскоростного Ethernet (200/400G) догнали InfiniBand по показателям пропускной способности, ключевые различия в архитектуре сохраняются. Основным конкурентом InfiniBand выступает не офисный Ethernet, а технология RoCE (RDMA over Converged Ethernet), которая переносит преимущества RDMA в привычную Ethernet-среду. Однако, как показывает практика, даже с RoCE задержка Ethernet остается на уровне 2–10 микросекунд против значений менее 1 микросекунды у InfiniBand.

| Параметр | InfiniBand | High-Speed Ethernet (с RoCE) |

|---|---|---|

| Основная технология | Нативная аппаратная поддержка RDMA | RDMA поверх сети Ethernet (RoCE) |

| Задержка (Latency) | Сверхнизкая (от 90 наносекунд до ~1 мкс) | Низкая, но выше (обычно 2–10 мкс) |

| Пропускная способность | До 400 Гбит/с (NDR), в разработке 800/1600 Гбит/с | До 400 Гбит/с, в разработке 800/1600 Гбит/с |

| Топология | Коммутируемая ткань (Switched Fabric), Fat Tree | Spine-leaf, более универсальные топологии |

| Управление перегрузками | Встроенные аппаратные механизмы, сеть без потерь | Зависит от протоколов, требует сложной настройки (PFC) |

| Основная область применения | HPC, AI-кластеры, задачи с критической задержкой | Универсальные ЦОД, облака, корпоративные сети |

| Стоимость развертывания | Высокая (специализированное оборудование) | Ниже (более массовый рынок и стандарты) |

| Поддержка RDMA | Полная, нативная, максимальная эффективность | Через RoCE, производительность зависит от реализации |

Детальные спецификации технологий разрабатываются и поддерживаются профильными организациями. За стандарт InfiniBand отвечает InfiniBand Trade Association (IBTA), а за Ethernet — институт IEEE.

Когда выбирать InfiniBand, а когда — Ethernet?

Выбирайте InfiniBand, если ваша задача абсолютно нетерпима к задержкам. Это тренировка гигантских ИИ-моделей, сложные научные симуляции или высокочастотная финансовая торговля. Здесь каждый сэкономленный такт процессора и каждая микросекунда задержки напрямую влияют на результат.

Выбирайте Ethernet (с поддержкой RoCE), если вы строите универсальный ЦОД, где важна совместимость с существующей IP-инфраструктурой, унификация оборудования и более низкая стоимость развертывания. Для многих задач производительности RoCE будет достаточно, однако он не обеспечивает такой же предсказуемости и гарантий, как InfiniBand.

Архитектура, стандарты и уровни InfiniBand

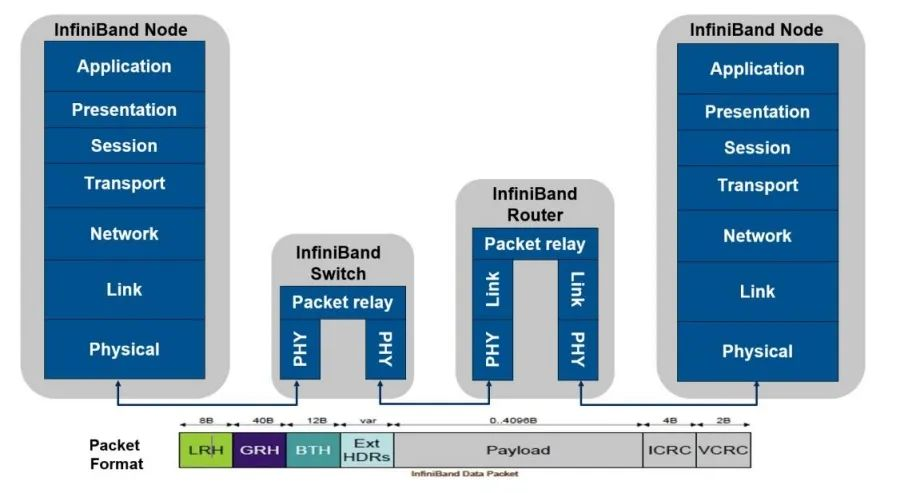

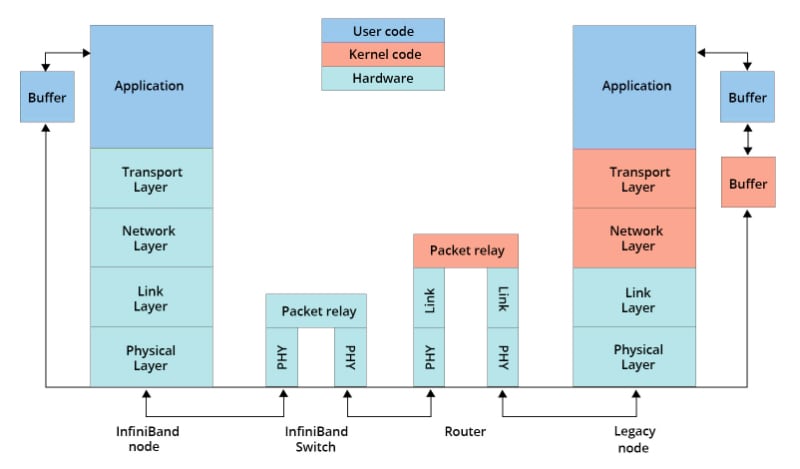

Архитектура InfiniBand, подобно модели OSI, имеет многоуровневую структуру, где каждый уровень выполняет свою функцию — от физической передачи сигнала до работы приложений. Вся архитектура построена на основе InfiniBand.

Пять уровней архитектуры InfiniBand

- Физический уровень. Определяет типы кабелей (медь, оптика), разъемы, скорости передачи сигналов и электрические характеристики.

- Канальный уровень. Отвечает за формирование пакетов данных, управление потоком и создание виртуальных каналов для разделения трафика. Именно здесь работает механизм, гарантирующий доставку без потерь.

- Сетевой уровень. Обеспечивает маршрутизацию пакетов внутри одной подсети InfiniBand (Subnet) с помощью коммутаторов и маршрутизаторов InfiniBand, используя локальные идентификаторы (LID).

- Транспортный уровень. Гарантирует сквозную доставку данных между приложениями на разных узлах. Он управляет очередями и реализует механизмы RDMA.

- Верхний уровень (Upper-Layer Protocols). Набор протоколов, которые позволяют стандартным приложениям работать поверх InfiniBand. Сюда входят IPoIB (IP-over-InfiniBand), SDP (Sockets Direct Protocol) и другие.

Топологии сети: от Fat Tree до Dragonfly

Для построения кластеров на базе InfiniBand чаще всего используют специализированные топологии, которые обеспечивают одинаковую пропускную способность между любыми двумя узлами. Самая популярная — Fat Tree («Толстое дерево»). В этой топологии пропускная способность каналов увеличивается по мере приближения к "корню" дерева, что исключает появление узких мест. Для сверхкрупных суперкомпьютеров также применяют топологию Dragonfly.

Производительность и поколения InfiniBand: от SDR до NDR

История InfiniBand — это история непрерывного роста скоростей и снижения задержек. Каждое новое поколение удваивало производительность.

Эволюция скоростей: SDR, DDR, QDR, FDR, EDR, HDR, NDR

Названия поколений обозначают скорость передачи данных: Single Data Rate (SDR), Double (DDR), Quad (QDR), Fourteen (FDR), Enhanced (EDR), High (HDR) и Next Data Rate (NDR). Каждое поколение обеспечивало кратный рост пропускной способности, особенно в распространенной конфигурации InfiniBand 4x, где используется четыре линии передачи данных.

| Название | Год | Пропускная способность на линию | Общая пропускная способность (x4) |

|---|---|---|---|

| SDR | ~2002 | 2.5 Гбит/с | 10 Гбит/с |

| DDR | ~2005 | 5 Гбит/с | 20 Гбит/с |

| QDR | ~2008 | 10 Гбит/с | 40 Гбит/с |

| FDR | ~2013 | 14 Гбит/с | 56 Гбит/с |

| EDR | ~2016 | 25 Гбит/с | 100 Гбит/с |

| HDR | 2017 | 50 Гбит/с | 200 Гбит/с |

| NDR | 2024 | 100 Гбит/с | 400 Гбит/с |

Латентность (задержка) как главный показатель эффективности

В мире HPC и AI именно задержка, а не чистая пропускная способность, часто является определяющим фактором. Представьте конвейер на заводе. Можно сделать ленту конвейера сколь угодно широкой (пропускная способность), но если детали передаются между рабочими с задержкой, весь процесс будет тормозиться. InfiniBand минимизирует эту задержку до значений менее микросекунды, обеспечивая слаженную работу тысяч "рабочих" (процессоров или GPU).

Основные компоненты сети InfiniBand

Сеть InfiniBand состоит из трех ключевых типов оборудования.

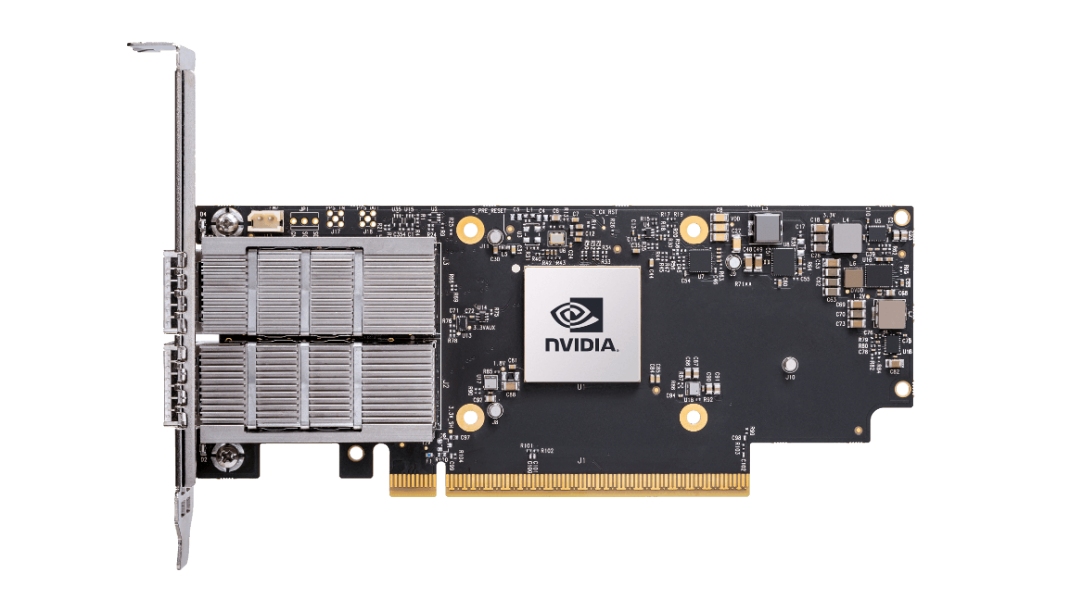

Сетевые адаптеры (HCA) и блоки обработки данных (DPU)

Хост-адаптеры (HCA, Host Channel Adapters) — это сетевые карты, которые устанавливаются в серверы. Именно они реализуют всю магию RDMA и обеспечивают прямое подключение узла к коммутационной ткани. Современные адаптеры, такие как NVIDIA ConnectX, являются программируемыми устройствами (DPU, Data Processing Unit), способными выполнять часть сетевых задач и задач безопасности самостоятельно.

Коммутаторы (Switches)

Коммутаторы InfiniBand (Switches) — это узлы коммутационной ткани. Они соединяют все HCA в единую сеть и отвечают за интеллектуальную маршрутизацию пакетов с минимальной задержкой. В отличие от Ethernet-коммутаторов, они спроектированы для работы в сети без потерь. Работа с коммутатором InfiniBand требует специальных знаний для настройки топологии и управления трафиком.

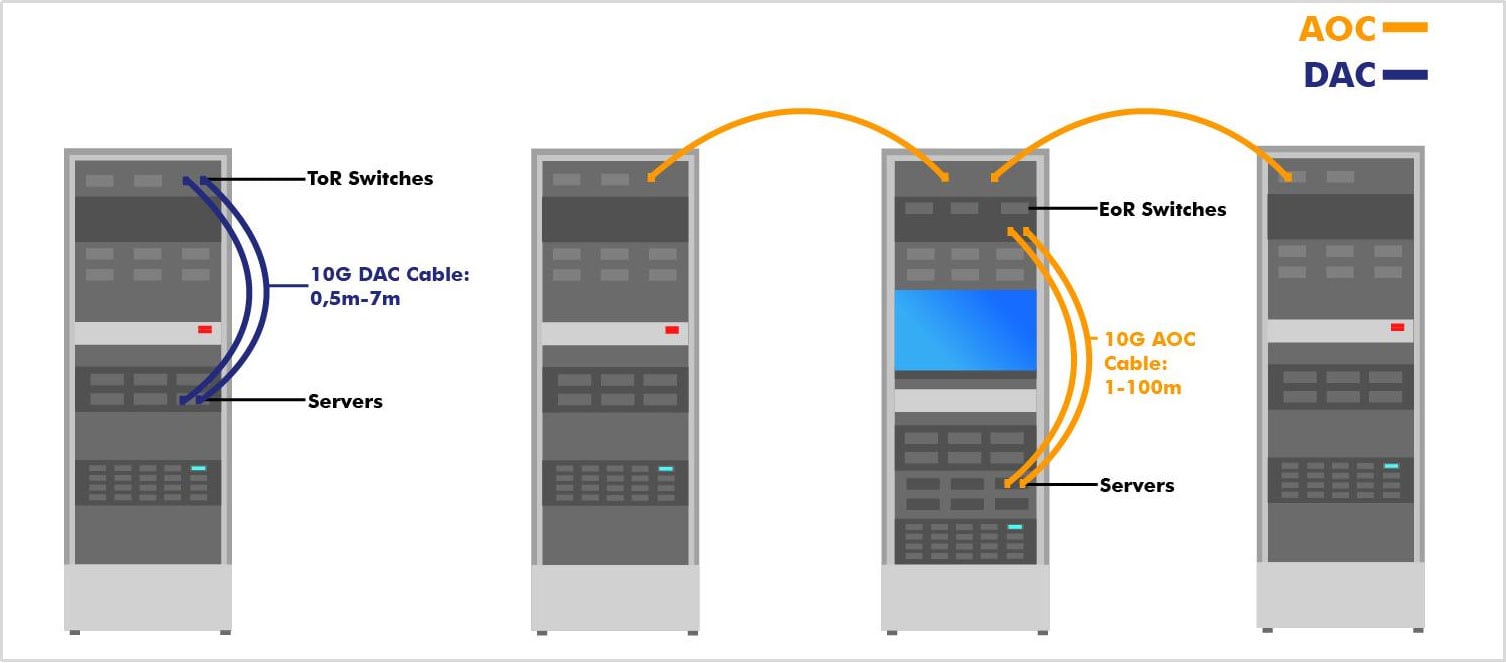

Кабели и трансиверы

Соединение компонентов осуществляется с помощью медных (DAC) или оптических (AOC) кабелей.

- Медные кабели (DAC, Direct Attach Copper) используются для коротких соединений в пределах одной серверной стойки (до 5-7 метров). Они дешевле и энергоэффективнее.

- Активные оптические кабели (AOC, Active Optical Cable) применяются для соединений на большие расстояния (до сотен метров), например, между стойками.

Программная составляющая (Software Stack)

Для работы сети InfiniBand требуется специализированное программное обеспечение.

Драйверы и дистрибутивы: MLNX_OFED

Основным программным пакетом является MLNX_OFED (OpenFabrics Enterprise Distribution) от NVIDIA. Это комплексный набор драйверов, библиотек и утилит для Linux и Windows, который обеспечивает работу адаптеров и предоставляет API для приложений.

Библиотеки и API: Magnum IO

Для разработчиков высокопроизводительных приложений существуют специализированные библиотеки, такие как NVIDIA Magnum IO. Они предоставляют оптимизированные инструменты для работы с RDMA, GPUDirect и другими технологиями, позволяя получить максимум от аппаратного обеспечения.

Управление и мониторинг: UFM (Unified Fabric Manager)

Управление большой сетью InfiniBand осуществляется с помощью систем вроде NVIDIA UFM (Unified Fabric Manager). Эта платформа позволяет в реальном времени отслеживать состояние сети, оптимизировать маршруты, обнаруживать проблемы и управлять производительностью всего кластера.

Частые ошибки при внедрении InfiniBand и как их избежать

Несмотря на технологическое совершенство, неправильное внедрение InfiniBand способно свести на нет все его преимущества.

Ошибка №1. Неправильный выбор топологии для задачи

Попытка построить большую сеть на простой топологии (например, "звезда") приведет к появлению узких мест у центрального коммутатора. Для кластеров необходимо с самого начала проектировать масштабируемые топологии вроде Fat Tree.

Ошибка №2. Экономия на кабелях и физическом соединении

Использование некачественных или поврежденных кабелей — одна из главных причин деградации производительности сети. Малейший дефект в разъеме или перегиб кабеля может привести к увеличению ошибок и, как следствие, к снижению пропускной способности. Кабельная инфраструктура должна быть безупречной.

Ошибка №3. Недооценка важности программной настройки (тюнинга)

Установка драйверов «по умолчанию» редко дает максимальную производительность. Для достижения сверхнизких задержек требуется тонкая настройка параметров BIOS, операционной системы и самих драйверов. Отключение энергосберегающих режимов процессора, правильная настройка прерываний и буферов могут дать значительный прирост производительности.

Будущее технологии и заключение

Текущие тенденции: 800G/1.6T, интеграция с кремниевой фотоникой и In-Network Computing

Развитие InfiniBand не останавливается. На рынке уже появляются решения на 800 Гбит/с, и в ближайшие годы ожидается стандарт на 1,6 Тбит/с. Ключевой технологией становится кремниевая фотоника, которая позволяет интегрировать оптические компоненты прямо в чип, снижая энергопотребление и стоимость.

Другой важный тренд — In-Network Computing (вычисления внутри сети). Коммутаторы становятся умнее и берут на себя часть вычислительных задач, например, агрегацию данных от множества узлов (операции All-Reduce), что еще больше разгружает центральные процессоры.

Выводы: кому и зачем нужен InfiniBand сегодня

В 2025 году InfiniBand — это не нишевая технология, а индустриальный стандарт для построения самых производительных вычислительных систем в мире. Он необходим компаниям и научным организациям, которые работают на переднем крае технологий:

- Разработчикам искусственного интеллекта.

- Суперкомпьютерным центрам.

- Крупным облачным провайдерам.

- Финансовым организациям, занимающимся высокочастотной торговлей.

Если ваша задача требует предельно низких задержек и максимальной скорости обмена данными между десятками, сотнями или тысячами узлов, альтернативы InfiniBand сегодня практически не существует. Однако InfiniBand не является панацеей для всех подряд.

Часто задаваемые вопросы (FAQ)

Что такое RoCE и как он связан с InfiniBand?

RoCE (RDMA over Converged Ethernet) — это протокол, который позволяет передавать трафик RDMA поверх сетей Ethernet. Это попытка получить преимущества InfiniBand (низкую задержку и разгрузку ЦП) на более распространенном и дешевом оборудовании Ethernet. Однако RoCE требует сложной настройки сети для обеспечения работы без потерь и по показателям задержки все же уступает нативному InfiniBand.

Можно ли использовать InfiniBand для построения обычной офисной или домашней сети?

Теоретически да, но это нецелесообразно. Это как использовать болид Формулы-1 для поездок в магазин. Стоимость оборудования (адаптеры, коммутаторы, кабели) в разы выше, чем у Ethernet, а сложность настройки требует высокой квалификации. Для офисных и домашних задач производительность InfiniBand является избыточной.

Насколько сложно управлять сетью InfiniBand по сравнению с Ethernet?

Управлять сетью InfiniBand сложнее. Архитектура требует понимания специфических концепций: диспетчер подсети (Subnet Manager), виртуальные каналы, управление перегрузками. В то время как Ethernet-сети в значительной степени работают по принципу "включил и забыл", InfiniBand требует целенаправленного проектирования и администрирования для достижения пиковой производительности.

Что такое In-Network Computing и Self-Healing Network?

In-Network Computing — это выполнение части вычислений непосредственно на сетевых коммутаторах. Это позволяет уменьшить объем трафика и снизить задержки. Self-Healing Network (самовосстанавливающаяся сеть) — это способность сети InfiniBand автоматически обнаруживать сбои (например, обрыв кабеля) и мгновенно перестраивать маршруты трафика в обход неисправного участка, обеспечивая бесперебойную работу.

Комментарии (0)

Новый комментарий

Новый комментарий отправлен на модерацию