Статья помогает тем, кто впервые сталкивается с Kubernetes и ищет понятный ответ на вопрос, что такое Kubernetes простыми словами: начинающим разработчикам, DevOps-инженерам, SRE, тимлидам и владельцам продуктов, которые принимают решения об инфраструктуре. Материал объясняет основы платформы, её архитектуру, преимущества и сферы применения в 2025 году без лишних технических деталей, но без упрощений, искажая суть.

Kubernetes: что это такое простыми словами

Kubernetes — это открытая платформа оркестрации контейнеров, которая автоматически запускает, масштабирует и поддерживает контейнеризированные приложения в кластере серверов. Система принимает описание того, как должны выглядеть современные приложения, и сама приводит фактическое состояние кластера к этому описанию. Для читателя это платформа для приложений, которая берёт на себя рутину: старт, перезапуск и распределение нагрузки между контейнерами. Такое определение по сути отвечает на запрос, что такое Kubernetes и как объяснить его простыми словами для начинающих.

В индустрии Kubernetes рассматривается как базовый инструмент для управления контейнеризированными приложениями. Официальная документация описывает его как «портативную и расширяемую платформу с открытым исходным кодом для управления контейнеризованными рабочими нагрузками и сервисами», которая облегчает декларативную настройку и автоматизацию. Платформа помогает держать под контролем десятки и сотни сервисов, не погружаясь в состояние каждого контейнера вручную и не отслеживая по отдельности работу всех экземпляров.

Kubernetes тесно связан с контейнерами и микросервисами. Контейнеры упаковывают отдельные части приложения в изолированные среды, а Kubernetes управляет ими как единой системой: распределяет поды по узлам, следит за здоровьем, выполняет обновления без простоя. Для микросервисной архитектуры это удобная среда, где каждому микросервису соответствует один или несколько подов, а платформа управляет их масштабированием, количеством контейнеров и сетевым взаимодействием.

Происхождение и значение названия Kubernetes

Название Kubernetes происходит от древнегреческого слова κυβερνήτης (kubernḗtēs), которое переводится как «кормчий» или «рулевой» корабля. Этот образ подчёркивает роль системы: направлять «корабль» распределённого приложения через сложную инфраструктуру и нагрузки. Вопрос о том, почему именно такое название Kubernetes, часто возникает у тех, кто только знакомится с технологией, и история имени помогает легче запомнить бренд.

Логотип Kubernetes изображает корабельный штурвал с семью рукоятками. Семёрка отсылает к первоначальному названию проекта Project Seven и к героине Star Trek Seven of Nine, вернувшейся из коллективного разума к индивидуальности. Штурвал символизирует управление курсом, а платформа действительно «рулит» кластерами контейнеров, автоматизируя запуск, масштабирование и восстановление сервисов.

Зачем нужен Kubernetes

Kubernetes решает проблему управления большим числом контейнеров и микросервисов. Когда сервисов немного, достаточно запускать контейнеры вручную или через простой скрипт. Как только появляются десятки и сотни компонентов, ручное управление превращается в хаос: контейнеры запускаются на разных серверах, часть из них падает, версии расходятся, масштабирование занимает часы.

Контейнеры и микросервисы стали нормой для современных приложений: каждый сервис работает отдельно, обновляется независимо и масштабируется по-своему. Без единой системы оркестрации команды тратят значительную часть времени на запуск, перезапуск и перенос контейнеров, а не на разработку. Любой пик нагрузки вызывает ручную «раскрутку» дополнительных инстансов и риск ошибок, особенно когда речь идёт о большом числе контейнеров, развёрнутых на разных узлах.

Kubernetes вводит единый центр управления. Платформа:

- автоматически размещает поды на подходящих узлах;

- перезапускает контейнеры при сбоях и перемещает их при падении узла;

- увеличивает или уменьшает число реплик при изменении нагрузки;

- обновляет приложения пошагово, без одновременного выключения всех экземпляров.

Cloud Native Computing Foundation в ежегодных обзорах отмечает, что Kubernetes стал стандартной основой для cloud-native-систем: свыше 90% крупных организаций используют его в production-сценариях CNCF Cloud Native Survey 2024. Рост популярности Kubernetes поддерживают и аналитические компании, такие как Gartner, которые фиксируют переход корпоративных нагрузок на контейнеризированные приложения и платформы вроде Kubernetes.

Основные задачи Kubernetes: управление контейнерами и приложениями

Kubernetes решает ключевые операционные задачи при работе с контейнеризированными приложениями. Система управляет контейнерами и конфигурацией, распределяет нагрузку и автоматизирует рутинные операции, чтобы инфраструктура не требовала постоянного ручного вмешательства. По сути это ядро системы оркестрации, которое приводит в порядок управление контейнерами для множества сервисов.

Основные задачи Kubernetes:

- управление контейнерами: запуск, остановка и автоматический перезапуск подов при ошибках;

- управление приложениями и конфигурацией: хранение манифестов, конфигов и секретов, применение изменений по одному описанию;

- распределение нагрузки: балансировка трафика на уровне Service и сетевых прокси, равномерное использование ресурсов;

- обеспечение отказоустойчивости: замена подов и перенос рабочих нагрузок при сбое узлов;

- автоматизация работы системы: поддержание желаемого состояния, масштабирование по метрикам, планирование размещения подов.

По сути Kubernetes выступает операционной системой для кластера: принимает задания на запуск приложений и следит за тем, чтобы они выполнялись в нужном объёме.

Таблица ниже помогает связать задачи платформы с практической выгодой для команд.

| Задача Kubernetes | Что делает | Польза для команды |

|---|---|---|

| Управление состоянием (desired state) | Поддерживает желаемое состояние объектов, автоматически создаёт, перезапускает или удаляет поды | Стабильность приложений и отсутствие ручного контроля каждой реплики |

| Автоматическое масштабирование | Изменяет количество реплик и узлов на основе метрик нагрузки | Реакция на пики без ручного вмешательства и экономия ресурсов в периоды спада |

| Самовосстановление | Проверяет здоровье контейнеров и перезапускает или заменяет сбойные экземпляры | Сокращение простоев и повышение доступности сервисов |

| Распределение и балансировка нагрузки | Маршрутизирует трафик к подам и балансирует запросы через Service и kube-proxy | Равномерная загрузка и устойчивый доступ к сервисам |

| Планирование (scheduler) | Выбирает узлы для запуска подов с учётом ресурсов и ограничений | Эффективное использование ресурсов кластера и соблюдение политик размещения |

| Оркестрация хранения (volumes) | Монтирует и управляет томами для подов, в том числе облачными и сетевыми | Упрощение работы с состоянием и переносимость рабочих нагрузок |

| Управление конфигурациями и секретами | Хранит конфигурации и секреты, подаёт их подам через переменные среды или тома | Централизованное управление настройками и повышение безопасности |

| Сетевое взаимодействие и политики | Настраивает маршрутизацию и ограничения трафика между подами с помощью CNI и NetworkPolicy | Контроль сетевого трафика и предсказуемое сетевое поведение приложений |

| Централизованный API и расширяемость | Предоставляет единый API для управления кластером и интеграции операторов | Единая точка автоматизации и интеграции с CI/CD и внешними системами |

| Контроллеры и контрол-менеджер | Отслеживают состояние объектов и выполняют корректирующие действия | Автоматизация рутинных операций и поддержание целостности ресурсов |

| RBAC и безопасность доступа | Управляет ролями и правами доступа к API кластера | Ограничение прав и соответствие требованиям безопасности |

| Портируемость между инфраструктурами | Абстрагирует инфраструктуру и интегрируется с облачными драйверами и системами хранения | Снижение привязки к одному провайдеру и упрощение миграций |

| Логирование и мониторинг (через экосистему) | Интегрируется с Prometheus, EFK-стеком и другими инструментами наблюдаемости | Возможность наблюдать состояние приложений и оперативно реагировать на инциденты |

Kubernetes vs Docker

Docker и Kubernetes решают разные, но дополняющие друг друга задачи. Docker предоставляет формат образов контейнеров и среду выполнения на одном хосте. Он упаковывает приложение в образ, из которого запускается контейнер, и обеспечивает изоляцию процессов на конкретном сервере, где администратор вручную контролирует количество контейнеров.

Kubernetes, напротив, управляет множеством контейнеров на множестве серверов. Платформа принимает образы (часто именно Docker-совместимые) и создаёт из них поды, распределяет их по узлам, контролирует число экземпляров и маршрутизирует к ним трафик. Таким образом, Docker решает задачу упаковки и запуска отдельного контейнера, а Kubernetes — задачу оркестрации контейнеров в масштабе кластера и управления приложениями как целым.

Технологии не конкурируют, а работают совместно. Docker остаётся стандартным инструментом для создания образов и локальной разработки, тогда как Kubernetes используется как платформа для управления приложениями в тестовых и продукционных средах. Во многих кластерах вместо Docker в роли runtime используется containerd или CRI-O, но формат образов и принципы остаются прежними, и это не мешает использованию Kubernetes как основной платформы для приложений.

| Критерий | Docker | Kubernetes |

|---|---|---|

| Роль | Контейнерная среда выполнения: создание и запуск отдельных контейнеров | Платформа оркестрации контейнеров: управление кластерами и рабочими нагрузками |

| Что делает | Упаковывает приложение в образ, изолирует процессы, запускает контейнеры на одном сервере | Запускает множество подов, масштабирует, балансирует трафик, обеспечивает самовосстановление |

| Уровень абстракции | Низкий, работа с отдельными контейнерами | Более высокий, управление приложениями и сервисами как целостной системой |

| Где используется | Небольшие приложения, разработка и тестирование, простые развертывания | Микросервисы, крупные web-системы, enterprise-нагрузки, managed-кластеры в облаках |

| Использование отдельно | Возможен отдельный запуск контейнеров без оркестрации | Возможен самостоятельный кластер, но почти всегда совместно с контейнерным runtime |

Основы Kubernetes: что нужно знать для работы с Kubernetes

Для уверенной работы с Kubernetes достаточно освоить несколько базовых понятий. Эти сущности встречаются в любой конфигурации. Такое знание Kubernetes даёт опору для следующих шагов.

Ключевые элементы:

- Кластер — группа серверов (узлов), объединённая в единую систему для запуска контейнеризированных приложений.

- Узел (node) — отдельный физический сервер или виртуальная машина, на которой работают поды и системные компоненты.

- Pod — минимальная единица развертывания, включающая один или несколько контейнеров, которые всегда запускаются и останавливаются вместе.

- Deployment — объект, который управляет набором подов, следит за количеством реплик и выполняет обновления.

- Service — стабильная точка доступа к набору подов с балансировкой трафика между ними.

- Namespace — логическое разделение кластера на независимые пространства для разных проектов и команд.

- ConfigMap и Secret — объекты для хранения конфигураций и секретных данных, которые подаются в поды.

Базовые основы Kubernetes сводятся к пониманию этих сущностей и их связей.

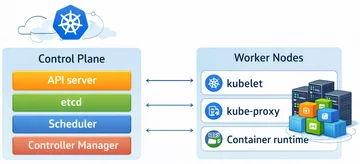

Архитектура Kubernetes: кластер и основные компоненты системы

Кластер Kubernetes состоит из двух основных частей: control plane и рабочих узлов. Control plane управляет состоянием системы, принимает решения о размещении подов и хранит конфигурацию. Рабочие узлы выполняют поды с контейнерами и обеспечивают сетевое взаимодействие, превращая декларативное описание в реальную работу системы оркестрации.

Компоненты Kubernetes вместе обеспечивают работу системы:

- kube-apiserver — центральный API-сервер, который принимает все запросы и является «фасадом» кластера;

- etcd — распределённое хранилище ключ-значение для состояния кластера;

- kube-scheduler — планировщик, который выбирает узлы для запуска новых подов;

- kube-controller-manager — набор контроллеров, которые следят за соответствием текущего состояния желаемому;

- kubelet — агент на каждом узле, управляющий жизненным циклом подов и контейнеров;

- kube-proxy — сетевой прокси для реализации сервисов и правил маршрутизации;

- контейнерный runtime (containerd, CRI-O и др.) — компонент, который запускает и останавливает контейнеры по инструкциям kubelet.

Документация Kubernetes описывает эту архитектуру как основу декларативной модели: пользователи описывают состояние, а компоненты кластера бесконечно приводят систему к этому состоянию «What is Kubernetes» в официальной документации.

Кластер Kubernetes: control plane и рабочие узлы

Кластер Kubernetes работает как единая логическая система: control plane принимает решения, а рабочие узлы выполняют их. Control plane хранит желаемое состояние в etcd, принимает запросы через API-сервер и запускает контроллеры и планировщик. Рабочие узлы получают указания через kubelet и запускают поды с контейнерами, обеспечивая выполнение приложений и фактический запуск приложений на реальных серверах.

Аналогия помогает зафиксировать различие ролей: control plane похож на центр управления полётами, а рабочие узлы — на самолёты. Центр принимает решения о маршрутах, расписании и реагирует на нештатные ситуации, самолёты выполняют полёты по этим решениям. В кластере Kubernetes такая схема помогает держать под контролем всю систему, даже если какой-то узел или запущенное приложение выходит из строя.

Основные компоненты control plane

Control plane включает несколько ключевых компонентов, каждый из которых влияет на стабильность работы кластера:

- API-сервер — центральная точка взаимодействия: принимает все запросы к кластеру, валидирует и сохраняет объекты. Без него кластер теряет координацию.

- etcd — хранилище состояния в формате ключ-значение. От его надёжности зависит целостность конфигурации и возможность восстановить кластер.

- Scheduler — планировщик, который выбирает узлы для запуска подов с учётом ресурсов и ограничений. Его работа влияет на баланс нагрузки и эффективность использования инфраструктуры.

- Controller Manager — запускает контроллеры, которые следят за тем, чтобы текущее состояние совпадало с желаемым: количество реплик, состав endpoints и так далее. При его сбое состояние начинает «плыть».

Таблица помогает структурировать информацию о компонентах control plane.

| Компонент | Назначение | Уровень сложности для новичка |

|---|---|---|

| kube-apiserver | HTTP API Kubernetes, центральная точка входа и валидации запросов | Средний |

| etcd | Распределённое хранилище состояния кластера | Высокий |

| kube-scheduler | Назначает поды на подходящие узлы на основе ресурсов и политик | Средний |

| kube-controller-manager | Запускает контроллеры, поддерживающие желаемое состояние объектов | Средний |

| cloud-controller-manager | Интегрирует кластер с облачными провайдерами (балансировщики, тома и другие ресурсы) | Высокий |

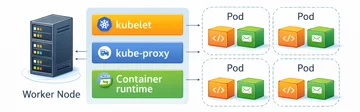

Компоненты рабочих узлов

На каждом рабочем узле работают компоненты, которые обеспечивают запуск подов и сетевое взаимодействие:

- kubelet — агент, который получает от API-сервера описание подов, запускает контейнеры через runtime и отслеживает их состояние. Отвечает за фактический запуск приложений на узле и рутинную работу с контейнерами.

- kube-proxy — компонент, который настраивает сетевые правила и перенаправляет трафик к подам через объекты Service. Обеспечивает сетевую доступность приложений.

- контейнерный runtime (containerd, CRI-O, Docker) — среда выполнения контейнеров: загружает образы, создаёт контейнеры и управляет их жизненным циклом по командам kubelet. По сути именно runtime выполняет работу контейнеров на узле.

Как Kubernetes работает с контейнерами: образа контейнера и управление числом контейнеров

Работа Kubernetes с контейнерами строится вокруг образов и описания желаемого состояния. Для каждого приложения задаётся один образ контейнера в шаблоне pod внутри Deployment или другого контроллера. В манифесте указывается число реплик: сколько подов с этим образом контейнера нужно запустить в кластер.

Контроллеры в составе kube-controller-manager следят за тем, чтобы фактическое количество подов совпадало с указанным в манифесте. Если под падает, Kubernetes создаёт новый. Если число реплик увеличено, платформа запускает дополнительные поды. Так Kubernetes контролирует не только число подов, но и суммарное количество контейнеров, в которых крутится код приложения. При уменьшении реплик лишние поды аккуратно останавливаются.

Основные операции с контейнерами в Kubernetes:

- запуск — создание подов по манифесту и размещение их на узлах;

- масштабирование — изменение числа реплик вручную или через автоскейлер;

- перезапуск — автоматический старт новых экземпляров при сбоях;

- обновление — поэтапная замена подов на новую версию образа (rolling update).

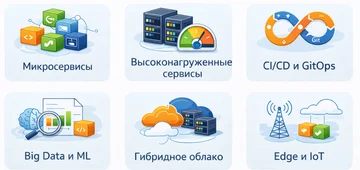

Использование и применения Kubernetes для современных приложений и работы с контейнерами

Kubernetes особенно полезен для современных контейнеризированных приложений, где требуется гибкость и масштабируемость. Платформа используется как общая основа для самых разных сценариев, от классических web-сервисов до систем машинного обучения. Типичное использование Kubernetes охватывает ситуации, где нужно держать под контролем разнородные сервисы и большое количество контейнеров.

Основные применения Kubernetes:

- микросервисы и web-приложения — запуск множества небольших сервисов с независимыми релизами и балансировкой трафика;

- высоконагруженные и масштабируемые сервисы — автоматическое увеличение числа реплик при пиках и снижение нагрузки на отдельные узлы;

- CI/CD и GitOps-подходы — использование кластера как стандартной среды для автоматической доставки и обновления приложений;

- системы обработки данных (Big Data, ML, потоковая обработка) — планирование распределённых задач, управление ресурсами CPU и GPU;

- гибридные и мультиоблачные сценарии — перенос рабочих нагрузок между облаками и on-prem-инфраструктурой;

- edge-и IoT-сценарии — управление контейнеризированными сервисами на периферийных узлах и устройствах.

Кому и когда стоит использовать Kubernetes

Kubernetes оправдан для команд, которые работают с множеством сервисов и серьёзными требованиями к надёжности. В первую очередь это DevOps-инженеры и SRE, отвечающие за стабильность и масштабирование распределённых систем. Разработчики микросервисов и платформенные команды используют Kubernetes как стандартную среду для тестирования и продакшн-запуска.

Платформа особенно полезна:

- растущим стартапам с увеличивающейся нагрузкой и многими сервисами;

- крупным компаниям с требованиями к SLA и отказоустойчивости;

- организациям с гибридной инфраструктурой и несколькими облаками;

- проектам с ML/AI-нагрузками, где нужна работа с GPU и сложными пайплайнами.

В то же время для простых лендингов, небольших внутренних сервисов и приложений без серьёзных требований к масштабируемости Kubernetes часто избыточен. В подобных случаях проще использовать PaaS-решения, serverless-функции или одиночные контейнеры без оркестратора. Для таких сценариев управление приложениями через лёгкие PaaS-интерфейсы снижает стоимость поддержки.

Краткий чек-лист:

- много независимых сервисов;

- жёсткие требования к доступности и времени восстановления;

- переменная или пиковая нагрузка;

- потребность в переносимости между облаками и on-prem;

- готовность инвестировать в DevOps-экспертизу.

Если большинство пунктов выполняется, использование Kubernetes даёт ощутимую выгоду.

Главные преимущества Kubernetes

Kubernetes стал стандартной платформой для контейнеризированных приложений благодаря сочетанию нескольких ключевых преимуществ. Они напрямую влияют на эксплуатацию систем и затраты на инфраструктуру.

Основные преимущества:

- самовосстановление: при сбое контейнера или узла Kubernetes перезапускает поды и переносит рабочие нагрузки на здоровые узлы;

- автоматическое масштабирование: платформа изменяет число реплик на основе метрик CPU, памяти или пользовательских показателей, отключая лишние ресурсы при снижении нагрузки;

- балансировка нагрузки: Service и сетевые плагины равномерно распределяют запросы между подами, поддерживая стабильное время отклика;

- автоматизация развертывания и обновлений: rolling updates и откаты позволяют обновлять приложения без простоев;

- абстракция от инфраструктуры: приложения описываются декларативно и не зависят от конкретного сервера или облака;

- портируемость: кластер можно развернуть в разных облаках и в собственном дата-центре, сохраняя общий API;

- оптимизация использования ресурсов: scheduler учитывает ресурсы узлов и размещает поды так, чтобы избежать простаивания и перегрузок.

Сравнение эксплуатации приложений без Kubernetes и с Kubernetes иллюстрирует эти эффекты.

| Аспект | Без Kubernetes | С Kubernetes |

|---|---|---|

| Управляемость | Отдельные сервера и контейнеры, ручные операции | Централизованное управление кластерами и приложениями через единый API |

| Отказоустойчивость | Требуются скрипты и дополнительные механизмы | Встроенное самовосстановление и миграция подов при сбоях узлов |

| Масштабирование | Масштабирование контейнеров и серверов вручную | Автоматическое масштабирование по метрикам и политикам |

| Обновления | Обновления с простоем или сложными скриптами | Rolling-обновления, откаты и поэтапная замена экземпляров без полной остановки |

Популярность Kubernetes

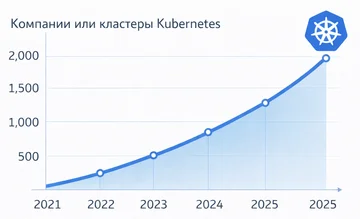

Kubernetes закрепил позицию стандарта для контейнеризированных приложений благодаря широкому принятию в индустрии и сильному сообществу. Cloud Native Computing Foundation в отчётах 2024–2025 годов фиксирует, что подавляющее большинство опрошенных организаций, использующих контейнеры, применяют Kubernetes в production CNCF Cloud Native Survey 2024. Рост популярности Kubernetes поддерживает и аналитика Gartner, которая оценивает, как облачные платформы включают Kubernetes в свои сервисы.

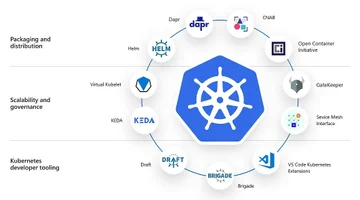

Крупные облачные провайдеры предлагают управляемые Kubernetes-сервисы, а в корпоративном сегменте активно развиваются платформы на его базе. Согласно аналитике, Kubernetes воспринимается как основной способ построения cloud-native-архитектуры, а экосистема операторов, сетевых и security-плагинов делает его гибкой основой для сложных решений.

Факторы популярности:

- открытый исходный код и развитие под эгидой CNCF;

- кросс-облачность и переносимость нагрузок;

- развитая экосистема инструментов вокруг ядра;

- активное сообщество контрибьюторов и практиков.

Развертывание и управление приложениями в Kubernetes: запуск и поддержание работоспособности

Жизненный цикл приложения в Kubernetes строится вокруг манифестов, которые описывают желаемое состояние. Для каждого сервиса создаётся YAML-файл с объектом Deployment: указанием образа контейнера, числа реплик, ресурсов и проб здоровья. Такой манифест описывает развертываемое приложение, его конфигурацию и минимальные требования к ресурсам. Команда kubectl apply отправляет этот манифест в API-сервер, который сохраняет данные в etcd.

Дальнейшие шаги можно представить как простой алгоритм:

- API-сервер принимает манифест и фиксирует желаемое состояние.

- Контроллер Deployment создаёт или обновляет ReplicaSet.

- ReplicaSet создаёт поды, которые нужно запустить.

- Scheduler выбирает подходящие узлы для новых подов.

- Kubelet на выбранных узлах запускает контейнеры через runtime и превращает описание в реальное запущенное приложение.

- Kubernetes отслеживает состояние подов, перезапускает сбойные, поддерживает нужное количество экземпляров и общую работоспособность приложений.

- При изменении манифеста (новый образ или настройки) Deployment выполняет rolling-обновление, поочерёдно заменяя старые поды на новые.

- При необходимости выполняется откат к предыдущей ревизии Deployment.

Так устроено базовое управление приложениями в кластере: платформа берёт на себя развертывание приложений, отслеживает работу приложениями и позволяет менять конфигурацию средствами декларативного описания. Такой сценарий хорошо подходит под разметку Schema.org HowTo: каждый шаг можно оформить как HowToStep с названием и описанием. Это повышает понятность инструкции для поисковых систем и AI-сниппетов.

Установка Kubernetes: как развернуть кластер на сервер и в систему

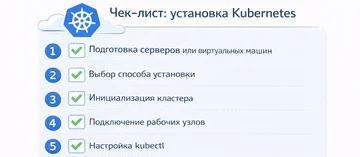

Установка Kubernetes зависит от сценария и выбранного инструмента, но общий порядок шагов похож. Для production-кластеров часто используют kubeadm или готовые дистрибутивы. Для обучения применяют Minikube, kind или локальный Kubernetes в Docker Desktop. Процесс установки Kubernetes включает подготовку серверов, запуск control plane и подключение рабочих узлов.

Пошаговая инструкция высокого уровня:

- Подготовка серверов или виртуальных машин: установка современной операционной системы, отключение swap, настройка сетевых параметров и установка контейнерного runtime (containerd, CRI-O).

- Выбор способа установки: kubeadm для кластеров в собственном дата-центре, управляемые Kubernetes-сервисы в облаках, Minikube или kind для локального кластера разработчика.

- Инициализация кластера: запуск команды инициализации control plane (в случае kubeadm), получение параметров для подключения рабочих узлов.

- Подключение рабочих узлов: выполнение join-команды на каждом узле, чтобы включить его в кластер.

- Настройка kubectl: установка клиента и подключение к кластеру через kubeconfig, проверка связи.

- Базовая проверка работы кластера: просмотр списка узлов и системных подов, развёртывание простого тестового приложения на сервер и проверка доступа к нему.

Подробные пошаговые руководства доступны в официальной документации по kubeadm и в русскоязычных инструкциях, например, в гайдах Purpleschool и отечественных дистрибутивов по установке Kubernetes в систему для корпоративных сценариев.

Безопасность Kubernetes: базовые принципы для начинающих

Безопасность в Kubernetes строится вокруг нескольких ключевых концепций. Понимание этих основ помогает избежать типичных ошибок при первых шагах работы с кластером. Документация Kubernetes: Security.

Главные принципы:

- аутентификация и авторизация через RBAC: роли и привязки контролируют, какие действия разрешены пользователям и сервисным аккаунтам;

- сетевые политики (NetworkPolicy): ограничения трафика между подами и пространствами имён, реализация принципа Zero Trust;

- безопасная работа с секретами: хранение паролей, токенов и ключей в объектах Secret или во внешних хранилищах с шифрованием;

- принцип минимальных привилегий: выдача только необходимых прав и запрет широких ролей уровня cluster-admin для повседневной работы;

- отказ от запуска подов с правами root и без ограничений безопасности.

Пять базовых правил безопасности в Kubernetes:

- Включить и настроить RBAC, отключить анонимный доступ к API-серверу, использовать отдельные сервисные аккаунты для приложений.

- Системно применять NetworkPolicy во всех пространствах имён, разрешая только необходимый трафик.

- Хранить секреты в Kubernetes Secrets или внешних хранилищах (Vault и аналоги), включить шифрование секретов в etcd.

- Конфигурировать поды с учётом Pod Security Standards: запрет привилегированных контейнеров, hostNetwork и запуска под root.

- Вести аудит и мониторинг безопасности: анализировать логи аудита API-сервера, сканировать образы на уязвимости и регулярно обновлять кластер.

Официальные разделы Kubernetes по безопасности:

Заключение

Kubernetes — платформа с открытым исходным кодом для оркестрации контейнеров, которая упрощает управление контейнеризированными приложениями и берёт на себя запуск, масштабирование и восстановление сервисов. Система работает как «рулевой» или «дирижёр» множества контейнеров, поддерживая желаемое состояние кластера без постоянного ручного контроля, даже когда в систему включены десятки сервисов.

Основная задача Kubernetes — автоматизировать работу с контейнерами и приложениями: держать нужное число реплик, балансировать нагрузку, выполнять rolling-обновления и восстанавливать сервисы при сбоях. Платформа особенно полезна в микросервисных архитектурах, крупных кластерах, гибридных и мультиоблачных сценариях, а также в высоконагруженных системах, где без автоматизации эксплуатация становится нестабильной.

Следующий шаг — перейти от теории к практике: поднять небольшой кластер (локальный или в тестовой среде), развернуть простое приложение и постепенно осваивать объекты и механизмы Kubernetes, опираясь на официальную документацию и проверенные курсы. Такой маршрут помогает превратить абстрактное понимание «kubernetes: что это такое простыми словами» в практическое владение инструментом.

Основные мысли:

- Kubernetes — это оркестратор контейнеров, который управляет запуском, масштабированием и устойчивостью приложений.

- Платформа решает проблемы ручного управления множеством сервисов и стала стандартом для контейнеризированных приложений.

- Внедрение Kubernetes оправдано при заметной сложности архитектуры и требованиях к надёжности, а изучение лучше начинать с локального кластера и базовых объектов.

Комментарии (0)

Новый комментарий

Новый комментарий отправлен на модерацию