В сильных системах хранения решает не только скорость SSD. Решающими становятся стек NVMe, дисциплина сети и корректный выбор транспорта. Это снимает узкие места и дает прогнозируемую латентность под критичные нагрузки.

Что такое NVMe-oF простыми словами?

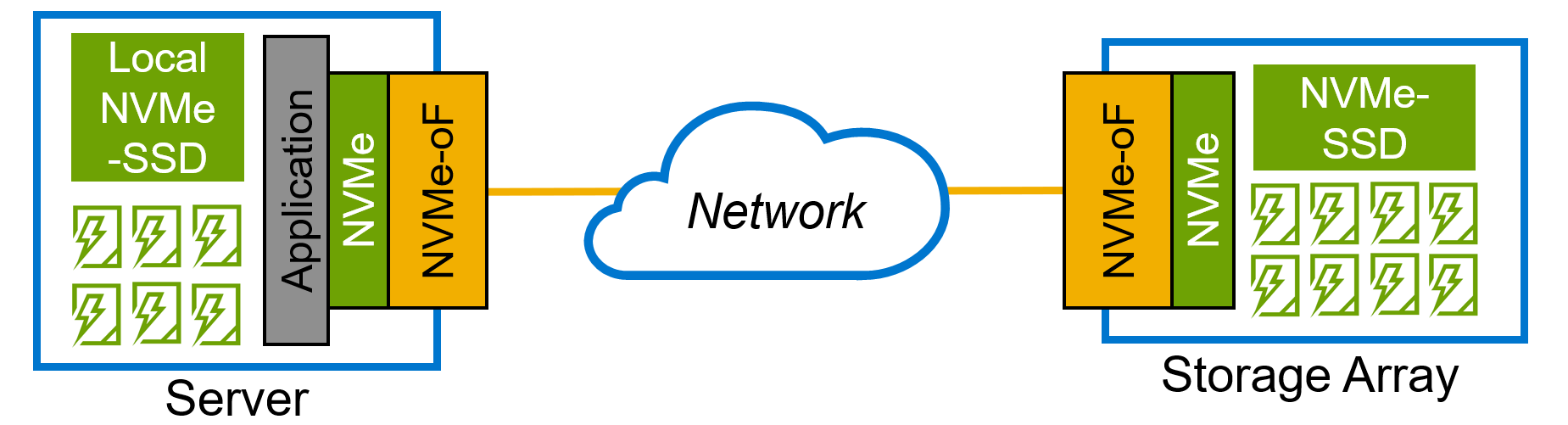

NVMe-oF это способ передать команды NVMe по сети и дать серверам доступ к удаленным NVMe-накопителям почти на уровне локального SSD. Технология убирает лишние слои вроде SCSI и SAS/SATA, поэтому задержка и накладные расходы падают. Именно это закрывает типичное узкое место старых протоколов iSCSI и FC-SCSI в All-Flash массивах.

Фундаментальные различия: NVMe vs. NVMe-oF

NVMe отвечает за локальное подключение SSD по PCIe внутри сервера. NVMe-oF расширяет те же команды NVMe на сетевую фабрику и дает общий пул NVMe-накопителей для многих хостов. До 90% логики протокола совпадает, меняется только транспорт для передачи команд.

Короткая справка: что такое NVMe. Это протокол работы с твердотельными накопителями по PCIe на уровне команд NVMe с глубокими очередями и минимальными накладными расходами. В NVMe важны параллелизм и короткий путь данных на уровне контроллера SSD, поэтому система быстрее обрабатывает мелкие блоки и тяжелые смешанные профили.

Сравнение архитектур: локальная шина против сетевой фабрики

Локальный NVMe это точка-точка в одном сервере по шине PCIe. NVMe-oF это многие-ко-многим через управляемую фабрику Ethernet или Fibre Channel. Первая модель упирается в границы одного шасси и количества слотов. Вторая масштабирует пул NVMe накопителей для десятков и сотен стоечных серверов и удерживает задержку на уровне десятков микросекунд даже при распределении нагрузки между серверами для приложений для баз данных и аналитики.

Главные преимущества использования NVMe-oF

Производительность на уровне локального SSD

Команды NVMe идут по сети без конвертации в SCSI. Путь данных короткий, стек NVMe тонкий. В тестах задержка у NVMe over RDMA держится в десятках микросекунд, что всего в 1,5–2 раза выше локального NVMe и заметно быстрее iSCSI. Для TCP в IP-сетях рост задержки выше, но все равно выигрывает у старых стэков (Pure Storage: What is NVMe over Fabrics, purestorage.com).

Феноменальная масштабируемость и гибкость

Фабрика объединяет NVMe накопителей в общий пул для серверов и кластеров. Получается дезагрегированная архитектура: емкость и IOPS настраиваются под конкретные профили нагрузки. Это полезно для 1С, Oracle, SAP HANA, систем реального времени и конвейеров AI/ML. Технология NVMe обеспечивает на уровне ЦОД управляемое масштабирование без просадки SLA.

Эффективное использование ресурсов CPU

При RDMA (RoCE v2, iWARP) сетевой адаптер передает данные напрямую между памятью узлов. Копирования через ядро нет, нагрузка на процессор ниже, больше циклов уходит на приложение. NVIDIA и Pure Storage показывают стабильное снижение загрузки CPU и прирост IOPS в реальных кейсах за счет offload в RNIC и тонкого стека NVMe (enterprise-support.nvidia.com и purestorage.com).

Снижение совокупной стоимости владения (TCO)

Консолидация на общем пуле NVMe-накопителей, отказ от промежуточных слоев и автоматизация уменьшают CAPEX и OPEX. Вендоры фиксируют экономию за счет меньшего числа серверов под тот же RPS, сокращения энергопотребления и охлаждения, а также упрощения сопровождения. Это характерно как для СХД Dell и СХД HPE, так и для других производителей в сегменте all-flash (Pure Storage: NVMe-oF data center consolidation, purestorage.com).

Архитектура и транспортные протоколы NVMe-oF

NVMe-oF инкапсулирует команды NVMe в пакеты выбранного транспорта. Команды и очереди остаются родными для NVMe, меняется только способ доставки по сети: RDMA, Fibre Channel или TCP. Такой подход сохраняет поведение команд NVMe на уровне хоста и контроллера, упрощает для передачи управления очередями и ускоряет обработку команд NVMe в сети.

"Выбор транспорта для NVMe-oF не про «что лучше». Решает соответствие задачам и текущей инфраструктуре. TCP дает гибкость, RDMA минимальную задержку, FC бесшовное включение в существующие SAN." — технический директор Kvantech.

NVMe-oF over RDMA (RoCE v2, iWARP): максимальная скорость

RDMA дает прямой доступ к памяти удаленного узла без участия CPU. Данные идут через пары очередей, копирования минимальны, лишних контекстных переключений нет. В RoCE v2 используется UDP поверх IP, что упрощает маршрутизацию в L3 и делает стек NVMe предсказуемым под микросекундные задержки.

Особенности и требования

- RNIC с поддержкой RDMA и RoCE v2 или iWARP.

- Коммутаторы с режимом lossless: PFC, ECN, DCB. Нужна оценка QoS, буферов и очередей для передачи трафика без потерь.

- Сквозная настройка без потерь на всем пути NVMe-трафика от хоста до таргета.

Лучшие сценарии использования

HPC, сверхнагруженные OLTP/OLAP, AI/ML, высокочастотная торговля, распределенные файловые и блочные системы, где критична каждая микросекунда. Здесь преимущество NVMe возникает за счет минимального пути команд NVMe и отсутствия копирования через CPU.

NVMe-oF over Fibre Channel (FC-NVMe): надежность корпоративного уровня

FC-NVMe инкапсулирует команды NVMe во фреймы FC. Трафик NVMe и SCSI сосуществуют в одной SAN. Администрирование знакомое: зоны, имена сервисов, политики, мультипути на уровне хостов.

Интеграция в существующие FC SAN

Достаточно обновить прошивки HBA и массивов, убедиться в поддержке FC-NVMe на коммутаторах и серверах. Полная замена SAN не требуется.

Преимущества и недостатки

Плюсы: изоляция трафика, стабильная латентность, зрелые процессы и инструменты.

Минусы: стоимость FC-стека и кадровая специализация. Задержка выше, чем у RDMA в Ethernet, но ниже, чем у TCP. FC-NVMe часто выбирают для серверы для критичных приложений, где нужна предсказуемость и соблюдение процедур SAN.

NVMe-oF over TCP: простота и универсальность

NVMe/TCP работает поверх стандартного TCP/IP. Специальные RNIC не обязательны. Решение применимо в любой IP-сети и легко масштабируется, особенно если требуется быстро использовать NVMe в существующей фабрике Ethernet без сложных настроек.

Простота внедрения и доступность

Достаточно поддерживаемых драйверов в ОС и обычных NIC. Существующая Ethernet-инфраструктура остается. Это снижает порог входа, ускоряет проекты и помогает использовать NVMe/TCP в гибридных облаках и мультисегментных сетях.

Компромисс производительности

TCP добавляет накладные расходы и рост нагрузки на процессор. Задержка выше, чем у RDMA и FC, но ниже iSCSI. Для тестовых сред, VDI, контейнеризации и распределенных приложений для аналитики этого достаточно.

Сравнительная таблица протоколов: RDMA vs. FC vs. TCP

| Параметр | NVMe/RDMA | NVMe/FC | NVMe/TCP |

|---|---|---|---|

| Производительность (задержка) | Микросекунды, близко к локальному NVMe | Низкая, стабильно предсказуемая | Выше RDMA/FC, ниже iSCSI |

| Требования к сети | Lossless Ethernet, RoCE v2/iWARP/IB | FC SAN 16/32/64G | Обычный Ethernet 10/25/100G |

| Нагрузка на CPU | Минимальная, благодаря offload | Низкая, часть логики в HBA | Повышенная, стек TCP в ОС |

| Сложность внедрения | Высокая, строгие сетевые настройки | Средняя, привычные процессы SAN | Низкая, стандартный стек TCP/IP |

| Типичная стоимость | Высокая | Высокая | Низкая или средняя |

| Идеальный сценарий | HPC, AI/ML, OLTP, HFT | Enterprise SAN с FC | Облака, масштабируемые IP-сети |

Ключевые сценарии применения NVMe-oF

Технология раскрывает максимум пользы там, где решают низкая латентность, параллелизм и общее NVMe-хранилище для многих серверов. Pure Storage и NVM Express подтверждают прирост SLA и снижение TCO для таких профилей, где критичны миллисекунды и путь данных укорочен до команд NVMe без лишних преобразований.

Критически важные базы данных (Oracle, SQL Server, SAP HANA)

NVMe очереди и короткий стек уменьшают задержку транзакций и ускоряют восстановление. Это повышает RPS и устойчивость к пикам. Для корпоративных систем, включая 1С, важны стабильный отклик и возможность держать окна обслуживания короче за счет быстрого доступа к томам в NVMe.

Аналитика в реальном времени и Большие Данные (Big Data)

Потоки данных обрабатываются быстрее, ETL сокращаются. Доступ к NVMe накопителей по сети не упирается в контроллеры и SCSI, поэтому интерактивные дашборды отвечают быстрее. Для передачи данных по сети используется стек NVMe/TCP или RDMA в зависимости от требований к задержке.

Высокопроизводительные вычисления (HPC)

Кластерам нужна латентность на уровне десятков микросекунд. NVMe-oF по RDMA снимает лишние копии и разгружает CPU, поэтому время моделирования и симуляций сокращается. Для задач с большим числом мелких операций это критично на уровне архитектуры.

Инфраструктура виртуализации (VDI) и контейнеризация

Старт ВМ и клонов ускоряется, плотность ВМ на сервер растет. NVMe/TCP добавляет гибкость для больших IP-сетей без специальных NIC, а FC-NVMe держит стабильную латентность на уровне SAN. Сценарии с высокими требованиями к QoS и многопутевому доступу получают предсказуемость.

Рабочие нагрузки с использованием ИИ и машинного обучения (AI/ML)

GPU простаивают меньше, датасеты поступают быстрее. Обучение и инференс стабильно нагружают хранилище и сеть, NVMe-oF поддерживает этот профиль без провалов латентности. Для пайплайнов с интенсивным чтением технология NVMe дает преимущество на уровне эффективности всего контура.

Решения на базе NVMe: СХД от Dell и HPE

Решения корпоративного класса на базе NVMe есть у ключевых производителей. СХД Dell и СХД HPE поддерживают end-to-end NVMe и транспорты NVMe-oF, что важно для инфраструктур, где требуется быстрый ввод-вывод и минимальная задержка под прикладные нагрузки.

Вызовы и ограничения при внедрении NVMe-oF

Требования к сетевой инфраструктуре (Lossless Ethernet)

RoCE v2 и InfiniBand чувствительны к потере пакетов. Нужен Lossless Ethernet с PFC, ECN, DCB и гарантированным QoS. Несоблюдение режима ведет к ретрансляциям, скачкам задержки и падению IOPS. При NVMe/TCP таких требований нет, но растет загрузка CPU из-за стека TCP.

Сложность настройки и управления

RDMA требует сквозной настройки от NIC до коммутаторов и целей. FC-NVMe ближе к привычной модели SAN, но тоже нуждается в валидации прошивок и совместимости. В больших IP-сетях для NVMe/TCP важны автоматизация discovery и мультипутей. В противном случае при масштабировании до сотен хостов возникает операционная сложность.

Совместимость оборудования и ПО

Разные интерпретации стандарта у вендоров дают расхождения. До запуска в продакшн нужна лабораторная валидация набора HBA, коммутаторов, драйверов ОС и платформ виртуализации.

Будущее технологии и тренды рынка

Развитие спецификаций NVMe-oF 2.0+ и интеграция с CXL

NVMe 2.0 добавил ZNS, Key-Value, Endurance Group Management. Эти наборы команд расширяют сценарии и улучшают управление флешем на уровне контроллеров. Технология CXL сближает CPU, память и акселераторы, дополняя NVMe-oF в компонуемых архитектурах и снижая задержку при доступе к данным.

Прогнозы по адаптации в корпоративном секторе

Аналитики отмечают рост доли NVMe и NVMe-oF в enterprise и облаках. Массового отказа от Fibre Channel не произошло, FC-NVMe сохраняет позиции в зрелых ЦОД. В новых развёртываниях доля RDMA и NVMe/TCP увеличивается. Переход идет поэтапно и зависит от существующих инвестиций, компетенций и доступности оборудования.

Не знаете с чего начать? Воспользуйтесь нашим конфигуратором СХД

Конфигуратор СХД с поддержкой NVMe-oF

Подбор параметров под профиль нагрузки, расчет емкости и полосы, прикидка задержек на уровне требований к приложению. Конфигуратор СХД помогает рассчитать стоимость и выбрать транспорт: RDMA, FC или TCP.

Перейти в конфигураторЧасто задаваемые вопросы (FAQ)

Можно ли использовать NVMe-oF в обычной Ethernet-сети?

Да. Протокол NVMe/TCP работает поверх стандартного TCP/IP и не требует RNIC или Lossless Ethernet. Производительность ниже, чем у RDMA и FC, но заметно выше iSCSI. Для NVMe/TCP важно следить за MTU, NUMA и качеством NIC, чтобы не тратить лишние циклы на процессор.

Насколько NVMe-oF быстрее iSCSI?

В разы. Стек NVMe короче, поэтому задержка падает в 2–10 раз и более в зависимости от транспорта и реализации. RDMA дает минимальные задержки, TCP показывает компромисс, но все равно опережает iSCSI за счет команд NVMe и параллелизма очередей.

Какое оборудование необходимо для развертывания NVMe-oF?

Для NVMe/TCP достаточно обычных NIC и Ethernet-коммутаторов. Для NVMe/RoCE нужны RNIC и коммутаторы с PFC и ECN. Для NVMe/FC требуются FC HBA и коммутаторы с поддержкой FC-NVMe. Важно проверить поддержку драйверов в ОС и прошивок на уровне HBA.

Является ли NVMe-oF заменой Fibre Channel?

Нет. FC-NVMe это эволюция FC и способ запустить NVMe-команды в существующей FC SAN. Ethernet-альтернативы расширяют выбор, но не отменяют ценность FC-NVMe в enterprise-средах с высокими требованиями к стабильности и изоляции трафика.

Комментарии (0)

Новый комментарий

Новый комментарий отправлен на модерацию