Иногда появляется возможность разобрать действительно интересные серверы. Несколько месяцев назад мне разрешили снять на видео один из самых засекреченных суперкомпьютеров США — El Capitan. В его основе — гибридные процессоры AMD Instinct MI300A, которые объединяют CPU и GPU-ядра из серий AMD EPYC и Instinct, а также память HBM3. Это, вероятно, самый быстрый APU на сегодняшний день.

Сервер GIGABYTE G383-R80-AAP1 использует четыре таких MI300A в одной системе. При этом его можно приобрести и запускать как отдельный сервер, без необходимости в кластере на десятки тысяч узлов. Это делает его особенно интересным: мощная платформа, доступная в автономном исполнении — отличный повод для обзора и тестирования.

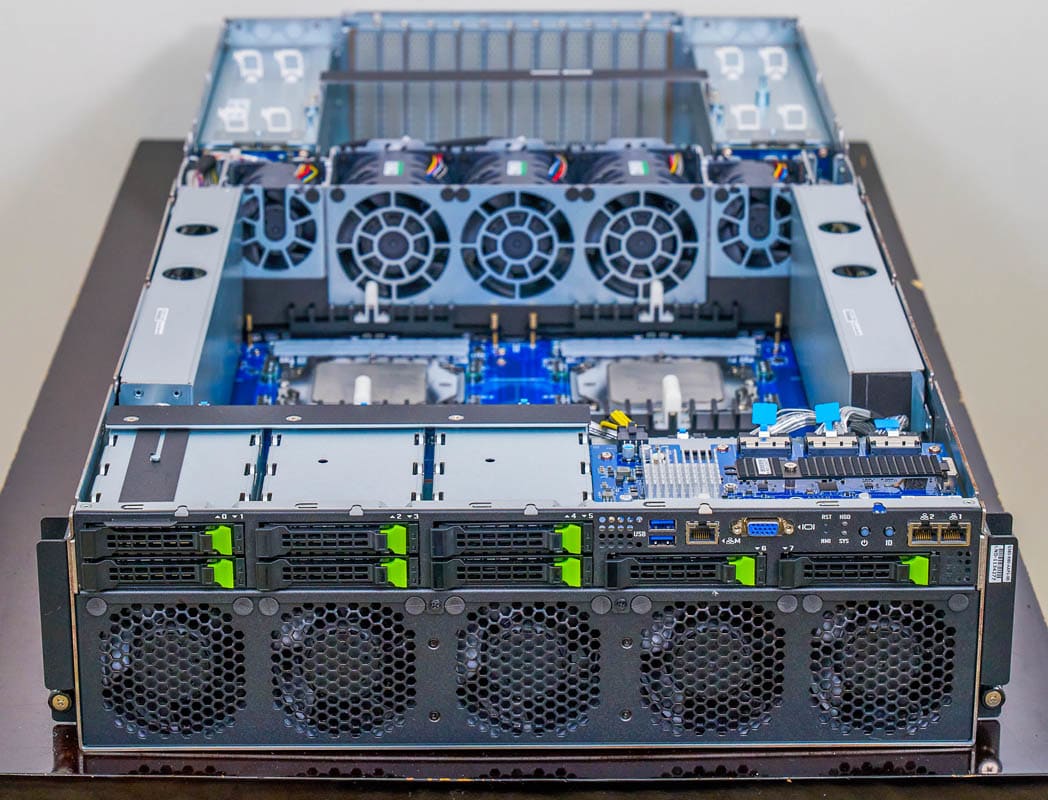

Внешний обзор GIGABYTE G383-R80-AAP1

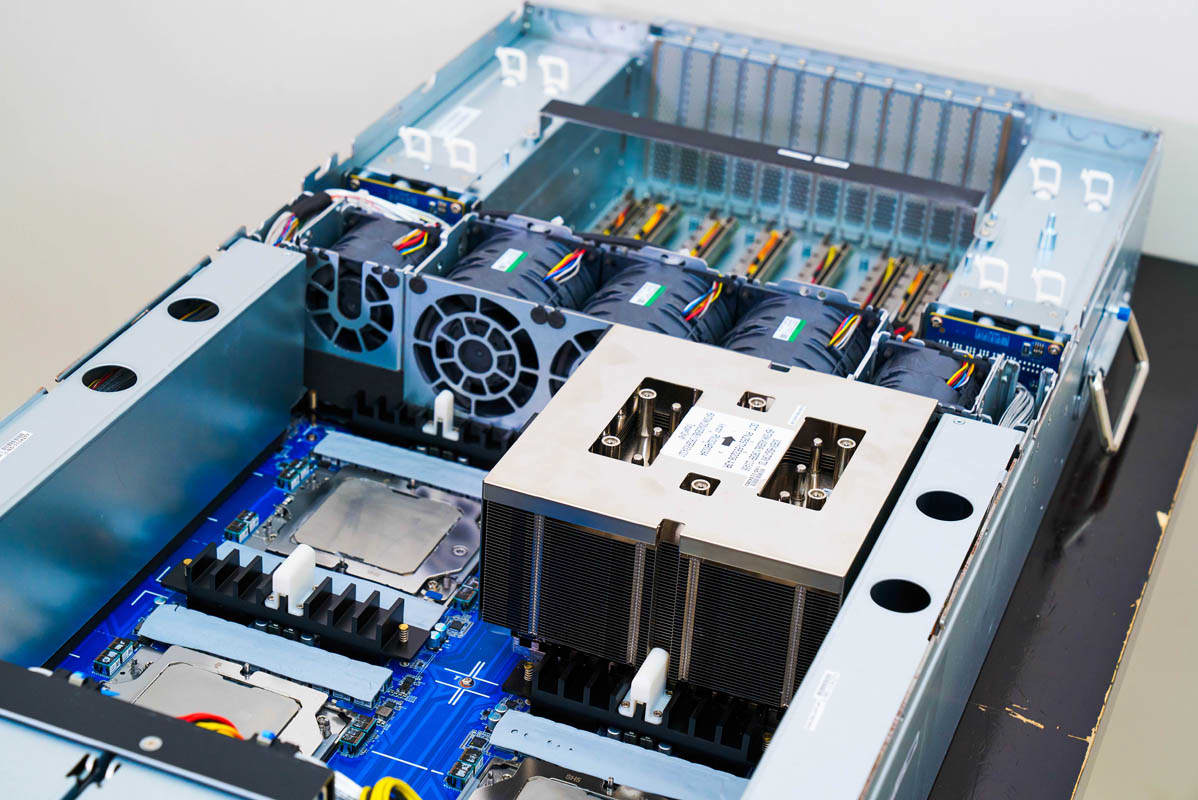

Сервер выполнен в корпусе формата 3U, его глубина — 950 мм (37,4 дюйма). Для переноски предусмотрены удобные ручки на передней панели.

На передней панели в нижней части находятся модули охлаждения, а в верхней 1U-зоне — отсеки под накопители и интерфейсы ввода-вывода (I/O).

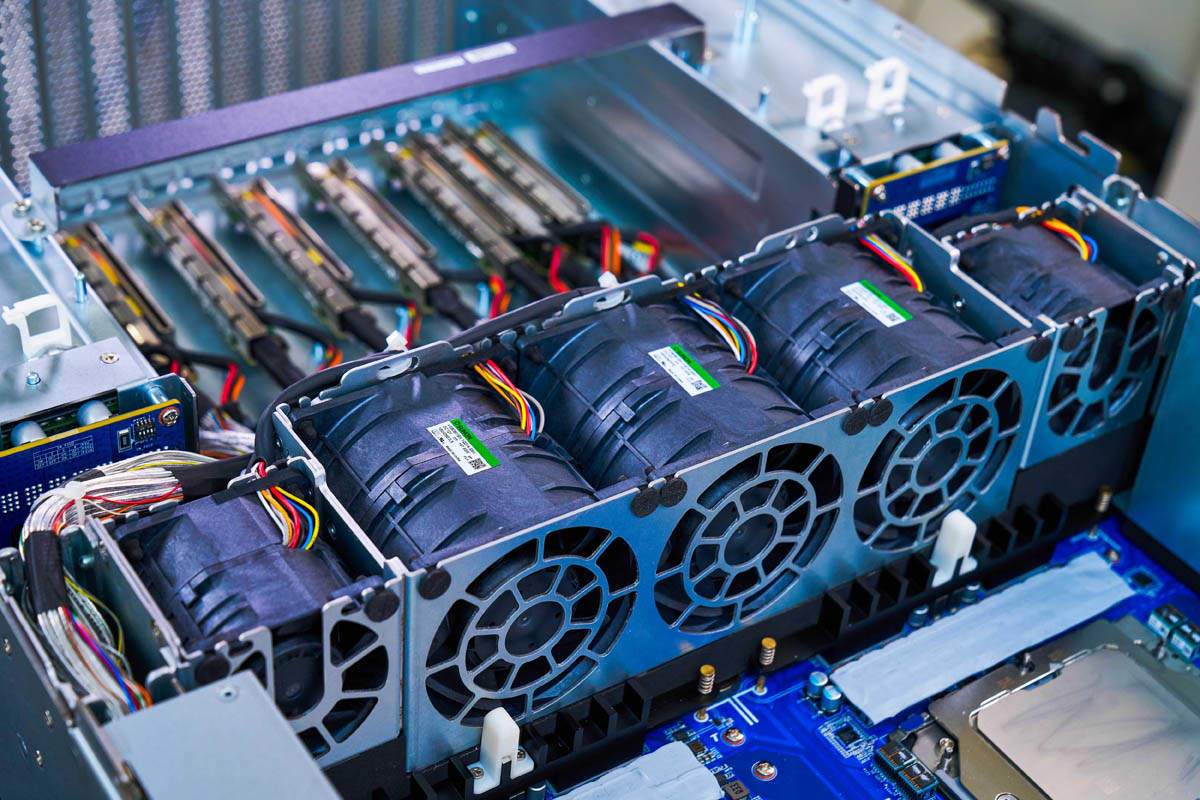

Система охлаждения занимает нижние 2U корпуса. Вентиляторы направляют холодный воздух к радиаторам APU, обеспечивая эффективный отвод тепла.

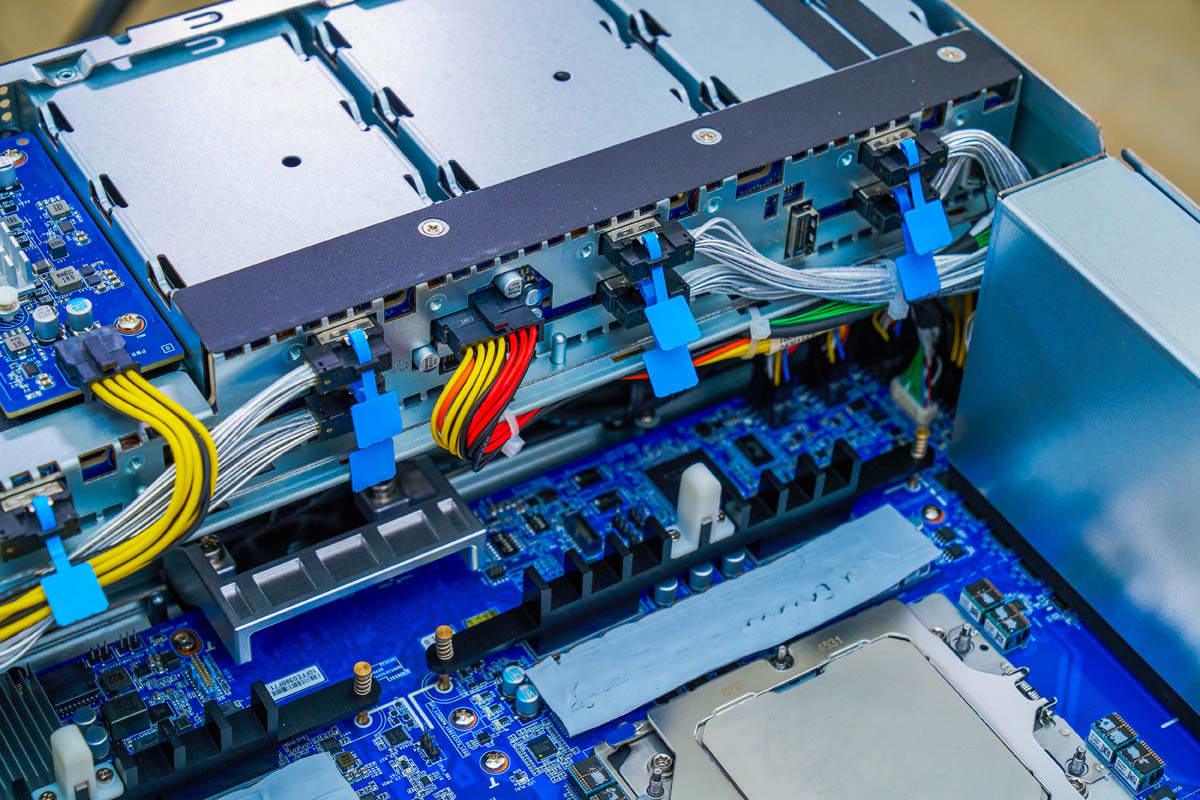

Для хранения данных предусмотрены восемь отсеков под 2,5-дюймовые NVMe-накопители.

Каждый диск подключён по отдельному каналу PCIe x4 к бекплейну.

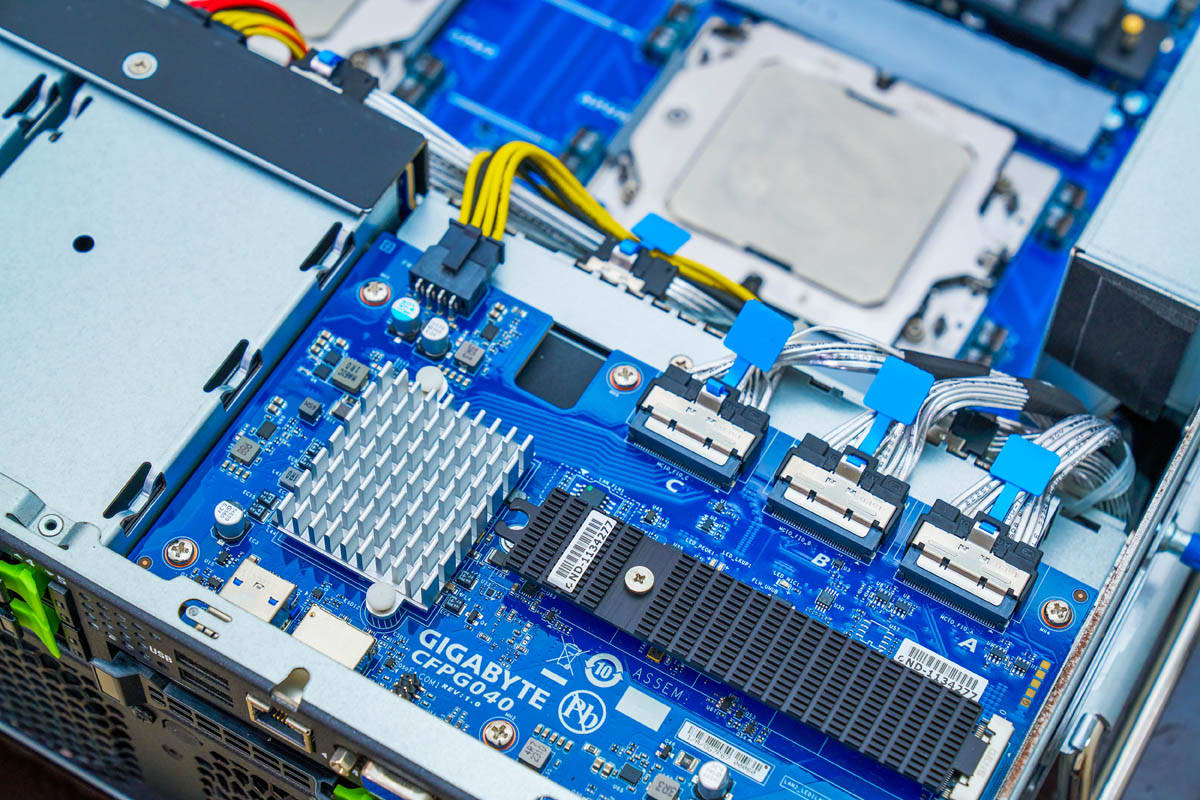

Важной особенностью передней части является интерфейс ввода-вывода. Здесь установлены два порта 10GbE, работающие через контроллер Broadcom BCM57416.

Плата I/O также включает слот M.2, USB-порты, VGA-выход и порт управления (management LAN). Компоновка выполнена аккуратно и удобно.

Сзади — четыре блока питания по 3 кВт. Для системы такого класса это сравнительно энергоэффективное решение, особенно с учётом вычислительных возможностей.

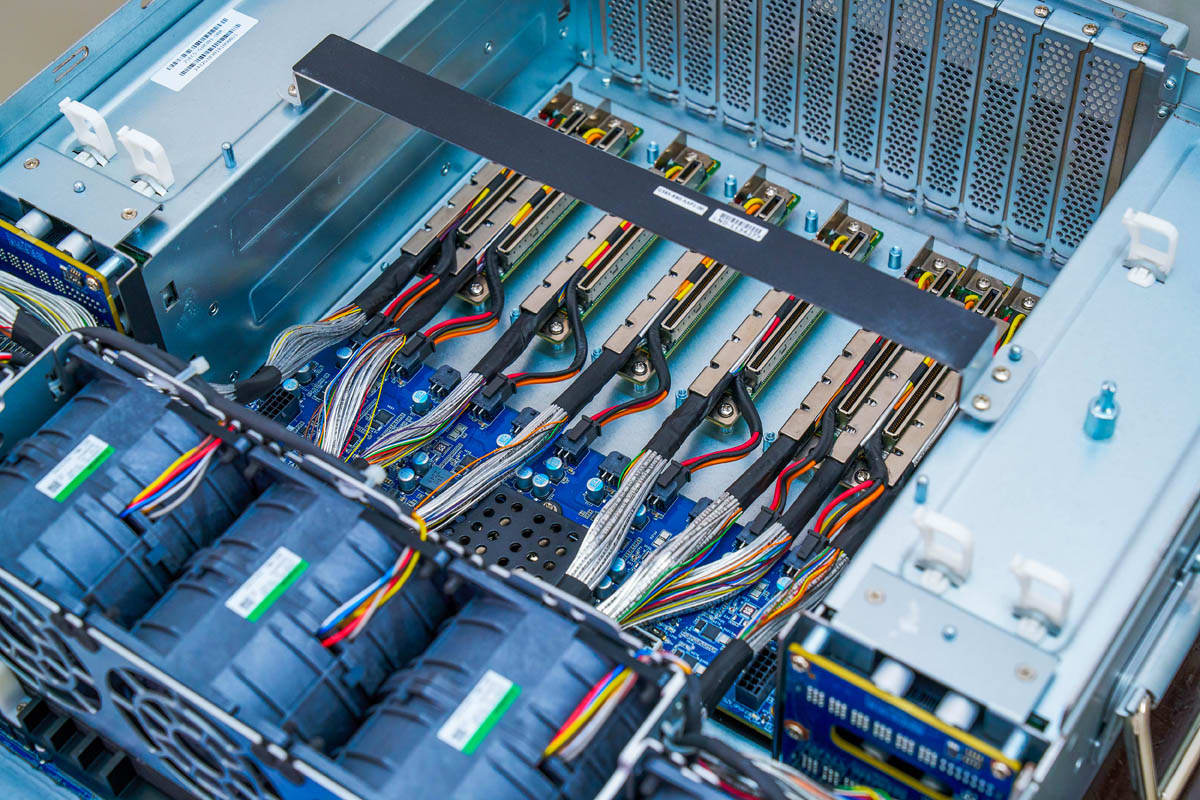

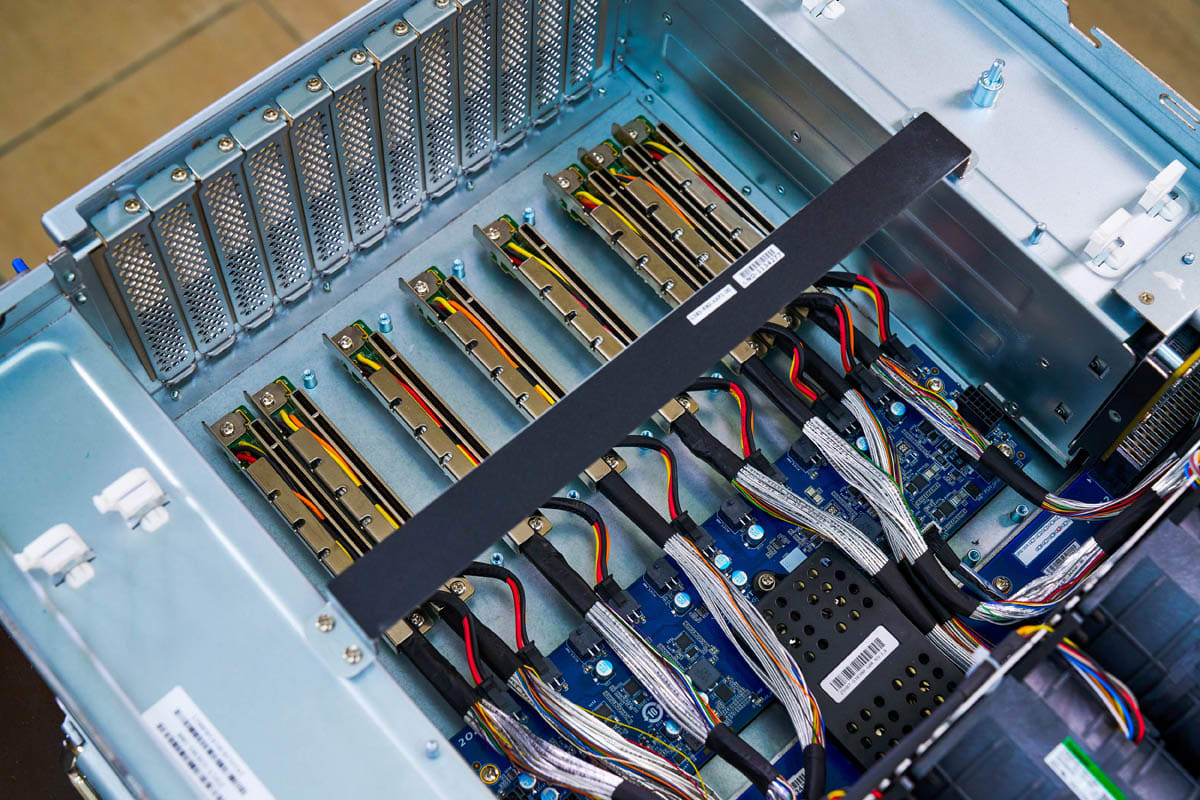

Основная часть задней панели — это слоты расширения PCIe Gen5 x16:

- 4 слота двойной ширины

- 4 слота одинарной ширины

Они подключены через разводочные платы PCIe, которые обеспечивают компактное размещение и надёжное соединение с основными компонентами.

Интересный сценарий для энтузиастов и разработчиков — установить четыре сетевых адаптера по 400 Гбит/с (по одному на каждый APU), а также четыре ускорителя двойной ширины или CXL-карты на базе PCIe.

Изначально серия MI300 предполагала поддержку CXL, и предсерийные версии действительно её имели. Однако в финальных релизах эта функция была отключена. Если AMD активирует CXL в будущем, это откроет дополнительные возможности для масштабирования.

Далее — обзор внутреннего устройства сервера.

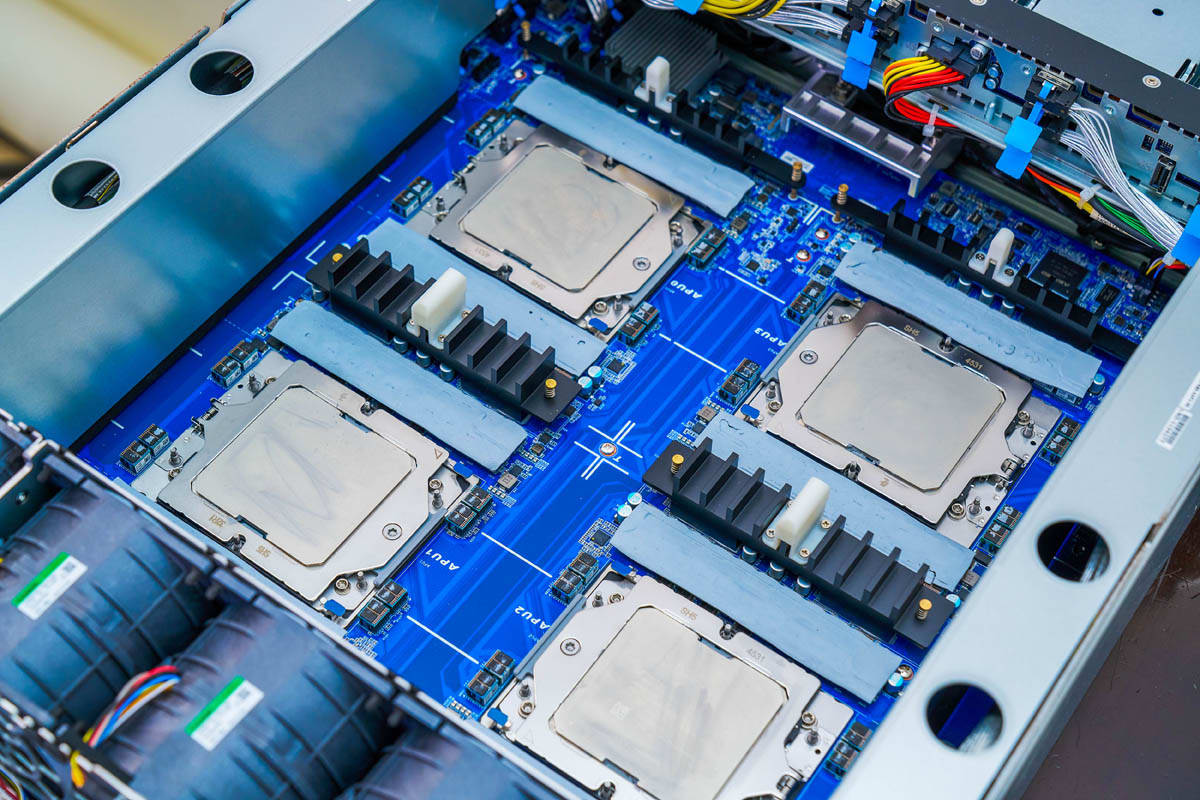

Внутренний обзор GIGABYTE G383-R80-AAP1

Начнём с передней части корпуса и постепенно перейдём к внутреннему устройству.

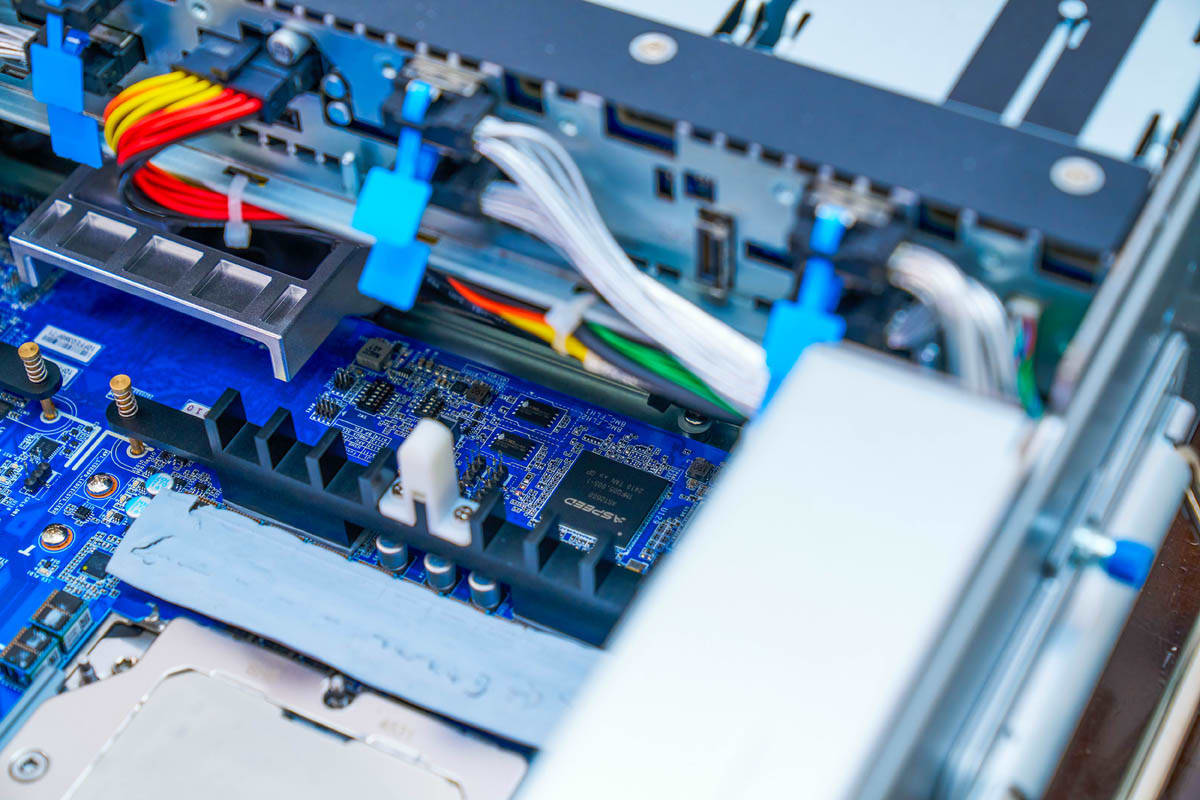

Под отсеками для NVMe-накопителей расположен контроллер управления платой (BMC) — ASPEED AST2600.

Все интерфейсы ввода-вывода подключаются к основной плате с четырьмя модулями AMD Instinct MI300A через PCIe-кабели. Такая архитектура упрощает компоновку и даёт гибкость в маршрутизации сигнала.

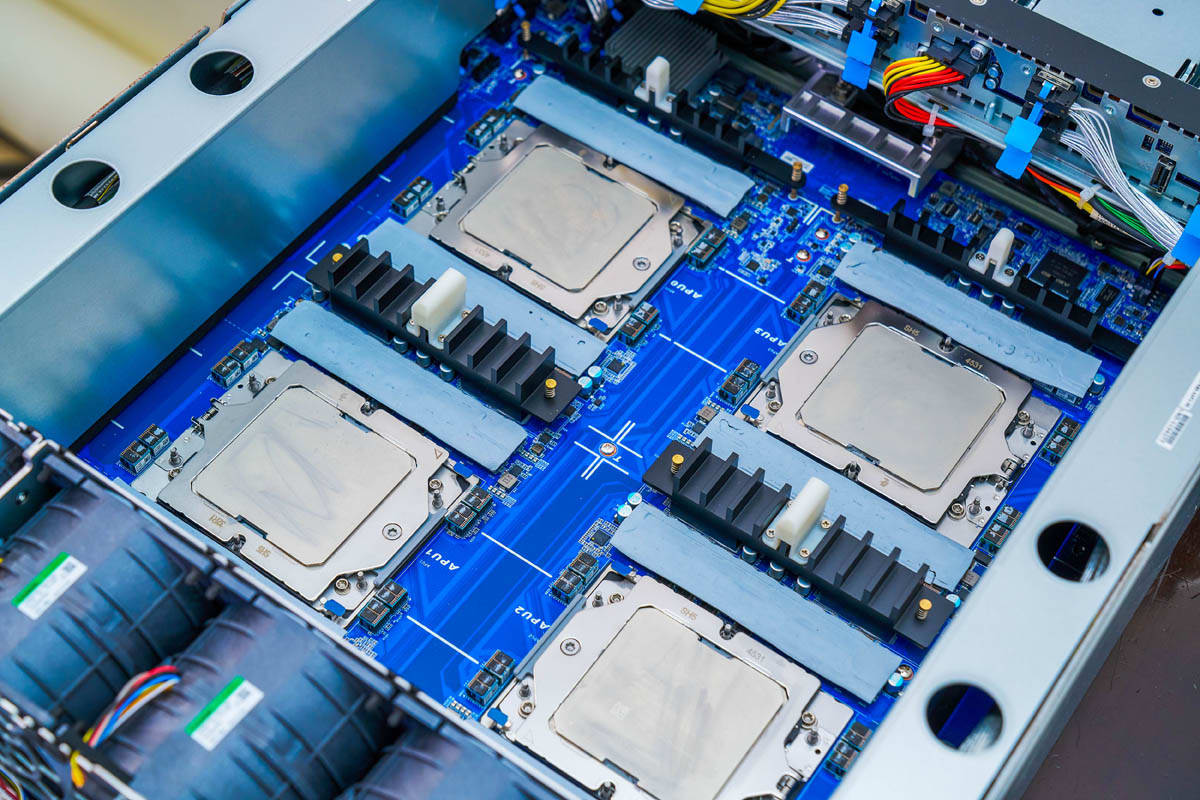

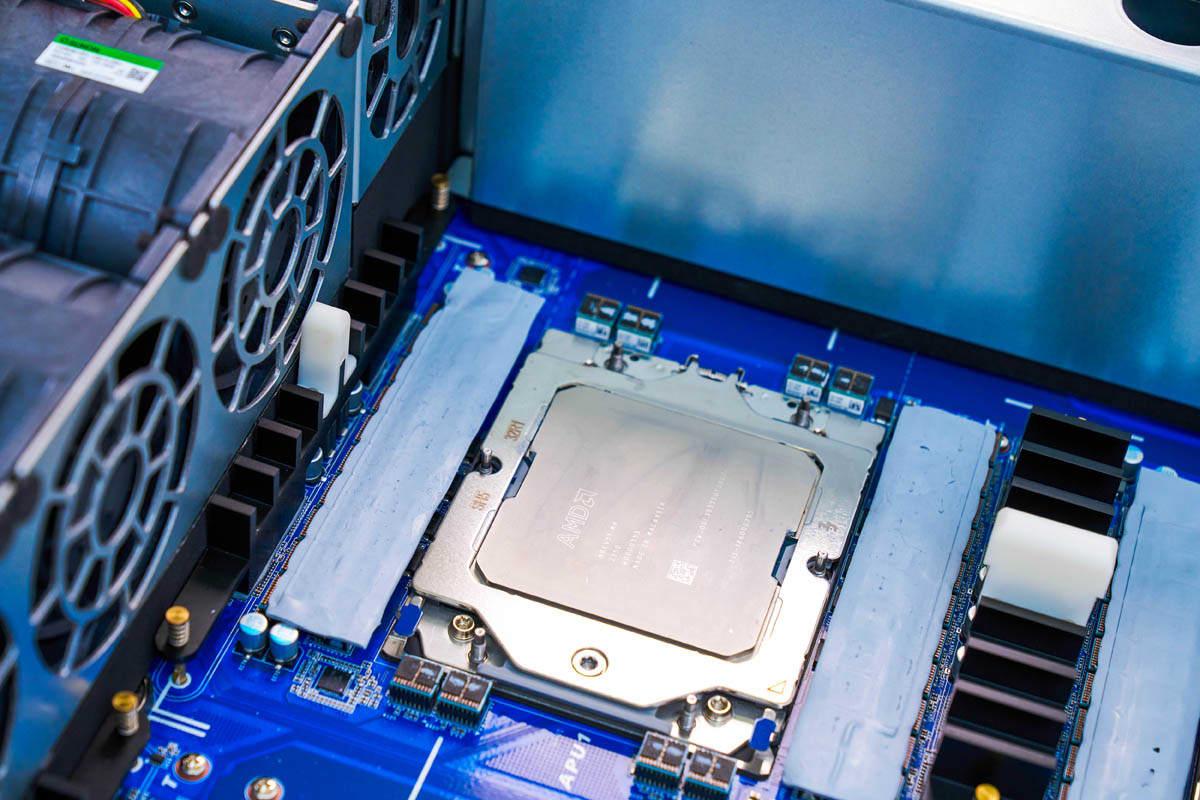

AMD Instinct MI300A — это многочиповые модули, в которых объединены:

- CPU-ядра,

- GPU-ядра,

- память HBM3.

Они созданы для высокой плотности вычислений и энергоэффективности в HPC-системах.

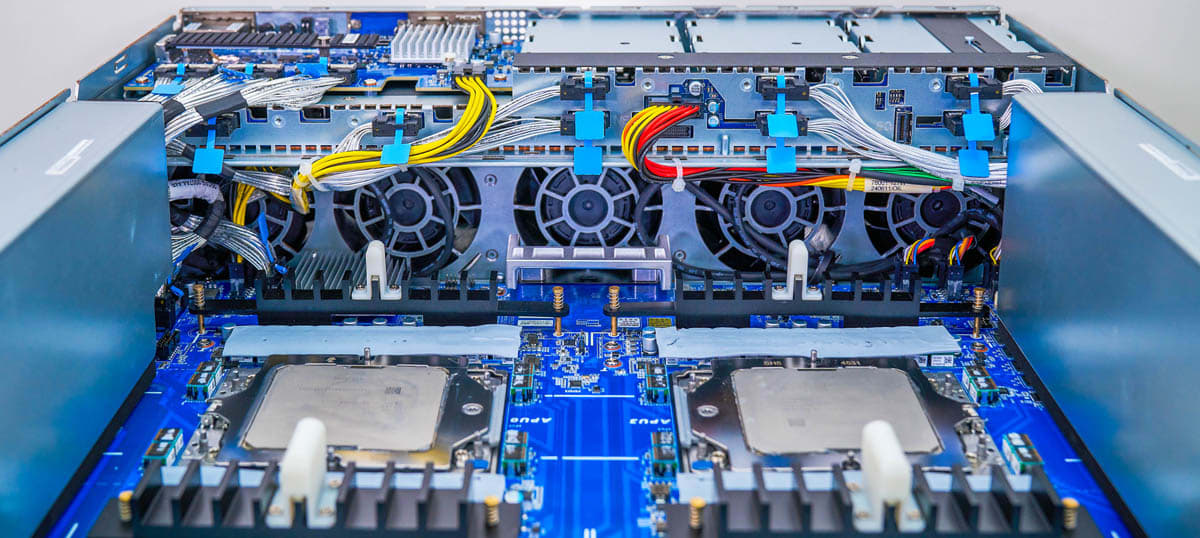

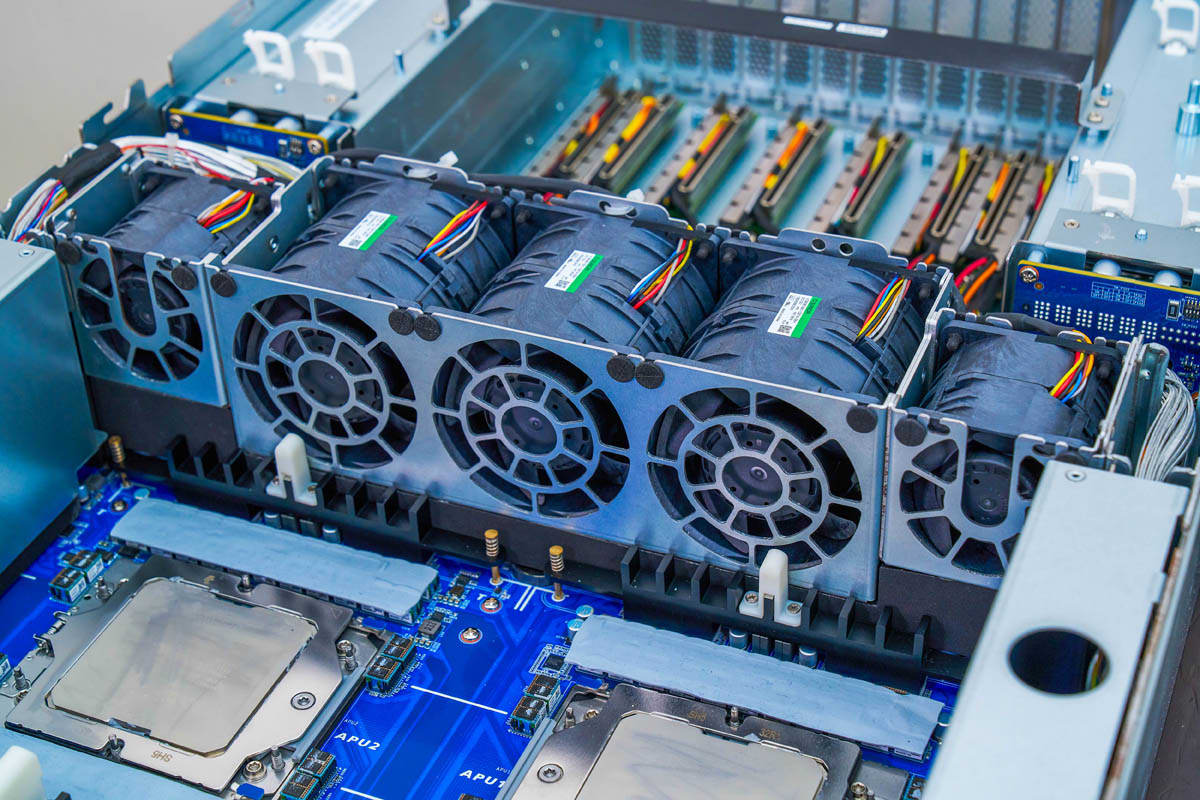

Модули MI300A устанавливаются в сокеты, визуально напоминающие разъёмы под процессоры EPYC. Однако здесь используется сокет AMD SH5, а не привычный SP5.

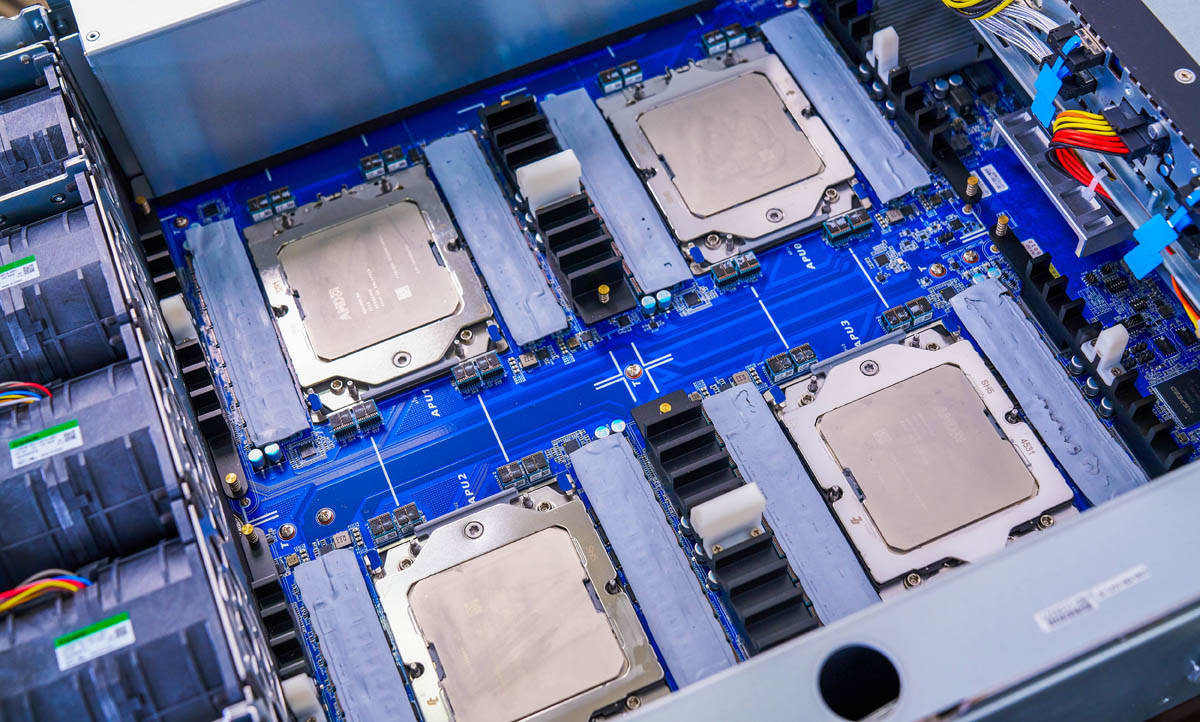

В сервере установлено четыре MI300A. Это полноценная четырёхсокетная система, где каждый модуль содержит:

- один CPU с 24 ядрами,

- один GPU,

- 128 ГБ HBM3-памяти.

Каждый модуль — это самостоятельный вычислительный узел, объединяющий CPU, GPU и память.

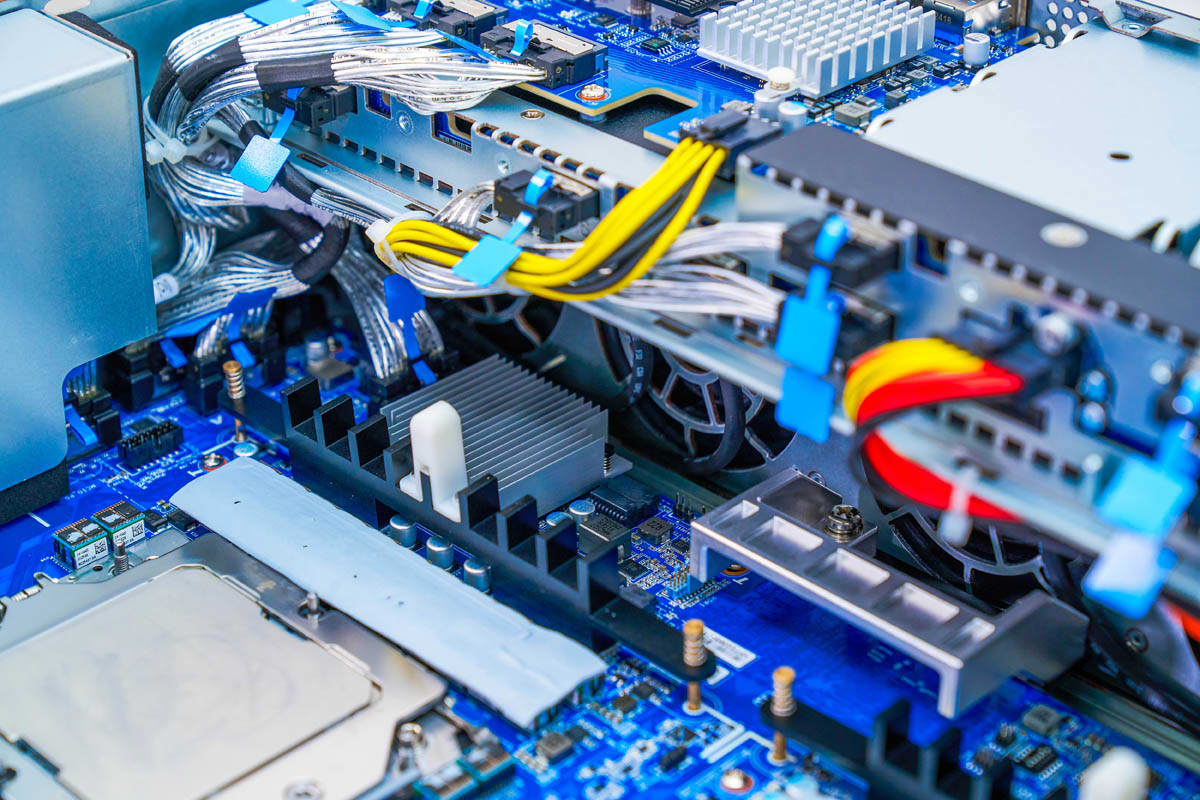

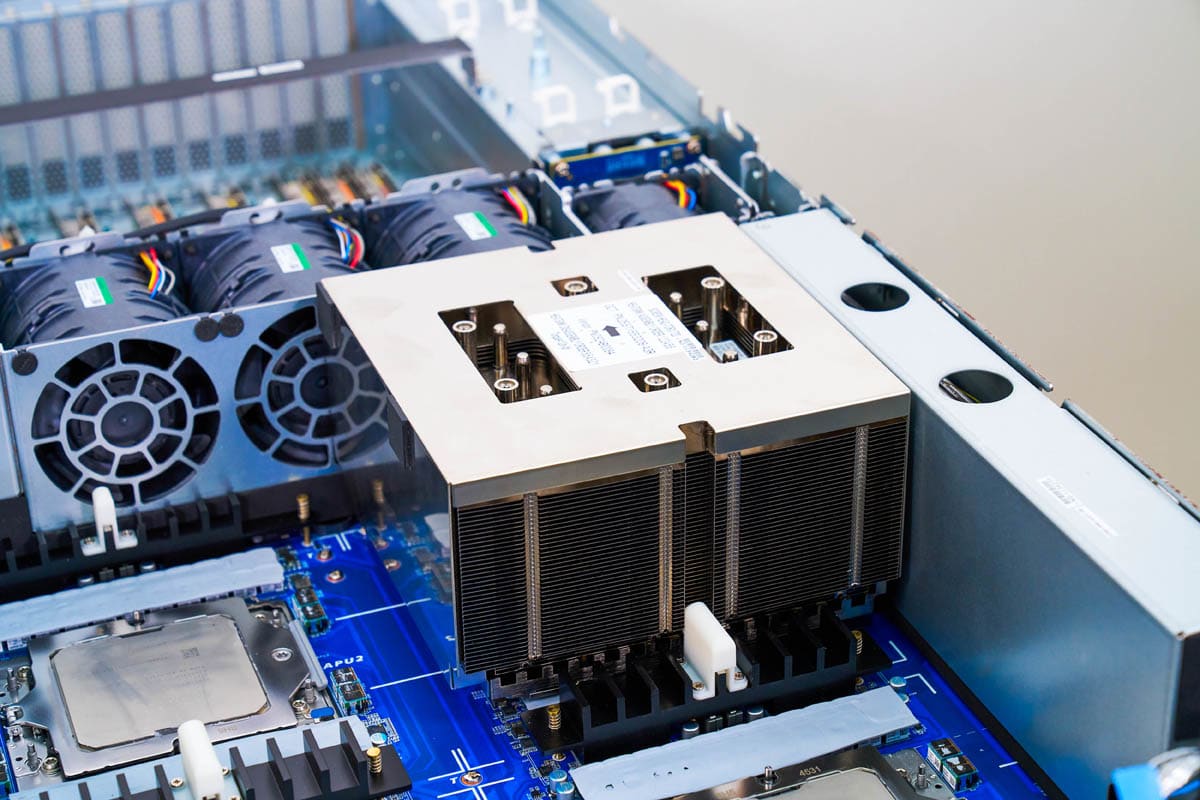

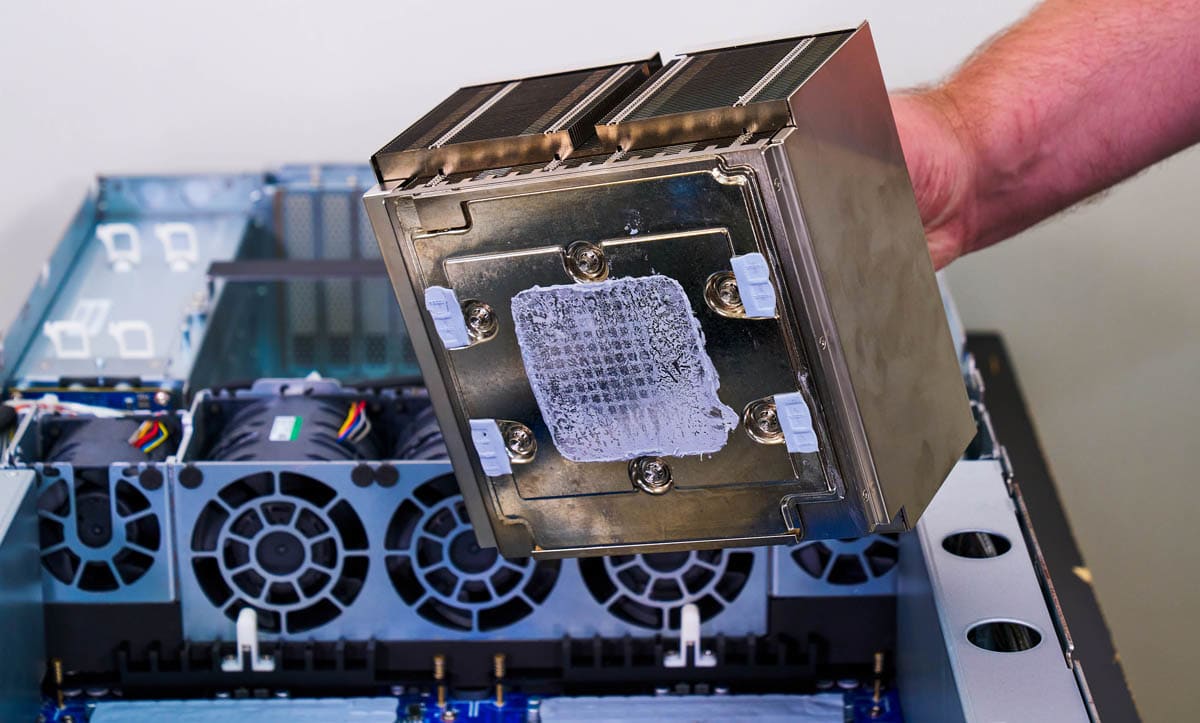

Потребление одного APU составляет от 550 до 750 Вт, поэтому система использует массивные радиаторы, которые охлаждают как MI300A, так и компоненты питания.

Эти радиаторы — одни из крупнейших, применяемых в серверах. Они обеспечивают необходимый уровень теплоотвода для стабильной работы при высоком энергопотреблении.

Модули установлены последовательно по глубине шасси, поэтому воздух должен проходить через все радиаторы. Это требует мощной и продуманной системы охлаждения.

В корпусе предусмотрен дополнительный блок вентиляторов в отдельном отсеке. Он обеспечивает усиленный поток воздуха через APU-модули.

Обычно серверы используют один блок вентиляторов, реже — два, разделённых по зонам. Здесь же две группы вентиляторов прокачивают воздух через одни и те же компоненты — необычное, но эффективное решение.

Этот второй блок также охлаждает PCIe-карты в задней части корпуса, где обычно размещаются высокоскоростные сетевые адаптеры (NIC). Кроме того, в этой зоне возможна установка дополнительных плат, не ограничиваясь только сетевыми задачами.

Далее рассмотрим топологию сервера и его блочную диаграмму — это поможет понять, как связаны между собой компоненты и как распределяются ресурсы.

Топология GIGABYTE G383-R80-AAP1

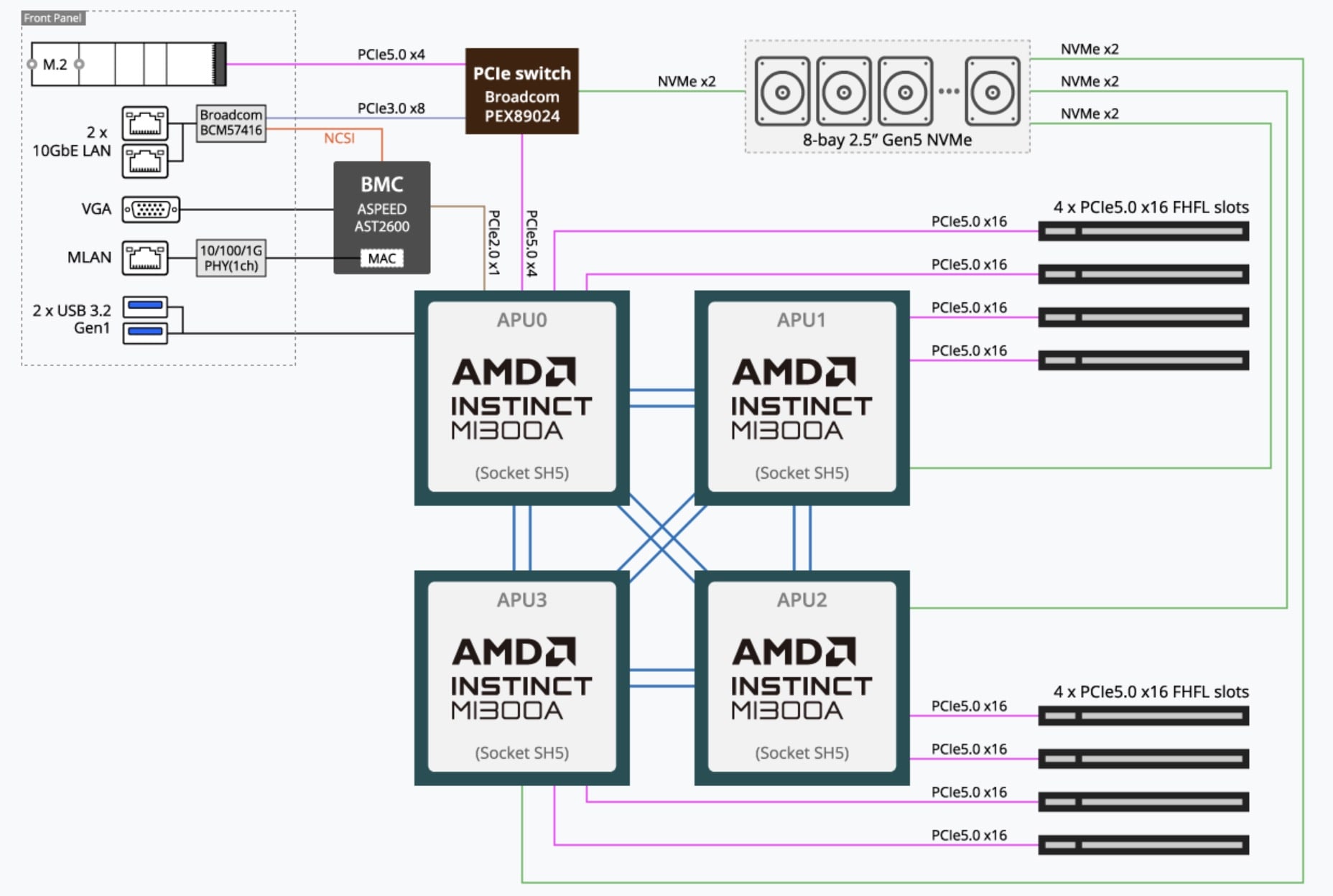

Чтобы наглядно показать, как связаны между собой все компоненты сервера, ниже представлена блочная схема системы. Она отражает подключение APU, памяти HBM3, слотов PCIe, накопителей и интерфейсов ввода-вывода.

Сервер построен по классической четырёхсокетной архитектуре — аналогично платформам с четырьмя CPU. Поскольку AMD официально не предлагает 4-сокетные серверы на базе EPYC, это решение — по сути, первая полноценная 4-сокетная серверная платформа AMD, основанная на APU MI300A.

Каждый модуль MI300A имеет:

- два подключения PCIe Gen5 x16 к слотам расширения,

- два NVMe-подключения PCIe Gen5.

Кроме того, APU0 связан с коммутатором Broadcom PEX89024, через который работают низкоскоростные интерфейсы, включая порты 10GbE.

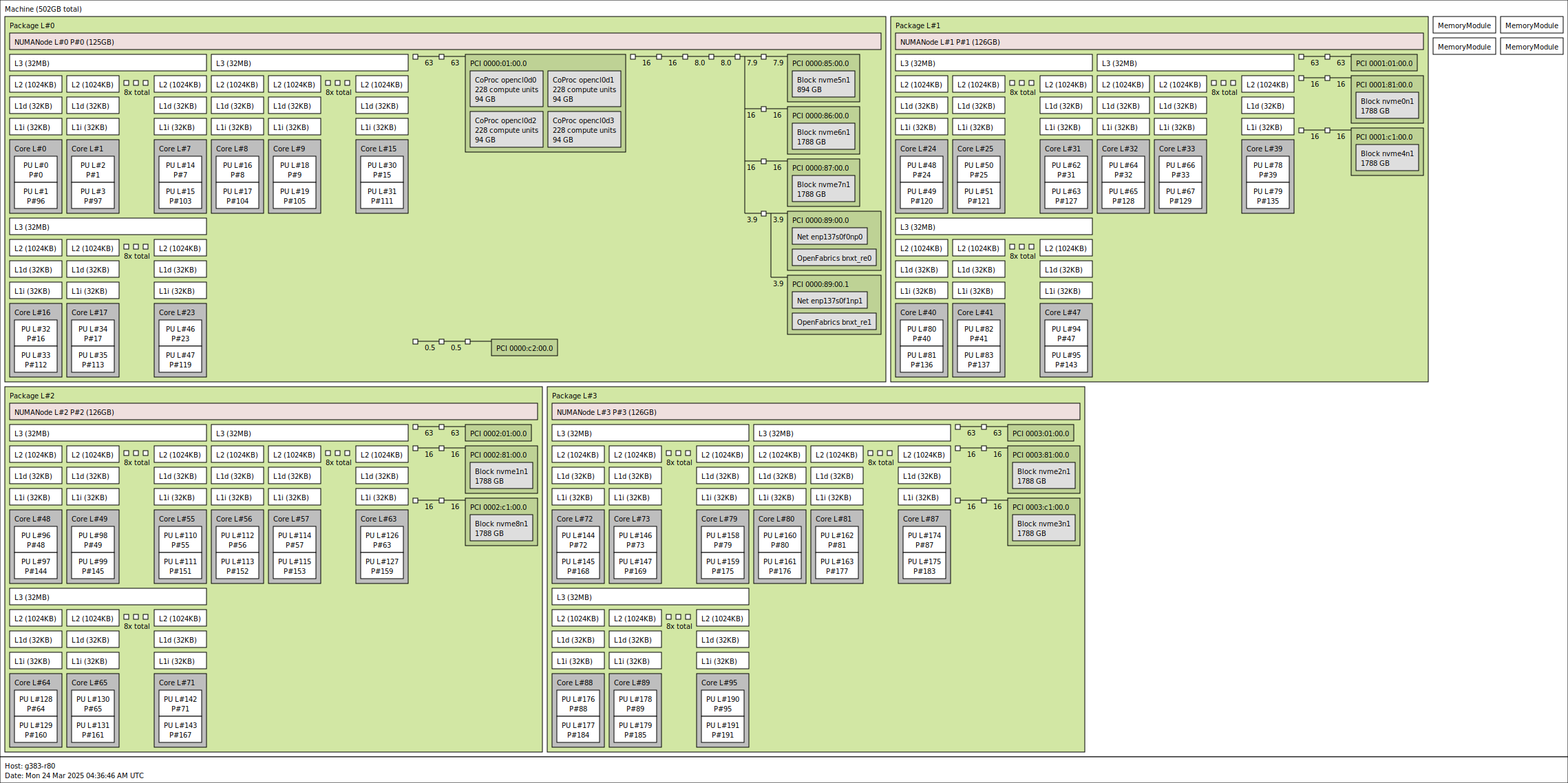

На следующей схеме показано распределение ресурсов:

- 4 APU MI300A,

- по 24 CPU-ядра и 1 GPU на архитектуре CDNA 3 на каждый,

- суммарно 512 ГБ HBM3,

- отсутствие DDR5 — вся память размещена внутри APU.

Изначально предполагалась возможность расширения памяти через CXL-устройства, но в текущей конфигурации HBM3 — единственный пул памяти.

Для сравнения:

- Intel Xeon MAX 9480: 64 ГБ HBM2e на процессор, без GPU, двухсокетная архитектура.

- AMD MI300A: 4 APU с объединёнными CPU+GPU, 512 ГБ HBM3 на весь сервер.

Таким образом, система на AMD MI300A принципиально отличается от решений Intel по подходу к интеграции и объёму доступной памяти.

У NVIDIA Grace Hopper (GH200) — другая архитектура:

- HBM подключена к GPU Hopper,

- LPDDR5X — к CPU Grace.

У CPU и GPU — раздельные подсистемы памяти, между которыми нужно синхронизировать данные. Такая модель эффективна в ряде сценариев, но требует дополнительных усилий по управлению трафиком.

Преимущество AMD MI300A — в едином пуле HBM3, равноправно доступном и CPU, и GPU.

Нет необходимости кэшировать данные, передавать их между подсистемами или использовать дополнительную шину. Это упрощает архитектуру и повышает эффективность.

Такой подход начинает восприниматься по-настоящему только после работы с системой. Сам факт общего пула памяти меняет представление о том, как строятся вычислительные нагрузки.

Управление GIGABYTE G383-R80-AAP1

В сервере используется стандартный контроллер управления ASPEED AST2600 BMC. Он обеспечивает типичный набор функций, включая HTML5 iKVM, и не требует изучения нестандартных решений. Это упрощает администрирование: вы можете использовать знакомые инструменты без дополнительной настройки или обучения. А сейчас перейдём к более интересной части.

AMD Instinct MI300A

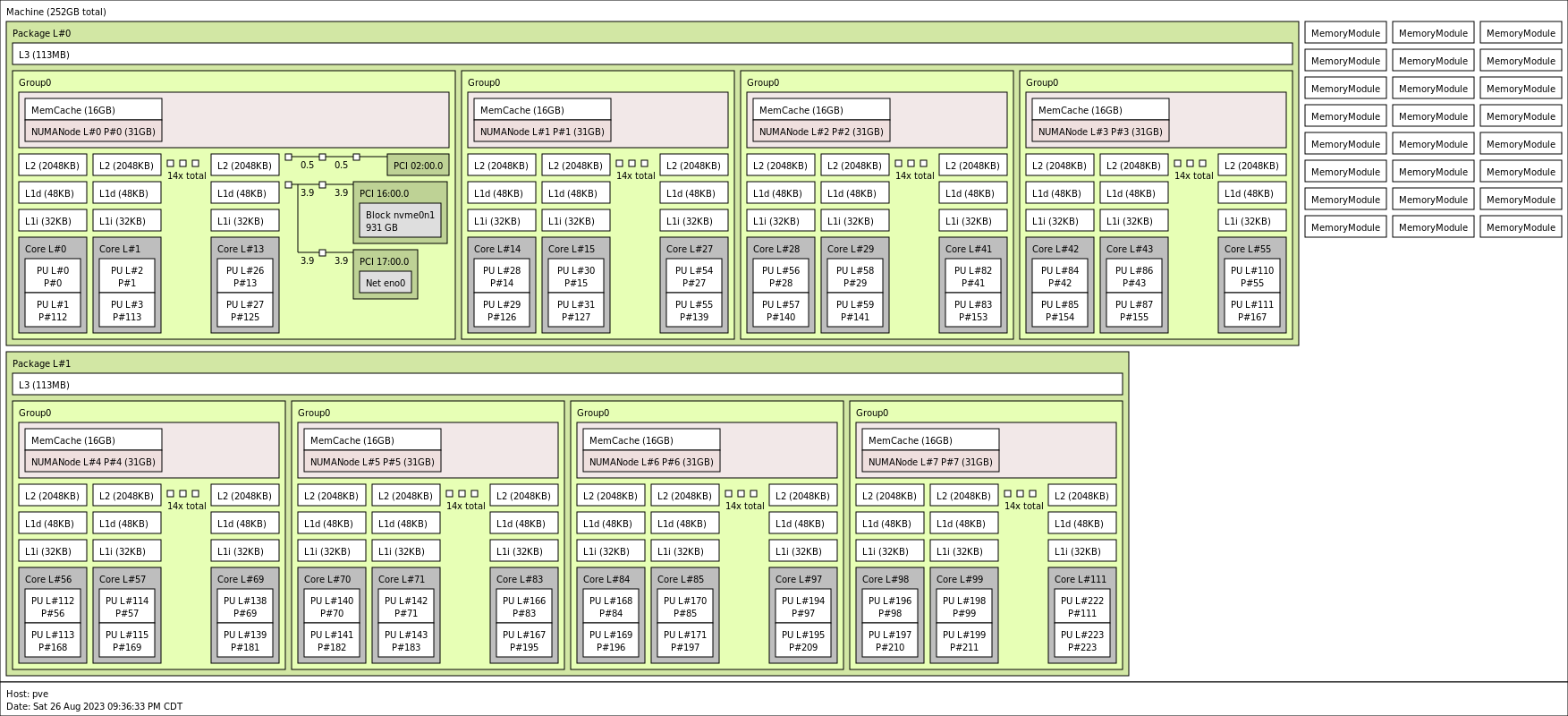

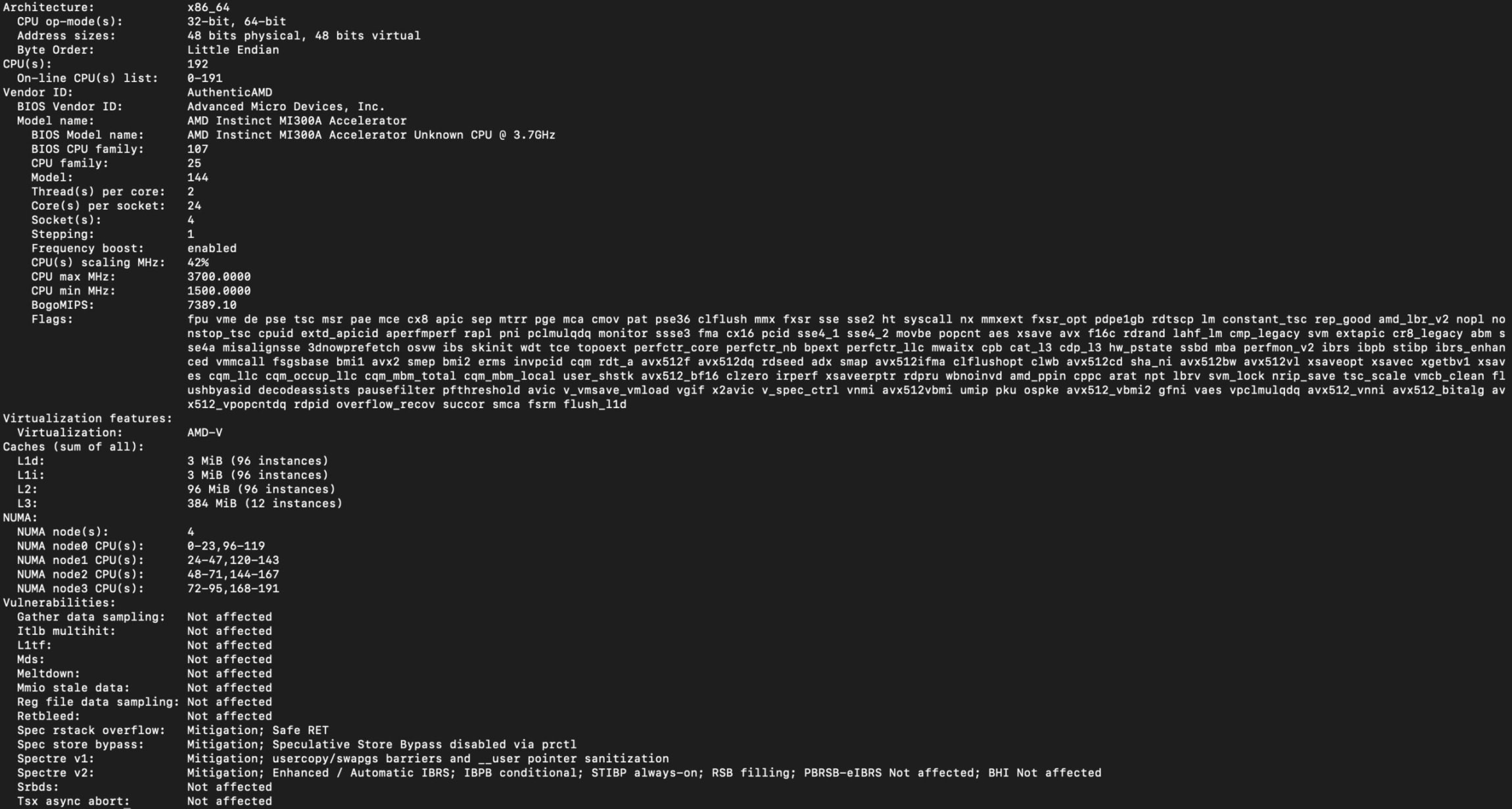

Если вы пропустили раздел с топологией, вывод команды lscpu на этой системе наглядно показывает ресурсы четырёх APU MI300A.

Каждый APU содержит 228 вычислительных блоков (compute units) архитектуры CDNA3. Для сравнения: у AMD MI300X — 304 блока, но в MI300A дополнительно есть CPU и общий пул памяти HBM3, чего нет у MI300X.

AMD приводит пиковые значения производительности одного MI300A:

- FP8 — 1,96 PFLOPS

- FP8 с разреженностью — 3,92 PFLOPS

- FP16 — 980,6 TFLOPS

- FP16 с разреженностью — 1,96 PFLOPS

- TF32 (матричные операции) — 490,3 TFLOPS

- TF32 с разреженностью — 980,6 TFLOPS

- FP32 (матрицы) — 122,6 TFLOPS

- FP64 (матрицы) — 122,6 TFLOPS

- FP32 (скалярные операции) — 122,6 TFLOPS

- FP64 (скалярные операции) — 61,3 TFLOPS

- INT8 — 1,96 POPS

- INT8 с разреженностью — 3,92 POPS

- bfloat16 — 980,6 TFLOPS

- bfloat16 с разреженностью — 1,96 PFLOPS

Фактическая производительность может отличаться от заявленных пиковых значений. Подробное тестирование будет представлено в отдельном материале.

Если установить 15–16 таких серверов в стойку 48U или 52U и обеспечить их питанием и охлаждением, можно выйти на нижние позиции в рейтинге Top500 суперкомпьютеров. Это впечатляющий результат для системы такой плотности.

Также стоит отметить: каждый APU включает три аппаратных блока декодирования видео. Поддерживаются кодеки HEVC (H.265), AVC (H.264), V1 и AV1. Это важно для задач видеоаналитики, поскольку многие ускорители ИИ не имеют встроенных декодеров и перекладывают эту нагрузку на CPU. В MI300A видеопоток обрабатывается на аппаратном уровне.

Потребляемая мощность GIGABYTE G383-R80-AAP1

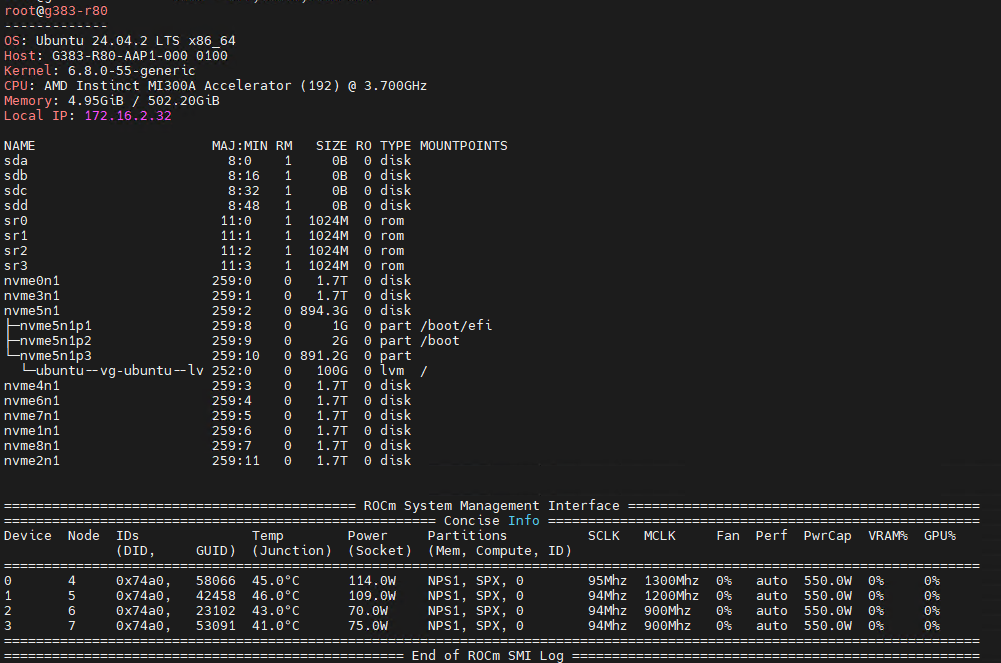

Сервер использует четыре блока питания по 3000 Вт в конфигурации 3+1: три работают под нагрузкой, четвёртый — резервный (hot spare). Такая схема позволяет продолжать работу даже при отказе одного из БП, что критично для дата-центров.

Каждый APU с воздушным охлаждением потребляет около 550 Вт. Несмотря на удалённый доступ и отсутствие возможности подключить внешнюю систему мониторинга, по встроенным датчикам суммарное энергопотребление сервера составило около 3,4 кВт. Это не предел: с учётом слотов PCIe Gen5 x16 и SSD система может потреблять значительно больше.

По сравнению с серверами на 8 GPU, G383-R80-AAP1 обеспечивает аналогичную производительность при меньшем объёме — и более высокой плотности HBM3-памяти: 1,5–2 ТБ в пределах тех же габаритов и энергобюджета. Именно это делает архитектуру MI300A привлекательной для энергоэффективных суперкомпьютеров, включая El Capitan.

Важно: APU MI300A поддерживают TDP до 760 Вт. Повышение лимита мощности увеличивает потребление примерно на 1 кВт, но даёт больший запас по производительности — за счёт более высоких частот и стабильной работы при нагрузке.

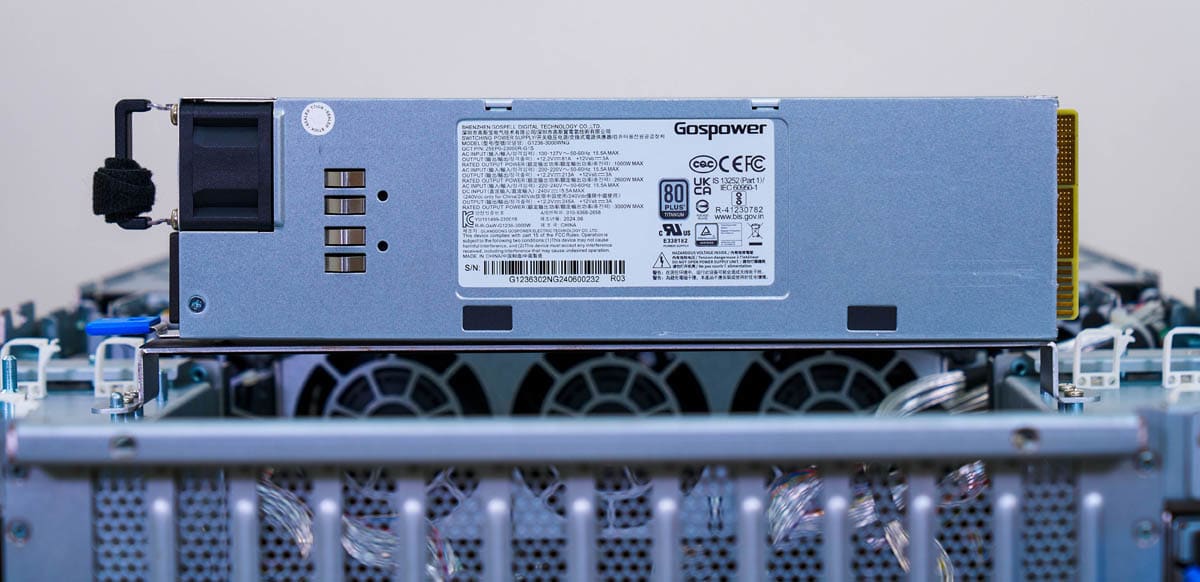

STH Server Spider: GIGABYTE G383-R80-AAP1

Во второй половине 2018 года мы создали STH Server Spider — инструмент для быстрой оценки задач, на которые ориентирован сервер. Он помогает визуально сравнить системы по ключевым параметрам: вычисления, память, хранилище, плотность и др.

Этот сервер не стремится к максимуму по GPU, CPU, объёму памяти или числу накопителей. Его особенность — сбалансированное сочетание CPU, GPU и HBM-памяти в едином модуле. Такая архитектура делает платформу уникальной.

Примеры товаров

Создание Server Spider для этой системы оказалось особенно интересным: он наглядно показывает нестандартный, но хорошо продуманный баланс характеристик.

Заключение

Этот сервер — нестандартное решение. Несмотря на знакомство с платформой Instinct, только после разбора и практического тестирования стало ясно, насколько глубоко GIGABYTE и AMD переосмыслили интеграцию CPU, GPU и HBM-памяти в одном модуле.

По сути, это не просто сервер с ускорителями Instinct. Это платформа с новой архитектурой, которая объединяет три ключевых компонента в одном APU и открывает путь к более компактным и энергоэффективным вычислительным системам.

Сервер не предназначен для повседневных задач. Однако наличие APU MI300A, используемых в ведущем суперкомпьютере мира, позволяет организациям — от университетов до исследовательских лабораторий — приобрести готовое решение для задач HPC, не создавая кластер уровня Top500. Это снижает барьер входа на рынок высокопроизводительных вычислений.

Платформа одновременно демонстрирует возможности и ограничения подхода AMD. С одной стороны, объединённая архитектура с 512 ГБ HBM3, ядрами Zen 4 и GPU CDNA3 в четырёх APU — это конкурентоспособное решение для задач HPC. С другой стороны, для некоторых ИИ-нагрузок может потребоваться больший объём памяти, чем доступен в конфигурации на HBM3.

Если задача эффективно масштабируется в рамках архитектуры MI300A, такая система обеспечивает высокую плотность вычислений и энергоэффективность. Для других сценариев она может быть просто примером интересной инженерной реализации.

Комментарии(0)

Новый комментарий

Новый комментарий отправлен на модерацию