Сегодня рассматриваем сервер MiTAC G8825Z5 — платформу с восемью GPU AMD Instinct MI325X и 2 ТБ памяти HBM3E. В системе установлены два высокоскоростных процессора AMD EPYC Turin. Также доступно до 12 слотов PCIe для подключения дополнительных устройств. У MiTAC есть собственный подход к сборке таких серверов — далее покажем, как он реализован.

Рассмотрим модель MiTAC G8825Z5U2BC-325X-575, которую для простоты будем называть MiTAC G8825Z5. Также сравним её с другими системами. Сначала посмотрим на шасси, затем перейдём к вычислительному модулю с GPU и модулю с CPU.

Обзор корпуса MiTAC G8825Z5

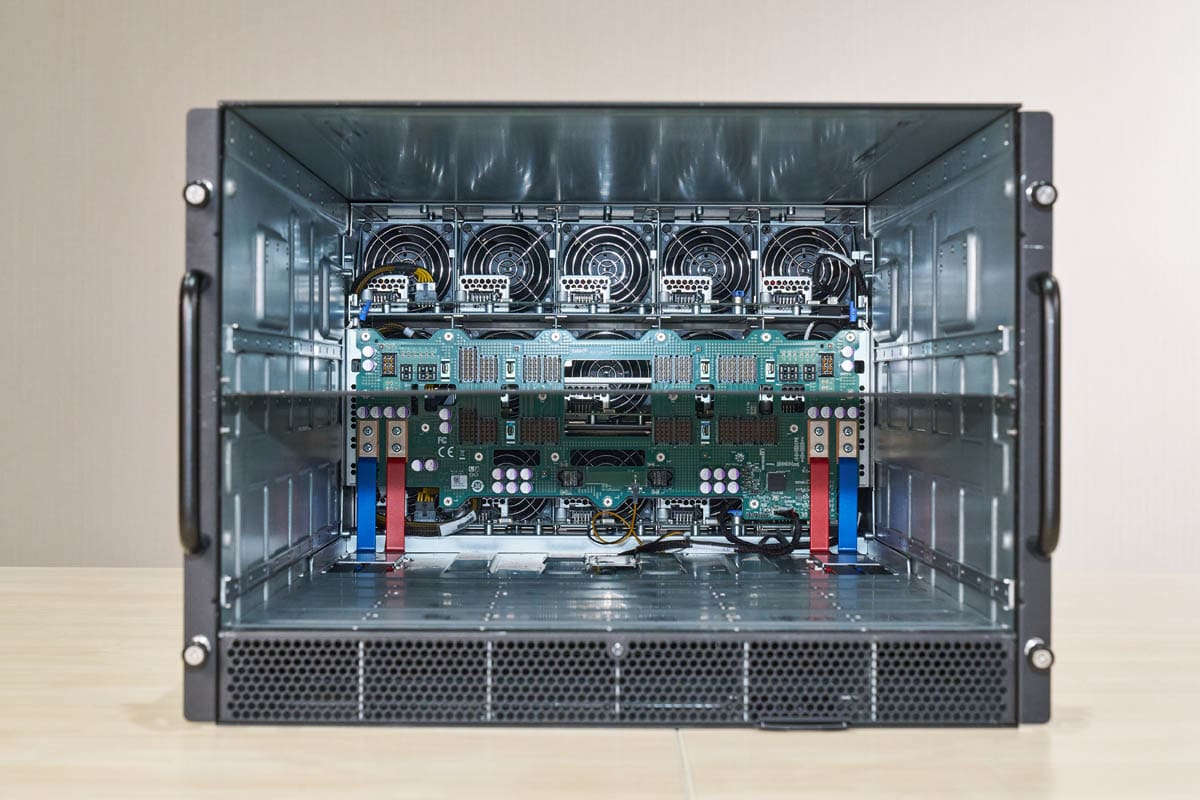

Система выполнена в корпусе формата 8U: GPU-модули размещены в верхней части, остальные компоненты — в нижней.

У сервера удобное обслуживание — основные компоненты размещены на выдвижных модулях, что упрощает доступ и замену.

К модулям вернёмся позже, а пока — вид шасси спереди без установленных лотков.

Верхняя часть корпуса в основном предназначена для воздушного потока, но здесь же расположены плотные разъёмы питания и передачи данных для 8-GPU модуля UBB. Важно учитывать, что разъёмы на стороне шасси требуют точной конструкции — сами UBB-коннекторы достаточно хрупкие.

В нижней части корпуса находится отсек для системной платы. Также видны внутренние направляющие, по которым выдвигаются оба модуля.

Сзади расположены блоки вентиляторов и блоки питания.

Всего установлено 15 вентиляторных модулей.

Все вентиляторы заменяются без выключения системы — доступ к ним осуществляется с задней стороны.

Вот как вентиляторные модули выглядят с внутренней стороны.

Система оснащена шестью блоками питания по 3,3 кВт с сертификатом 80Plus Titanium. Конфигурация — 4+2 с резервированием. На задней панели нет портов ввода-вывода, что многим заказчикам удобно.

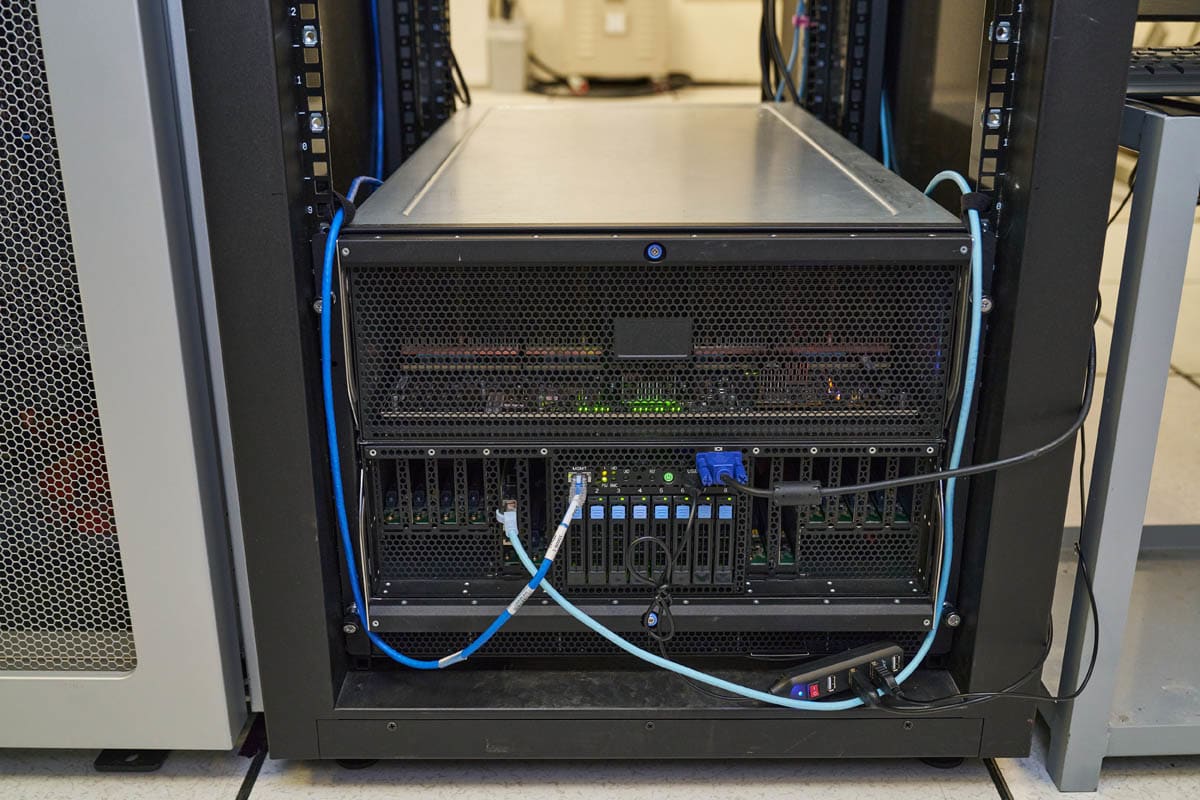

На этом фото видно, что все кабели, включая кабели для сетей управления, подключаются спереди.

А вот задняя часть системы — здесь подключаются только блоки питания.

Это связано с особенностями конструкции.

Материнская плата MiTAC G8825Z5 AMD EPYC и лоток коммутатора PCIe

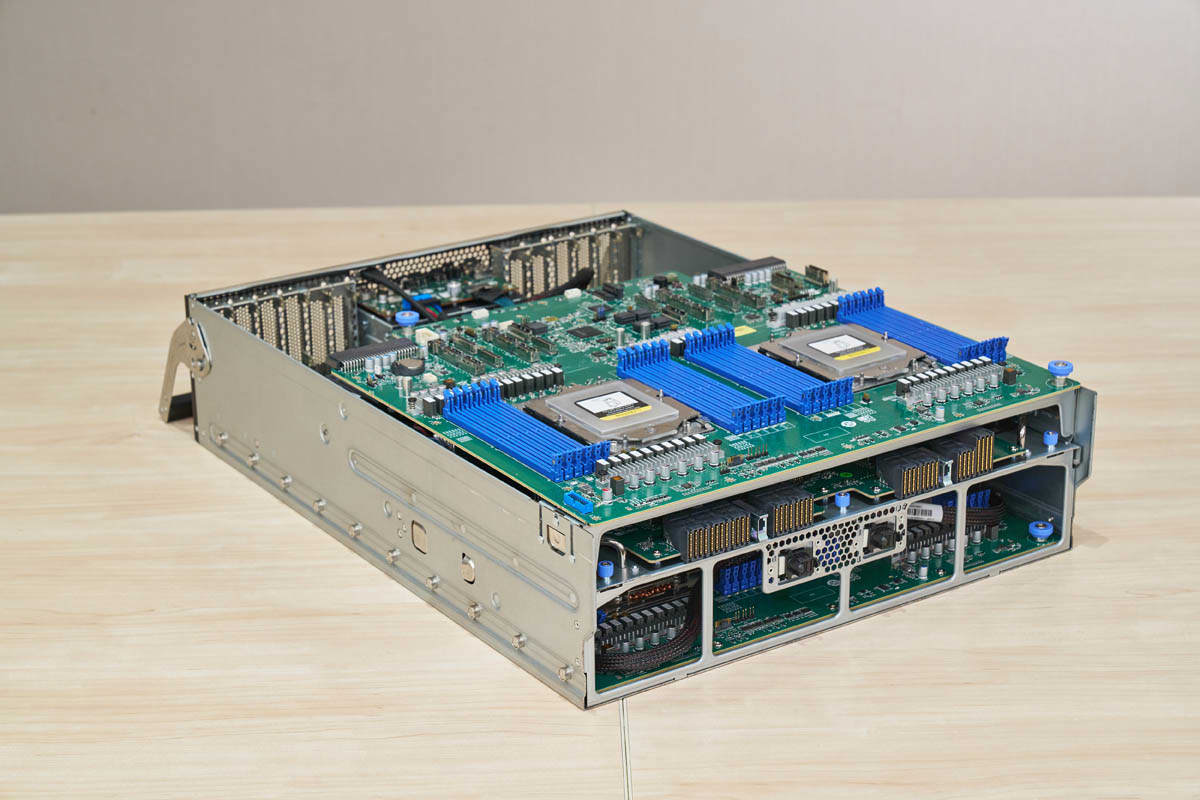

Вот модуль с материнской платой и PCIe-коммутатором.

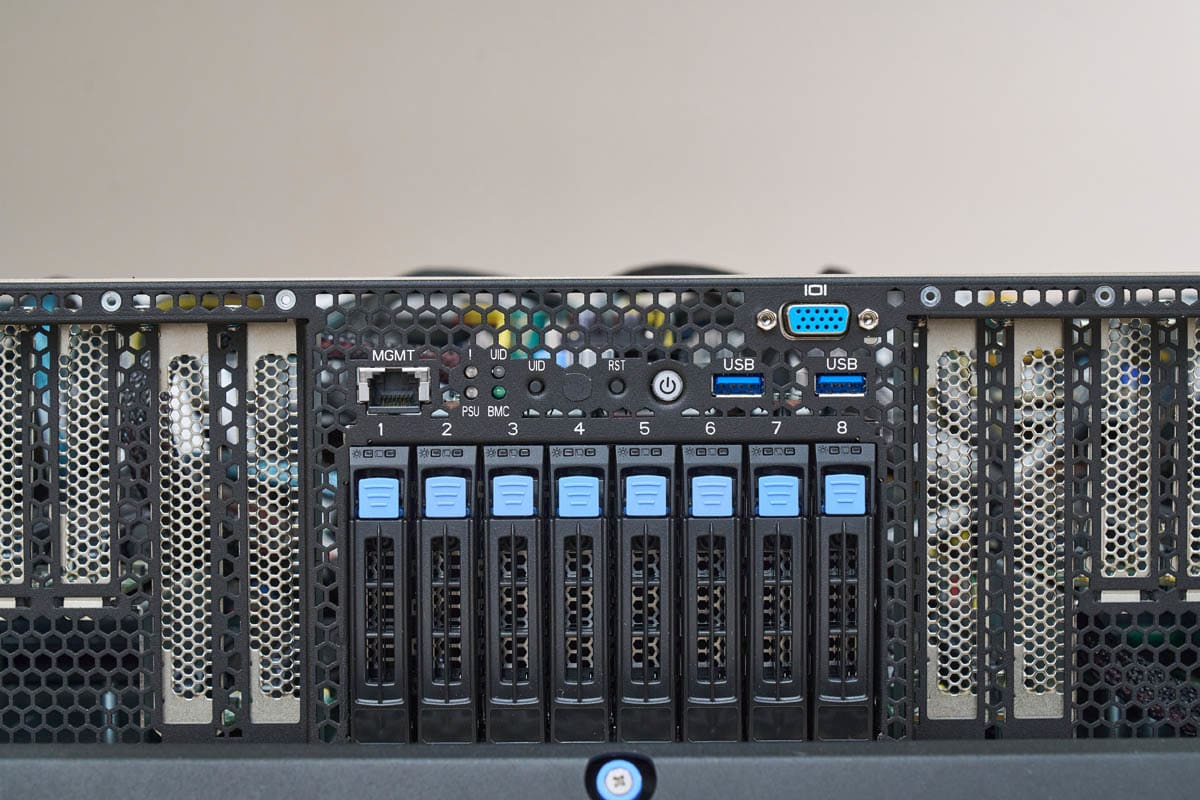

Спереди расположены 12 слотов PCIe, накопители и порты фронтальной панели.

В центральной части — восемь отсеков для NVMe-накопителей, рядом расположены разъёмы фронтальной панели.

Фронтальная панель включает порт управления, два USB-порта и VGA-разъём. Все они подключены через выносную плату с кабелями, которую видно ниже.

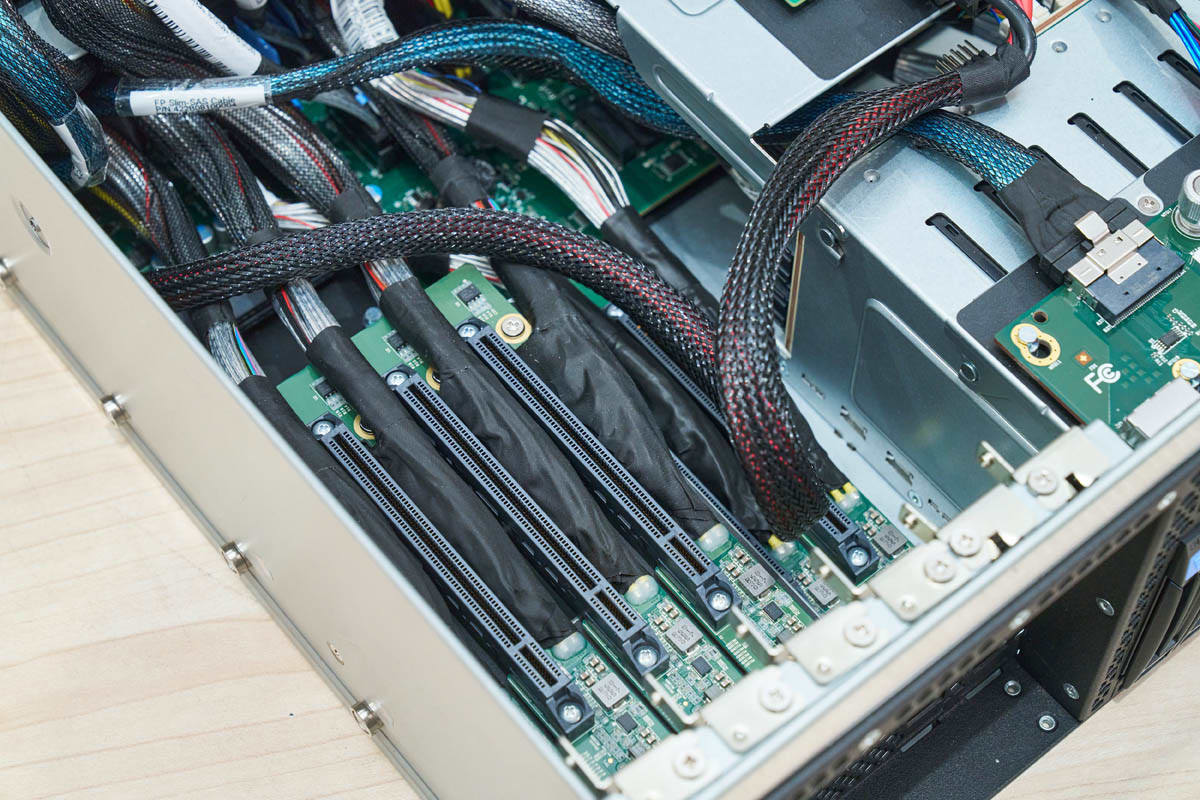

Слева и справа размещены по шесть слотов PCIe — всего двенадцать.

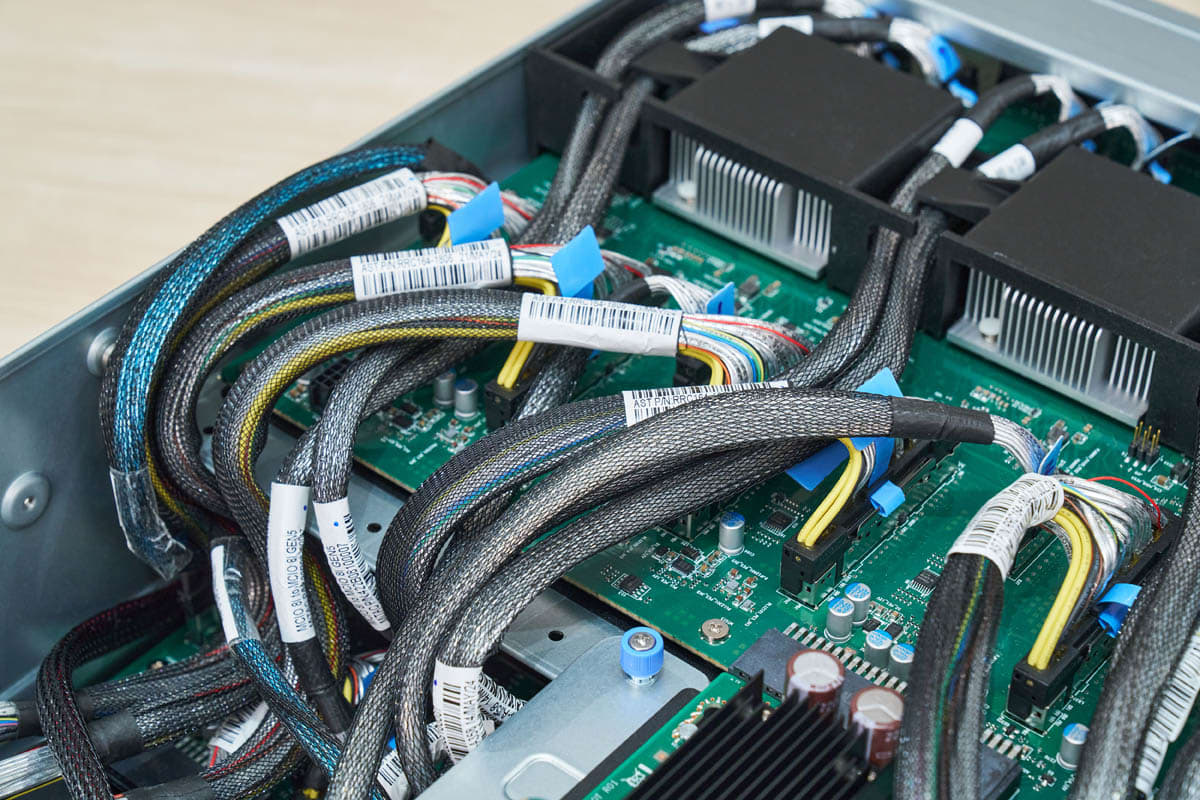

Вот вид с обеих сторон. Обращает на себя внимание большое количество кабелей — и это повторяется по всей системе.

В задней части модуля с процессорами находятся разъёмы питания и высокоплотные соединители для подключения к другим частям системы.

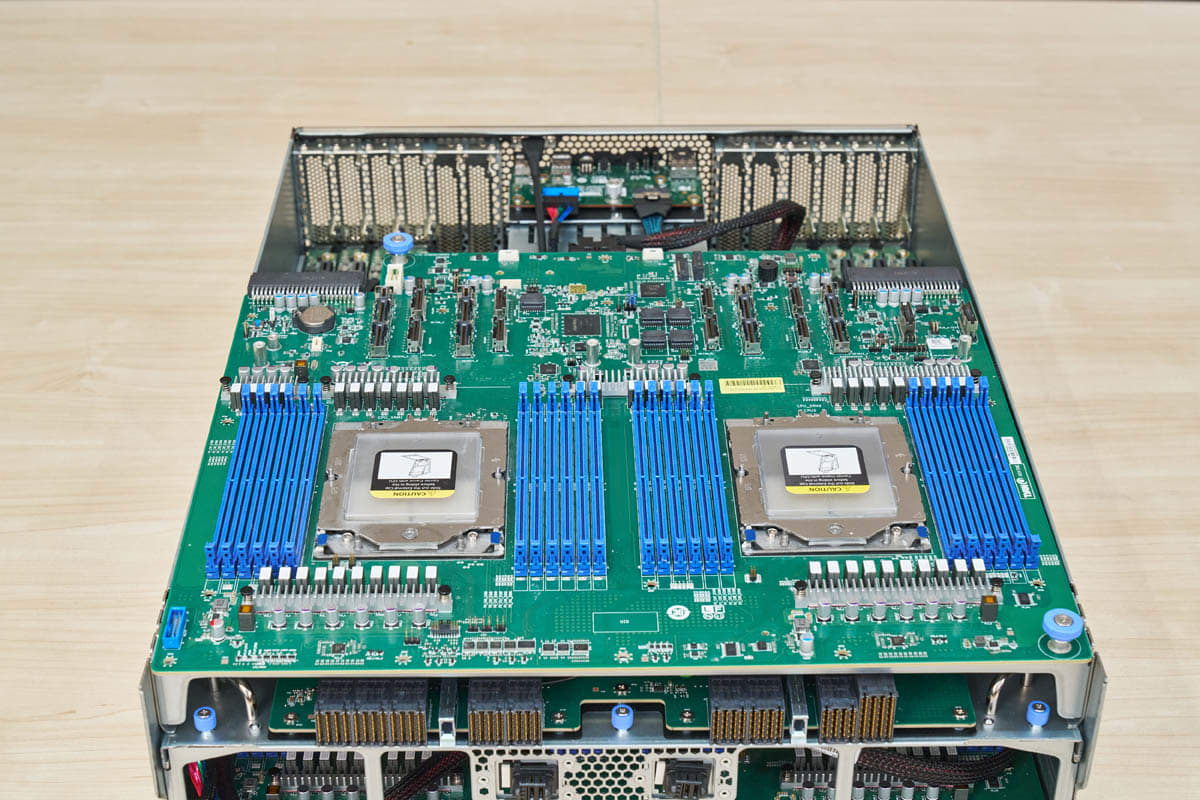

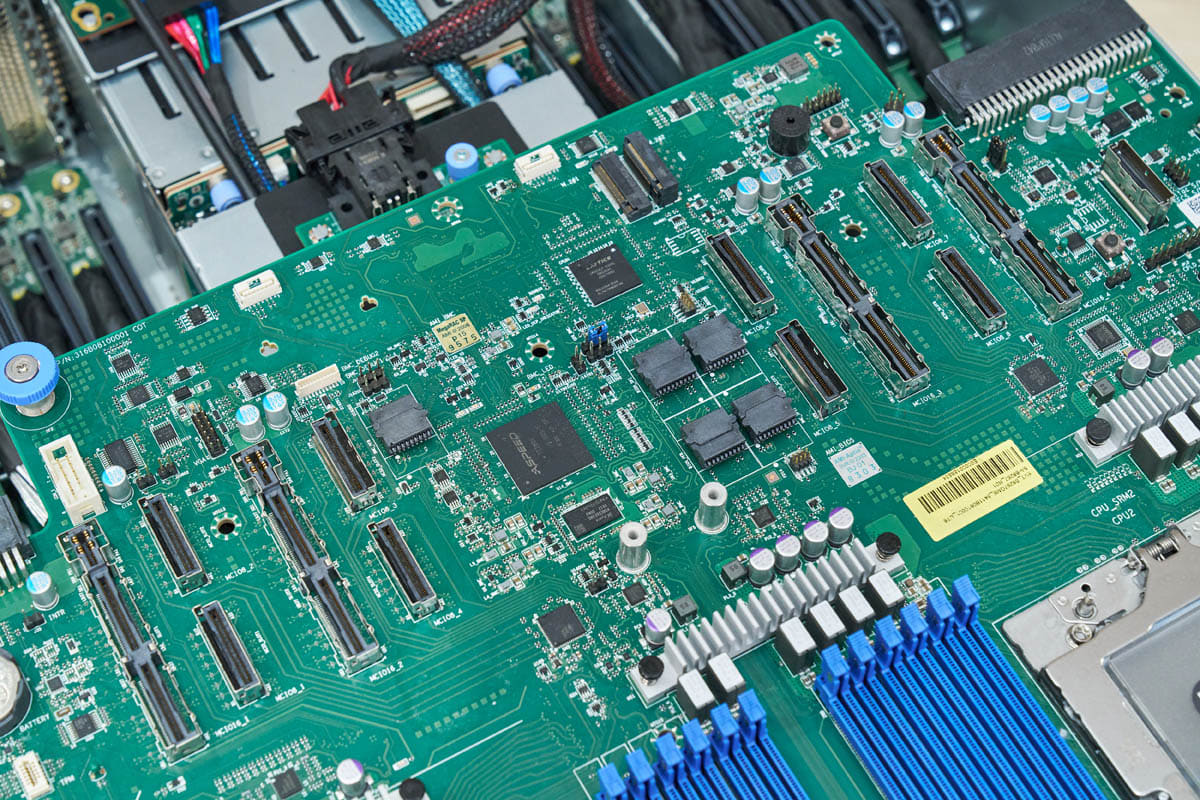

В верхней части модуля установлена плата PCIe-коммутатора, в нижней — материнская плата.

Чтобы показать материнскую плату, мы использовали второй экземпляр. В оригинальном модуле она находится под платой PCIe-коммутатора, и из-за большого количества кабелей проще и безопаснее было показать её отдельно.

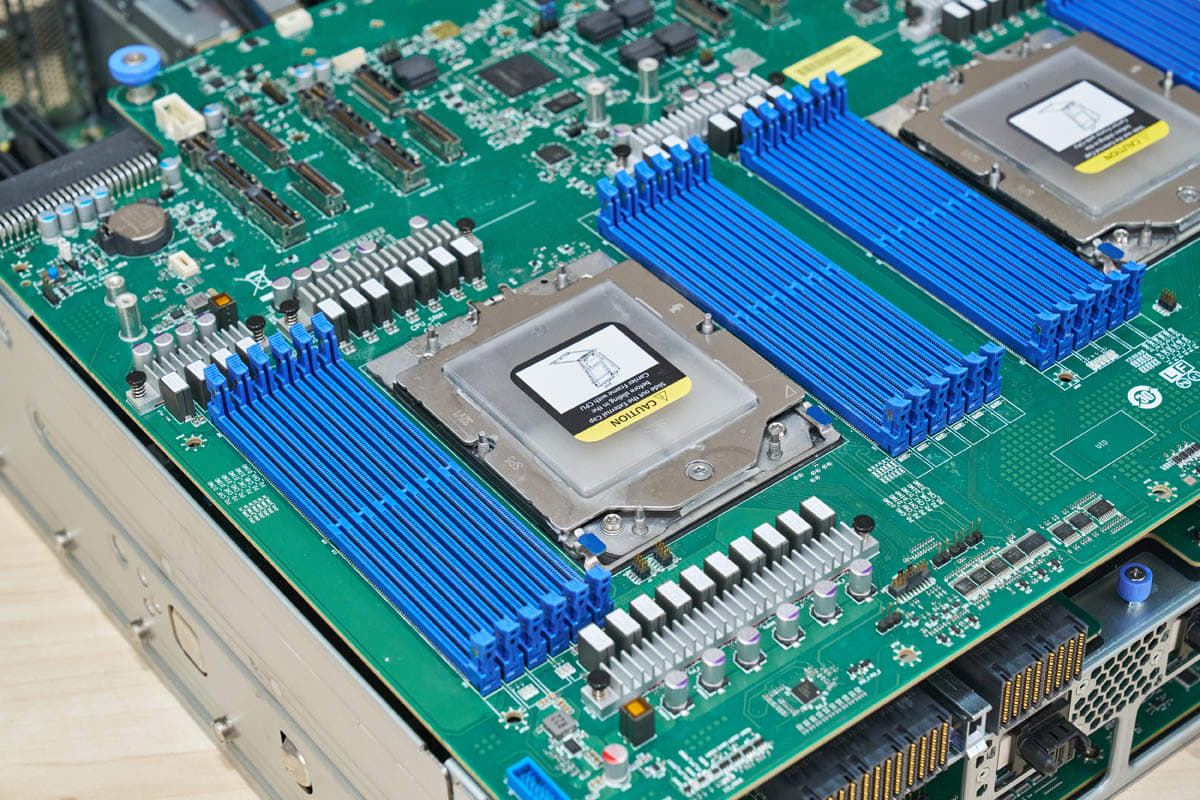

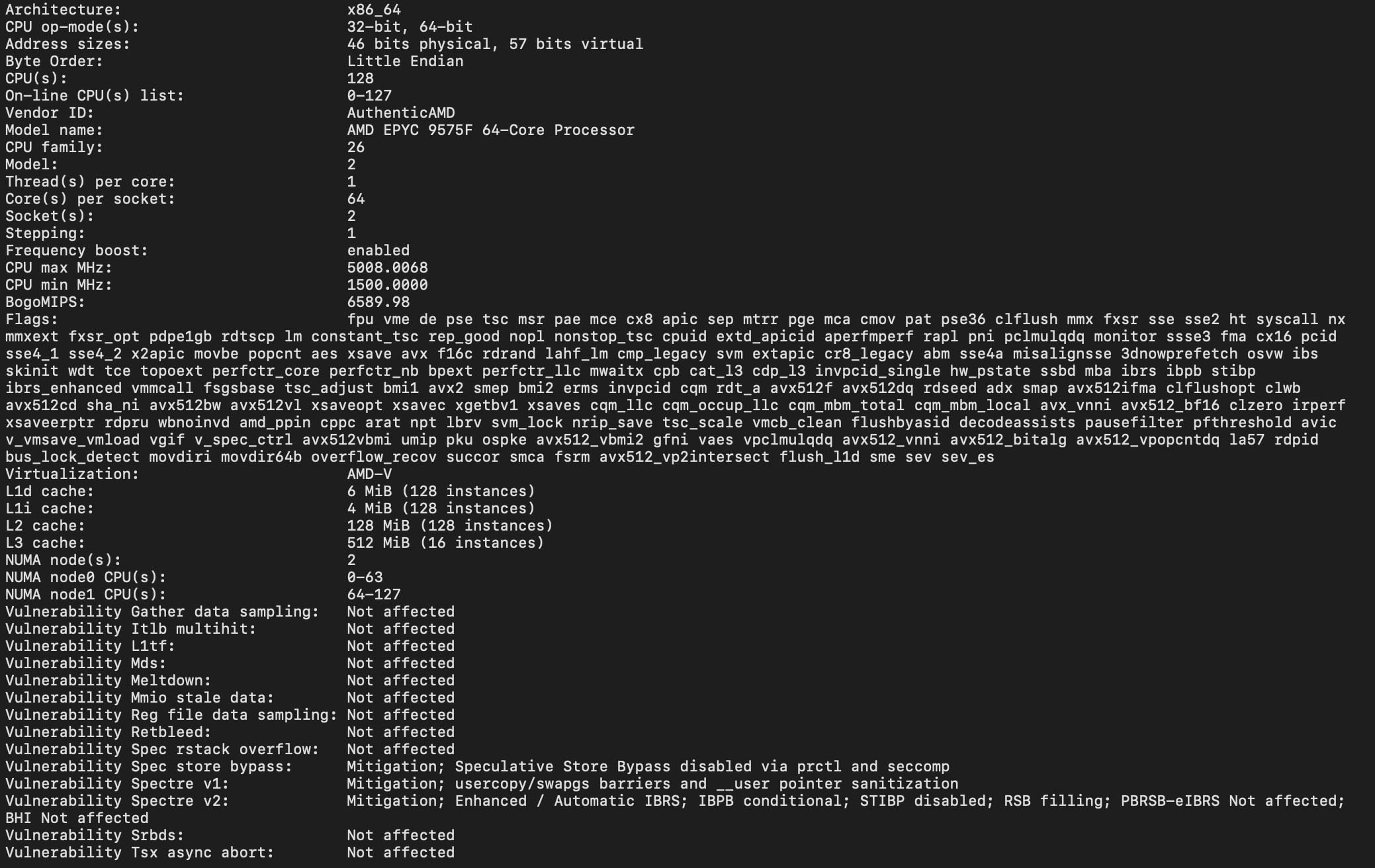

Здесь видно два сокета под процессоры AMD EPYC SP5. В тестовой системе использовались 64-ядерные AMD EPYC 9575F с высокой тактовой частотой. При необходимости можно установить и 192-ядерные процессоры.

Каждый сокет поддерживает двенадцать модулей DDR5 RDIMM — всего 24 слота на систему.

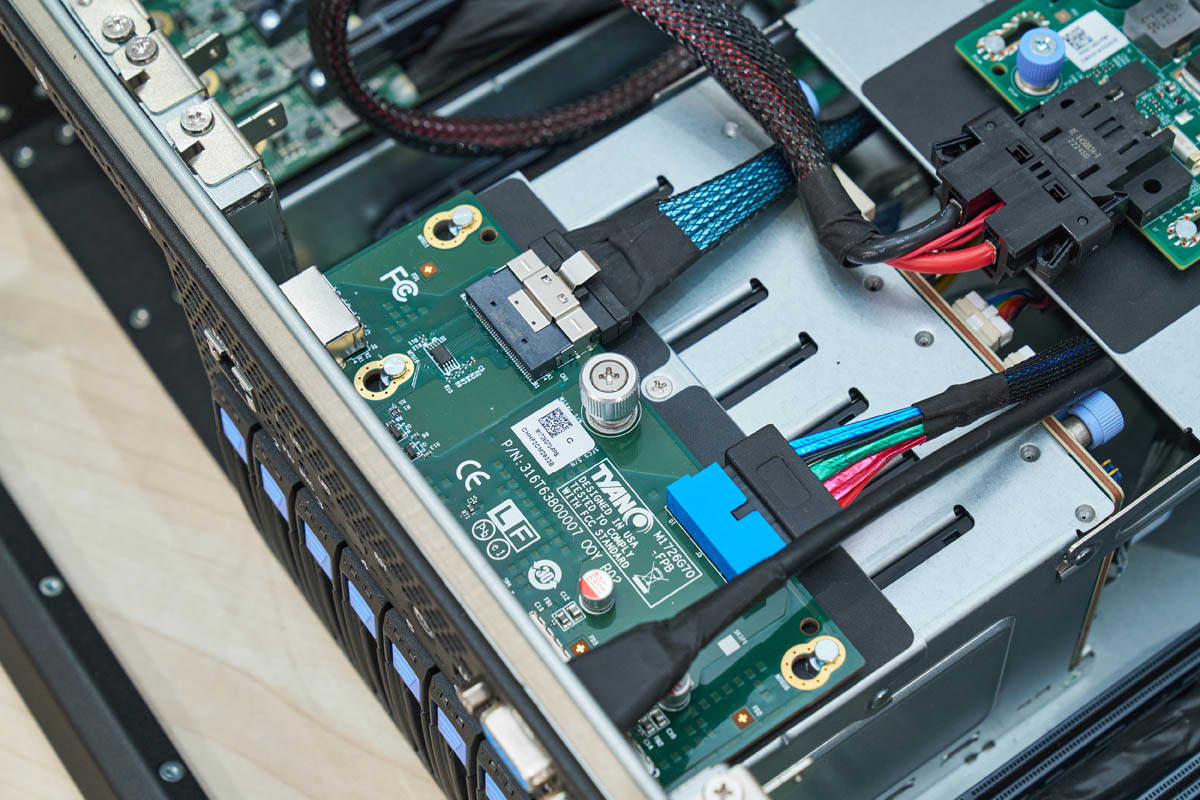

На задней стороне материнской платы размещены разъёмы для подключения остальных компонентов системы. Здесь же видны контроллер управления ASPEED AST2600 (BMC), слот для накопителя M.2 и входы питания.

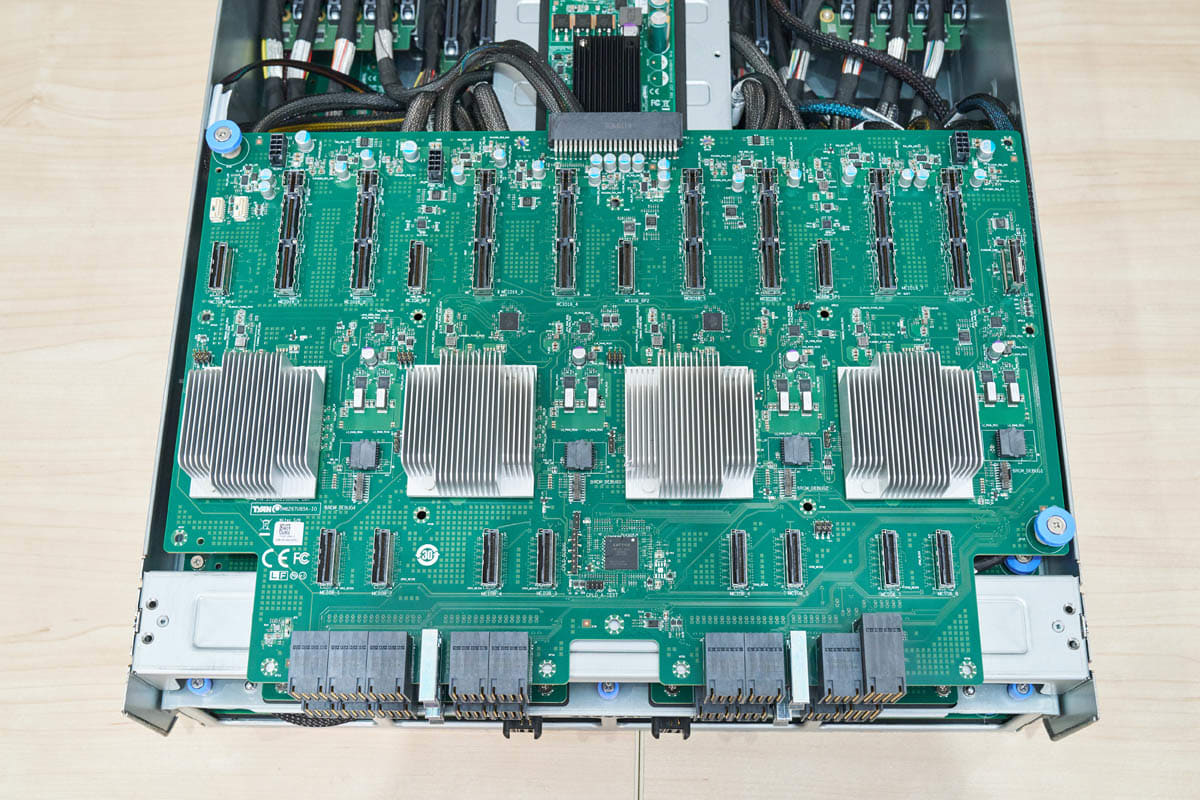

Над материнской платой установлена плата PCIe-коммутатора.

Здесь представлена и сама плата PCIe-коммутатора. На ней видно большое количество разъёмов и четыре PCIe-коммутатора, обеспечивающие маршрутизацию сигнала между CPU, GPU и другими устройствами.

Такое количество разъёмов объясняется тем, что общая потребность в PCIe-линияx превышает возможности процессоров AMD EPYC. Для 12 слотов PCIe Gen5 x16 (192 линии), 8 GPU (128 линий) и 8 NVMe SSD (32 линии) требуется больше ресурсов, чем могут предоставить CPU напрямую. Кроме того, в ряде задач важно, чтобы трафик шёл через PCIe-коммутатор, а не между корневыми портами на процессорах. Всё это приводит к большому числу соединительных кабелей в системе.

MiTAC G8825Z5 AMD Instinct MI325X UBB Tray

Для сравнения: модуль UBB потребляет больше энергии, но его конструкция проще — легче отследить, как именно распределяются подключения и что происходит внутри.

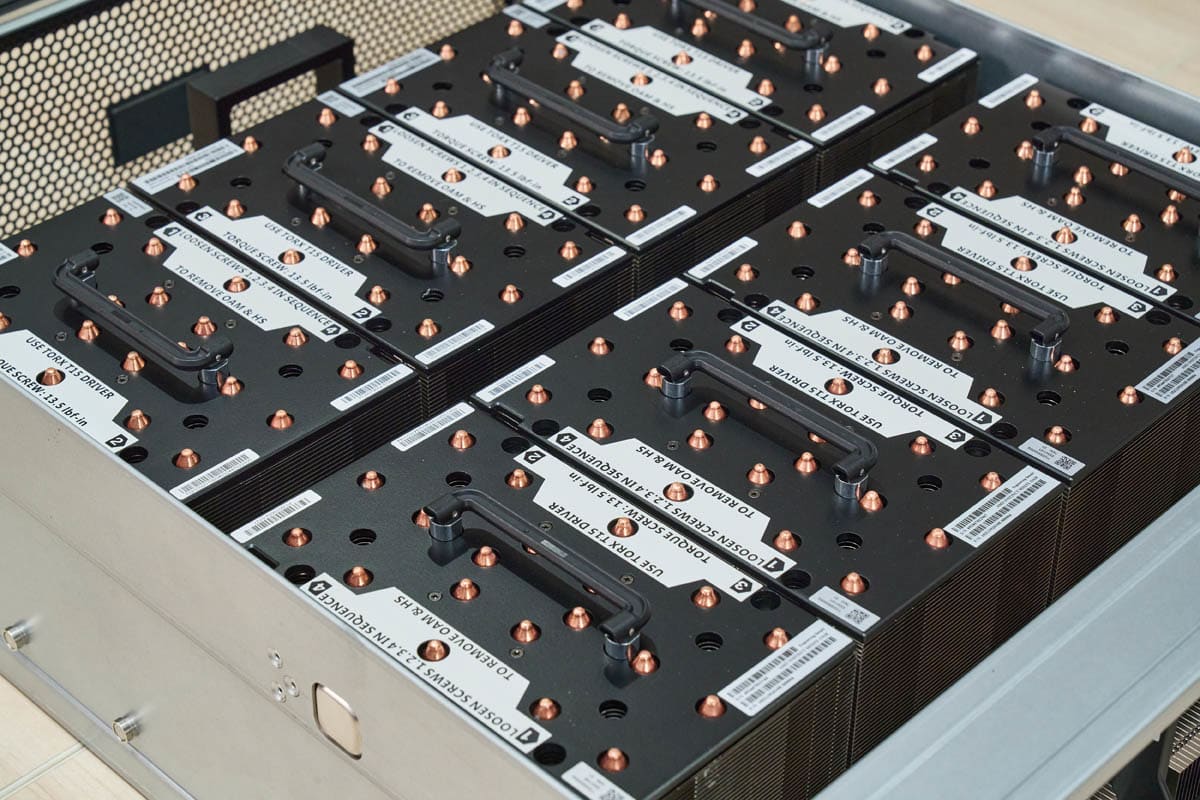

Главная особенность — восемь модулей OAM с ускорителями AMD Instinct MI325X. Каждый оснащён 256 ГБ памяти HBM3E, что даёт суммарно 2 ТБ HBM на систему. AMD подчёркивает именно объём памяти: это позволяет загружать более крупные модели локально, без обращения к другим серверам по сети.

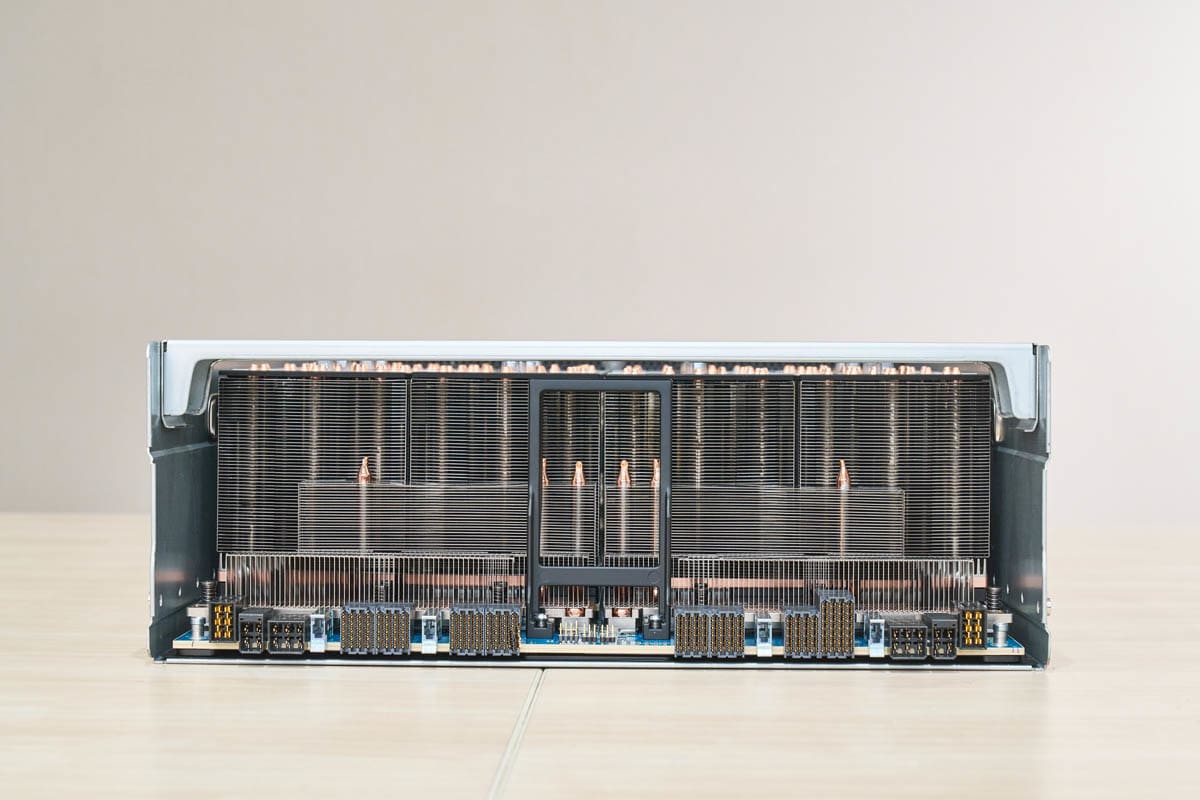

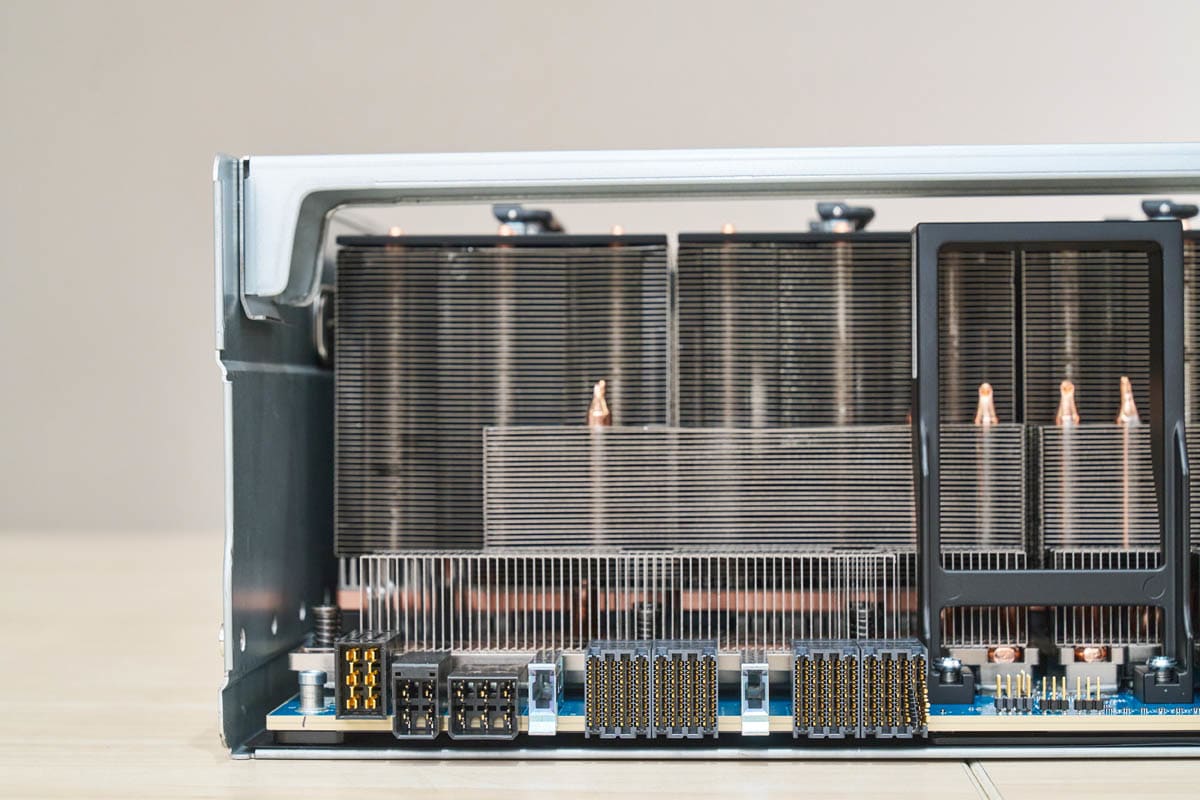

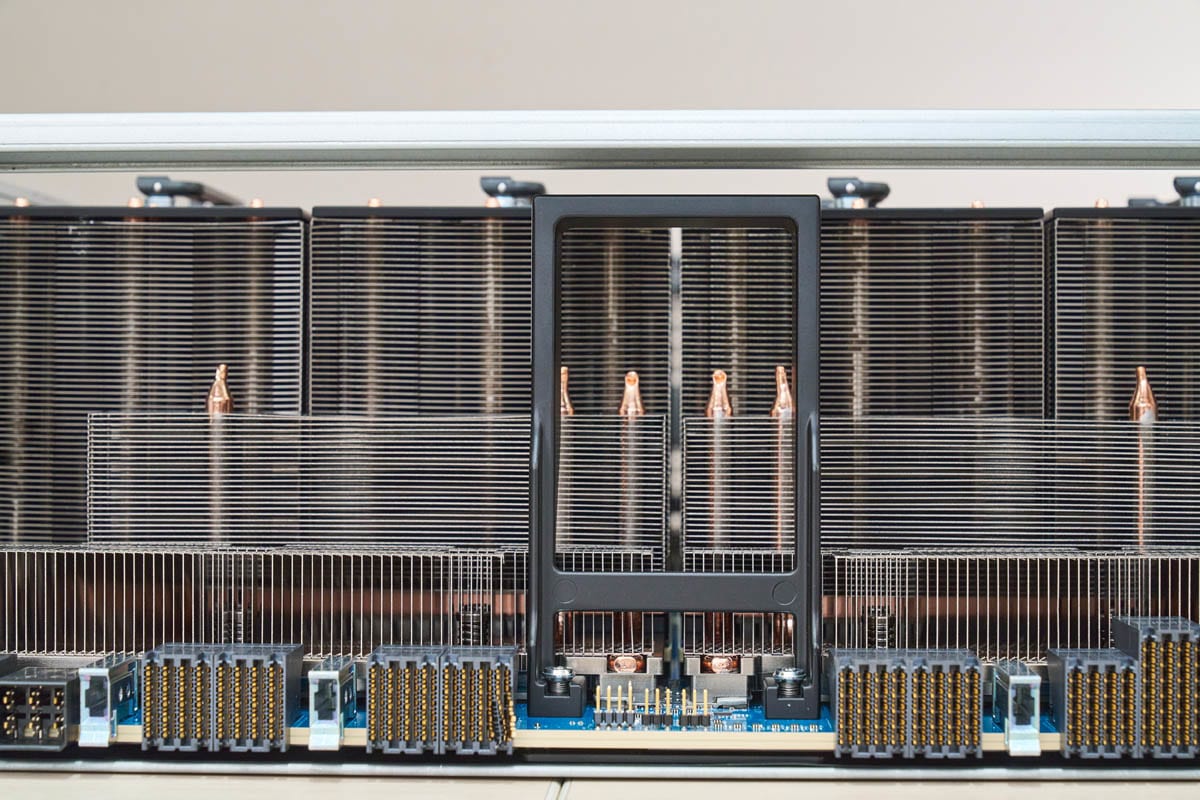

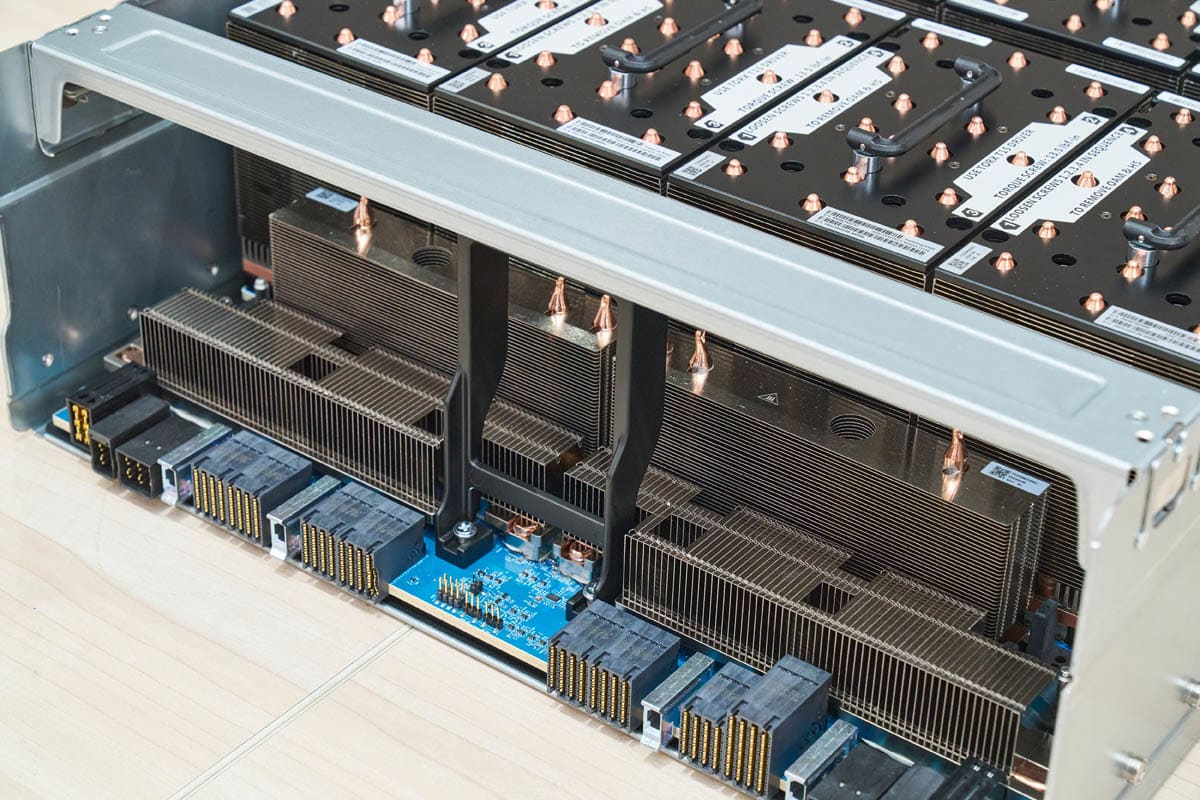

С обратной стороны расположены разъёмы UBB и массив радиаторов охлаждения.

Крупные радиаторы в задней части модуля охлаждают GPU. Каждый ускоритель рассчитан на TDP до 1 кВт, поэтому в сервере с воздушным охлаждением требуются массивные теплоотводы.

На базовой плате также установлены стандартные разъёмы UBB для подключения GPU-модулей.

В передней части установлено управляющее устройство AMD для базовой платы — оно отвечает за работу и взаимодействие компонентов UBB-модуля.

На плате также установлены радиаторы для PCIe-ретаймеров. Эти компоненты обеспечивают целостность сигнала между базовой платой и PCIe-коммутаторами, особенно при работе на высоких скоростях передачи данных.

Если вы подумали, что это за большие чёрные элементы — это ручки. Вот как выглядит модуль, когда его перемещают с помощью этих ручек.

Как упоминалось ранее, разъёмы UBB довольно хрупкие. На этом экземпляре один из них оказался повреждён, и мы заменили его перед съёмкой. С учётом запасной материнской платы, платы PCIe-коммутатора и дополнительного UBB-модуля MI325X, хорошо, что съёмка проходила прямо в штаб-квартире MiTAC — всё нужное было под рукой.

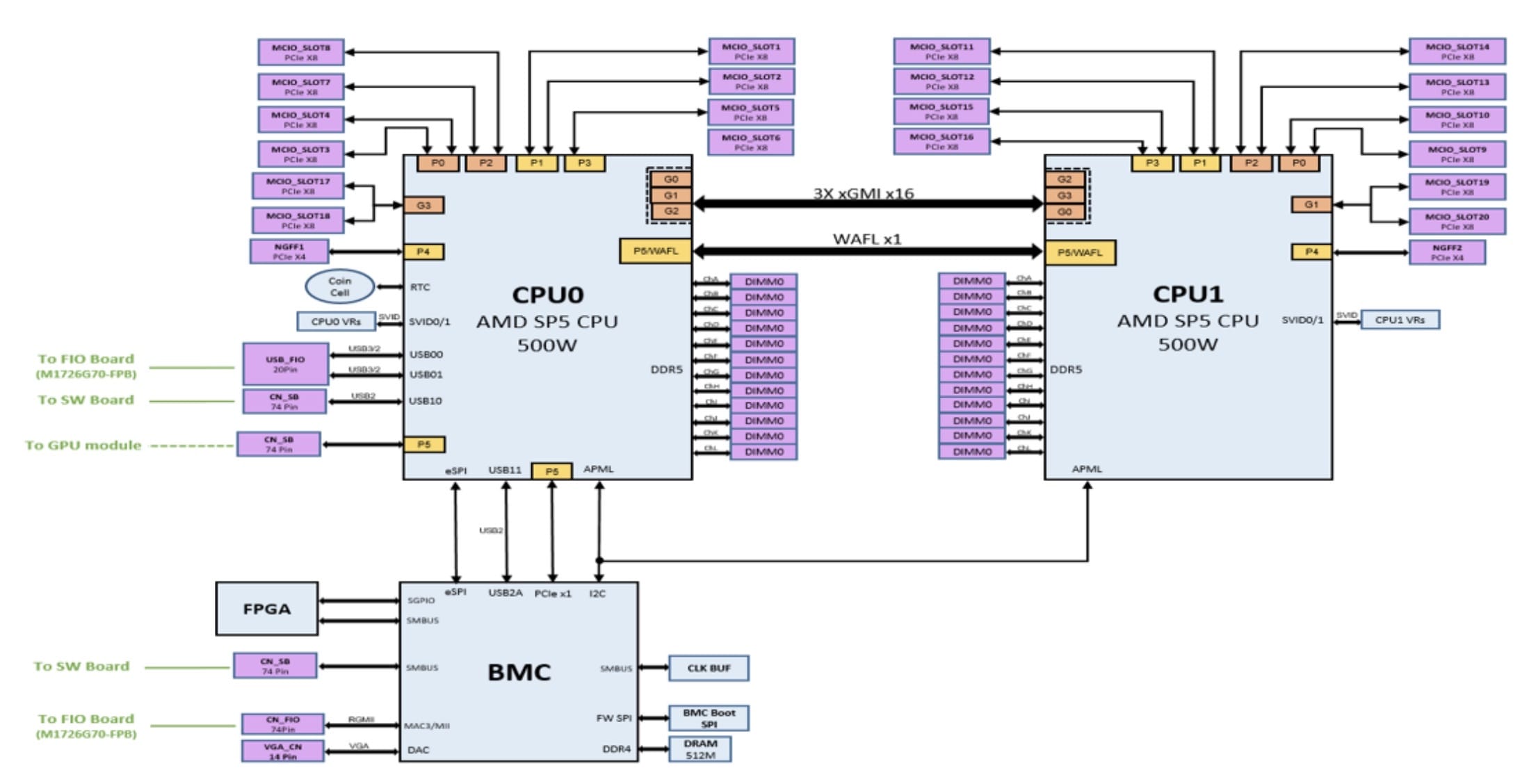

Блок-схема и топология MiTAC G8825Z5

Блок-схему всей системы найти не удалось — доступна только схема материнской платы. Из неё видно, что между двумя сокетами AMD SP5 используется три соединения xGMI. В системах с AMD Instinct MI325X такая конфигурация встречается чаще, чем четырёхканальная xGMI. Это связано с тем, что GPU масштабируются через выделенные сетевые интерфейсы, а не за счёт межсокетного обмена.

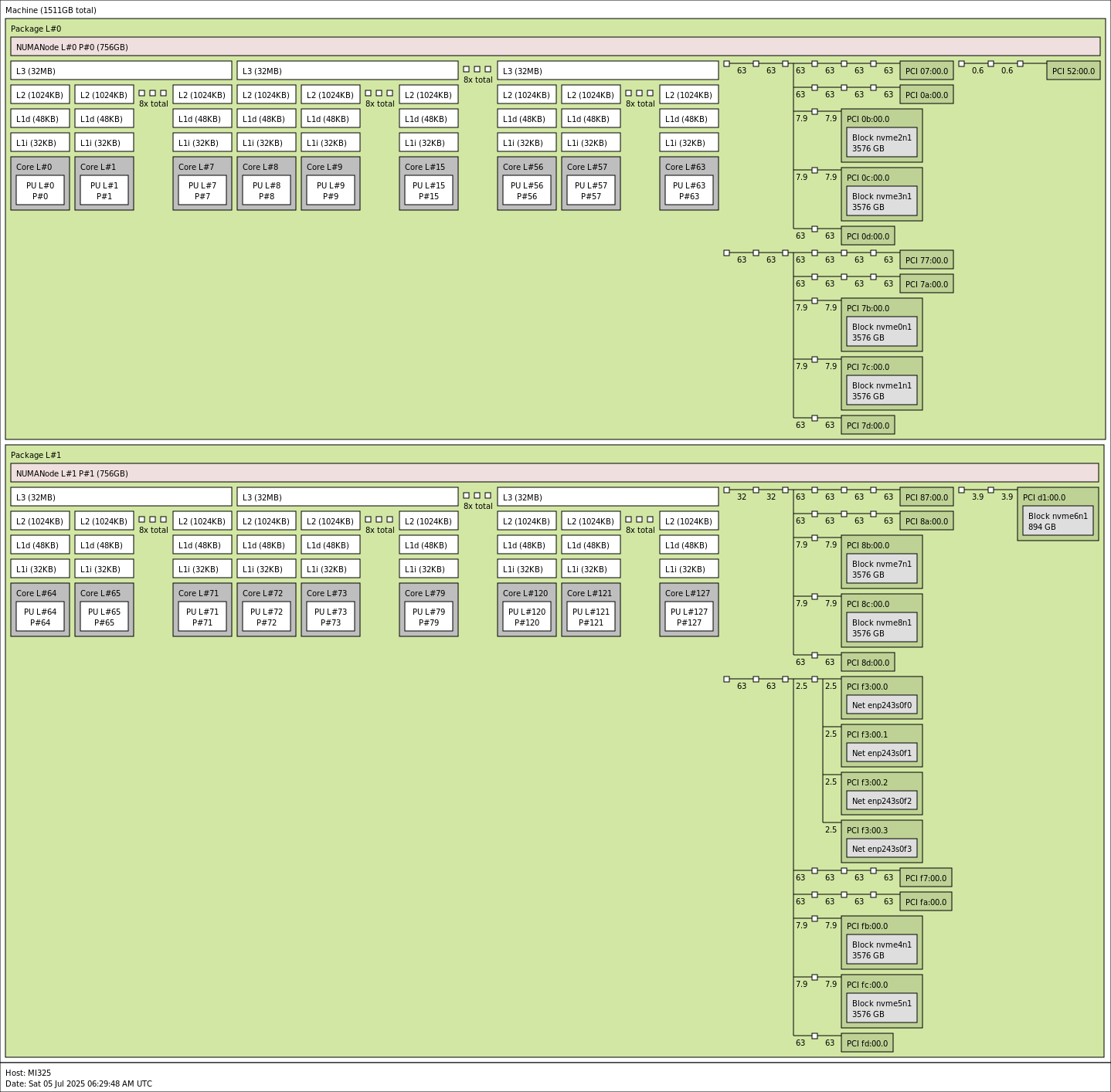

Вот краткая схема топологии системы

Как видно, в системе установлено большое количество компонентов. Текущая конфигурация предназначена для тестирования одного узла, поэтому в масштабируемом варианте возможны изменения — например, в подсистеме хранения и конфигурации сетевых адаптеров.

Производительность MiTAC G8825Z5

В плане производительности система использует два процессора AMD EPYC 9575F — популярные 64-ядерные модели с высокой тактовой частотой. В выборе процессоров для таких систем есть два подхода: одни выбирают максимальное число ядер, другие — меньше ядер, но выше частота. Здесь реализован второй подход, ориентированный на высокую частоту для задач, чувствительных к задержкам и однопоточной производительности.

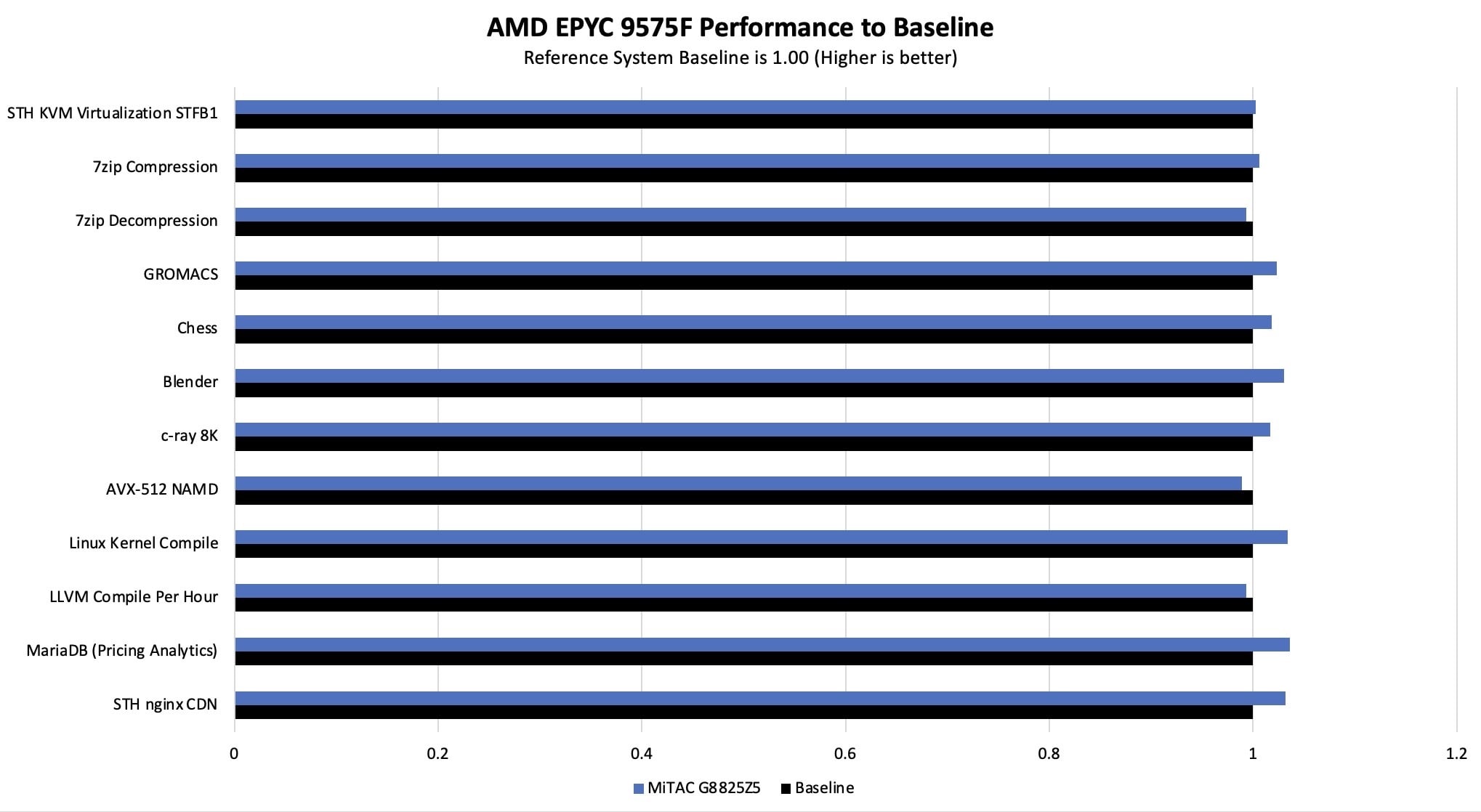

Тем не менее, мы решили проверить, соответствует ли производительность процессоров ожиданиям, и сравнили результаты с эталонным 2U-сервером.

Одной из основных задач в крупных AI-серверах остаётся эффективное охлаждение процессоров. MiTAC справляется с этим хорошо — температура CPU остаётся в допустимых пределах даже при высокой нагрузке.

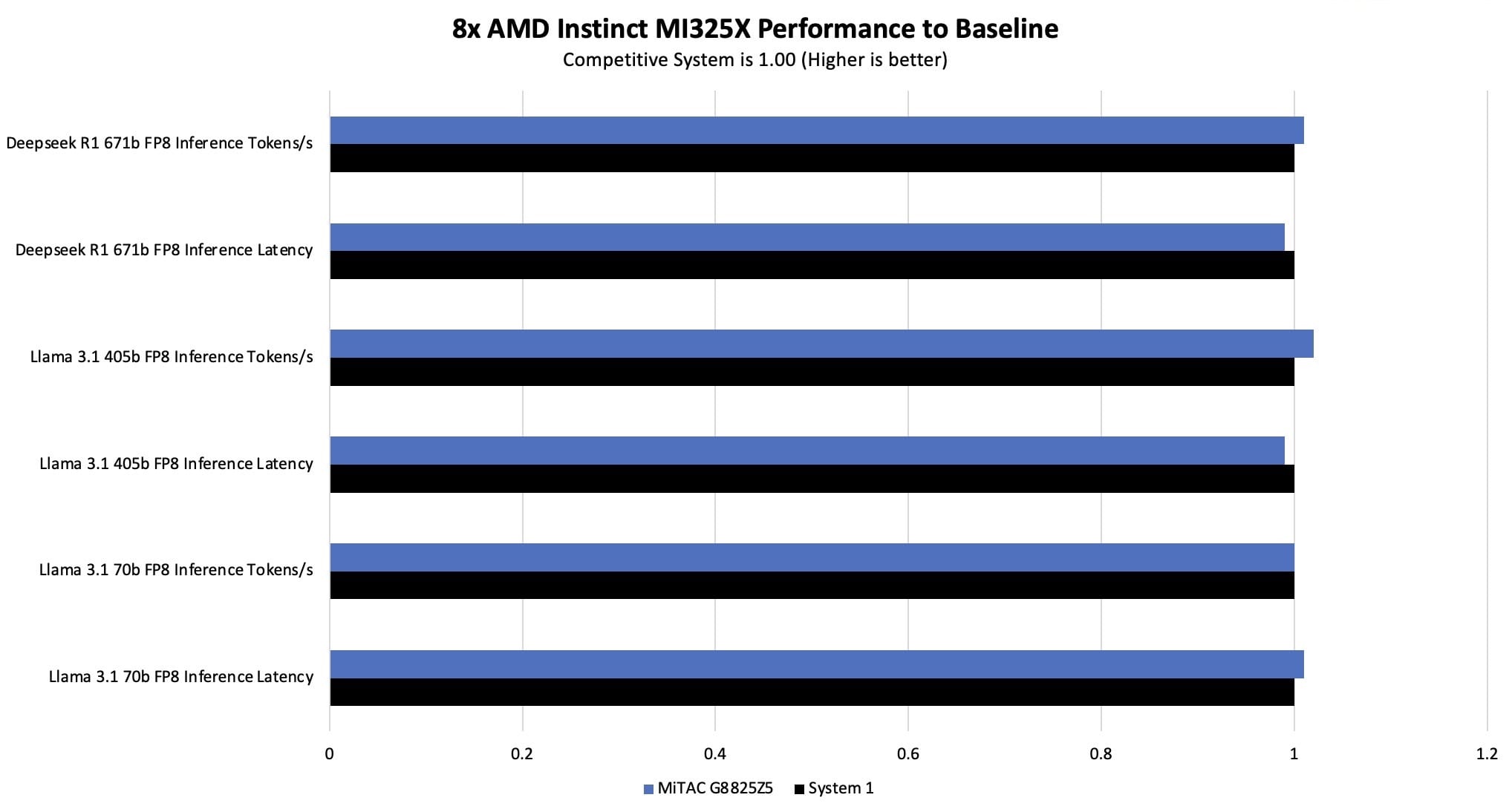

Для тестирования GPU мы использовали несколько систем. Модель Llama 3.1 запускалась через vLLM с 128 входными и 2048 выходными токенами — это оптимальное соотношение, которое мы ранее определили. Размер батча — 8, что использовалось для сравнения задержек. Для Deepseek-R1 применяли sglang с теми же 128/2048 токенами и параллельностью 64; метрикой была средняя задержка между токенами. Производительность оказалась сопоставимой с другими системами. Впечатляет, что такие модели могут достигать скорости генерации до 5000 токенов в секунду — особенно учитывая их размер и качество.

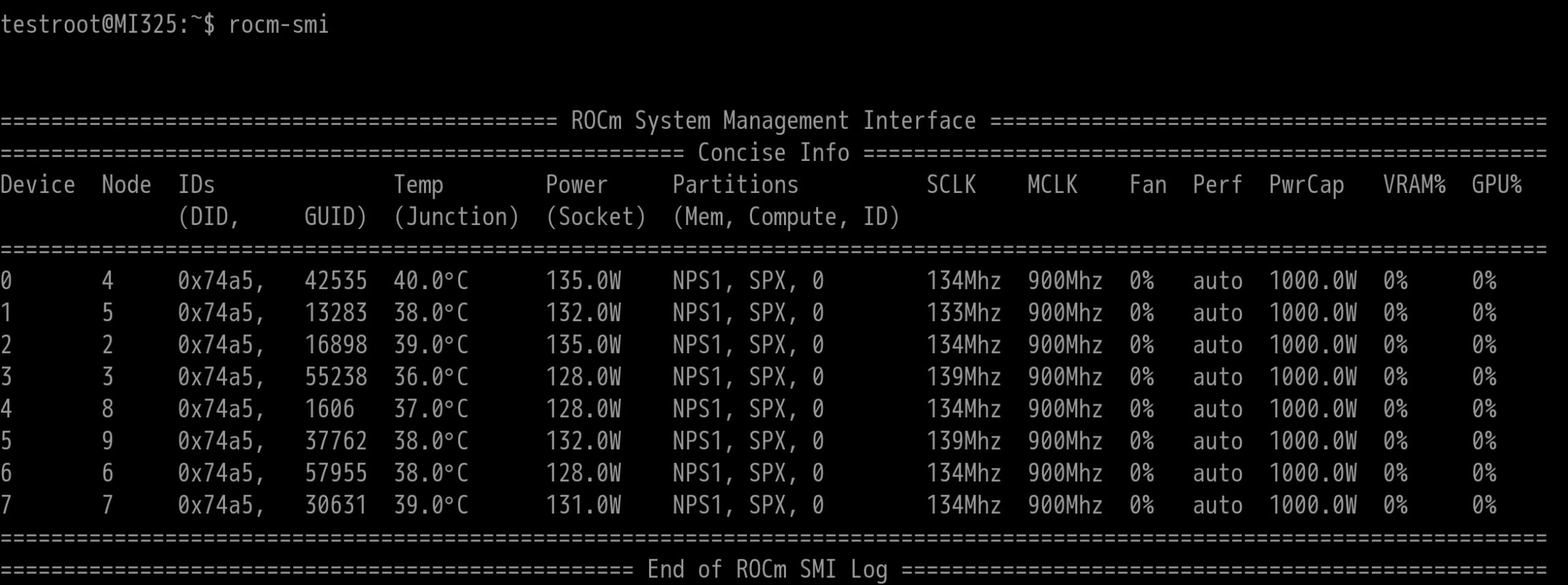

Платформа MiTAC показывает отличные результаты. Особенно хорошо реализована система охлаждения GPU — это видно на скриншоте в разделе с данными по энергопотреблению. Даже при высокой нагрузке ускорители работают в оптимальном температурном режиме.

Потребляемая мощность MiTAC G8825Z5

По энергопотреблению система не была подключена к нашему стандартному мониторингу на уровне PDU. Однако встроенная телеметрия дала несколько интересных наблюдений — они позволяют оценить поведение системы под нагрузкой и эффективность охлаждения.

Поддерживать температуру GPU в пределах 36–40 °C на холостом ходу — отличный результат. При этом даже в простое восемь GPU потребляют более 1 кВт, а под нагрузкой — до 8 кВт только на ускорители. В системах с воздушным охлаждением к этому добавляется энергопотребление системы охлаждения, до 1 кВт на CPU и ещё 1 кВт и более на остальные компоненты. В сумме такие серверы легко достигают 12 кВт при полной загрузке — это характерно для мощных AI-платформ.

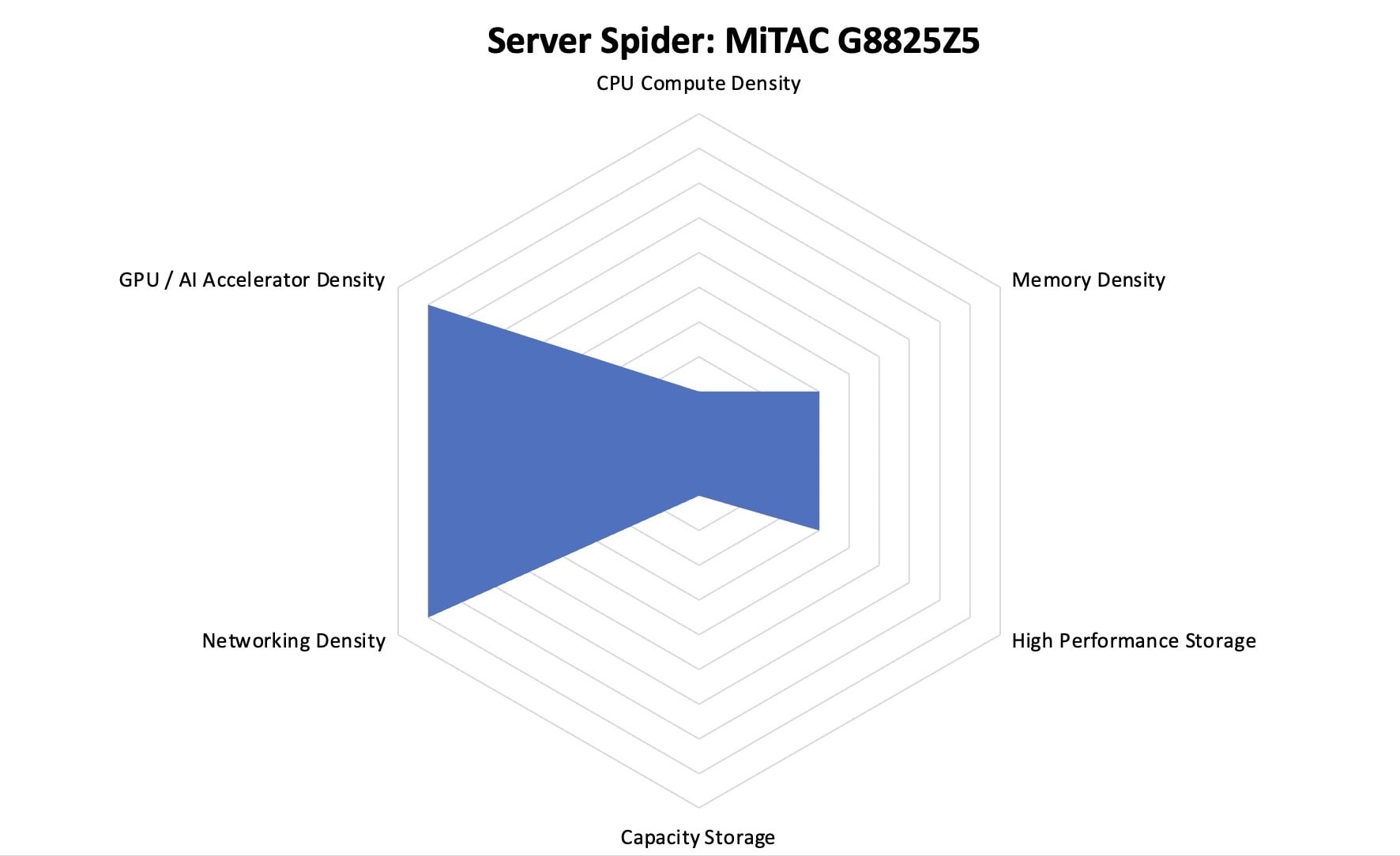

Server Spider: MiTAC G8825Z5

Server Spider показывает, для каких задач подходит сервер и наглядно отображает ключевые параметры системы.

Этот сервер рассчитан на задачи ИИ и оснащён памятью HBM3E. В корпусе высотой 8U MiTAC разместила 12 слотов PCIe, что обеспечивает широкий запас для сетевых карт и других модулей.

Заключение

Система состоит из двух зон: лотка с GPU и лотка с CPU/PCIe. Такая конструкция упрощает обслуживание и улучшает охлаждение. Восемь GPU AMD Instinct MI325X с общей памятью 2 ТБ HBM3E обеспечивают высокую производительность для задач ИИ.

Мы увидели эту систему с GPU MI325X в январе 2025 года, на раннем этапе её применения. За последние кварталы AMD усилила позиции своих GPU: появились более крупные модели и больший акцент на задачи инференса. Система отражает эти изменения и выглядит перспективно для работы с ИИ.

MiTAC G8825Z5 выполнен удачно. Вся I/O вынесена на фронтальную панель, а сзади остаются только блоки питания и вентиляторы. Это упрощает обслуживание системы.

Комментарии (0)

Новый комментарий

Новый комментарий отправлен на модерацию