Внимание

Мы работаем в штатном режиме. Наши склады готовы поставлять оборудование клиентам из Российской Федерации несмотря на санкционные запреты ЕС и США. Оборудование в РФ ввозится легально благодаря новому законодательству с параллельным импортом. Звоните и уточняйте! Информация актуальна на 14.12.25В связи с участившимися случаями недобросовестной конкуренции обращаем ваше внимание, что мы не передаем персональные данные третьим лицам

Поиск по сайту

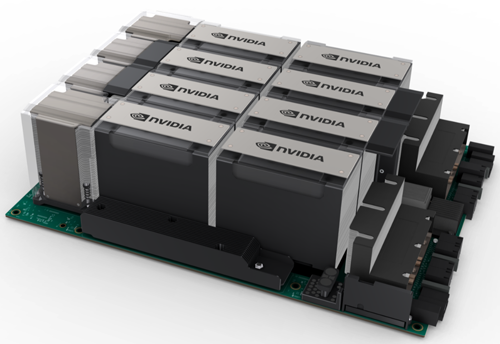

GPU‑сервер NVIDIA с 8 ускорителями NVIDIA H100 (SXM)

Гарантия до 5 лет

Диагностика перед отправкой

С нами выгодно и удобно!

- Поддержка персонального менеджера

- Партнёрские скидки до 70%

- Онлайн-кабинет гарантийного сервиса

Как купить?

Раз, два и все делаРассчитаем стоимость

Присылайте спецификацию для подбора и расчета стоимости оборудования

Привезём и подключим

Подключим и настроим оборудование в вашем офисе или ЦОДе

Характеристики

Комплектующие для GPU‑сервера NVIDIA с 8 ускорителями NVIDIA H100 (SXM)

Лицензии

Отсрочка платежа

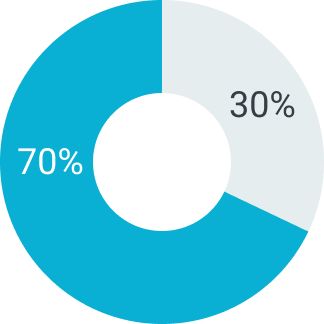

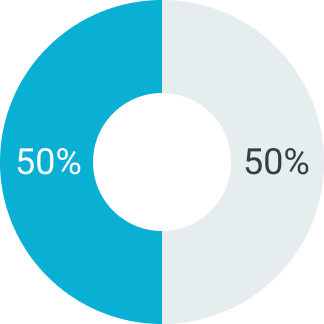

В зависимости от суммы поставляемого товара можем предоставить отсрочку платежа на срок от 5 до 90 дней. Условия отсрочки платежа рассматриваются индивидуально. Подробную информацию уточняйте у вашего менеджера.

Первый платеж

Второй платеж

Первый платеж

Второй платеж

Первый платеж

Второй платеж

Описание

GPU‑сервер NVIDIA с 8 ускорителями NVIDIA H100 (SXM) представляет собой мощную платформу для выполнения самых требовательных задач в области искусственного интеллекта, глубокого обучения и HPC. Оборудованный восемью графическими процессорами NVIDIA H100 на архитектуре Hopper, каждый с 80 ГБ памяти HBM3 и пропускной способностью до 3,35 ТБ/с, сервер обеспечивает высокую производительность для ускоренного обучения масштабных AI-моделей и сложных вычислительных задач.

Архитектура NVIDIA H100 SXM и технологические характеристики

Ускорители NVIDIA H100 выполнены по 4-нм техпроцессу и оснащены 456 тензорными ядрами четвёртого поколения, поддерживающими передовые числовые форматы FP8 и FP16 для повышения производительности и точности. Каждый GPU оборудован 80 ГБ памяти HBM3 с пропускной способностью до 3,35 ТБ/с. Топология NVLink 4.0 и NVSwitch обеспечивает высокоскоростное соединение восьми GPU с пропускной способностью до 900 ГБ/с, что минимизирует задержки при передаче данных и улучшает масштабируемость при параллельных вычислениях.

Технология Multi-Instance GPU (MIG) позволяет разделять каждый GPU на до 7 виртуальных инстансов, что обеспечивает гибкость и эффективность при выполнении разнообразных задач.

Инфраструктура, совместимость и области применения

Сервер NVIDIA с 8 H100 SXM рассчитан на использование в высокопроизводительных дата-центрах и вычислительных кластерах с поддержкой NVMe SSD, а также высокоскоростных сетевых интерфейсов InfiniBand и Ethernet со скоростью до 400 Гбит/с. Платформа совместима с программным стеком NVIDIA AI Enterprise, включающим CUDA, TensorRT, Triton, и популярные AI-фреймворки PyTorch, TensorFlow и DeepSpeed. Это делает сервер идеальным выбором для масштабируемого обучения и инференса AI-моделей, генеративного ИИ и HPC.

- 8 ускорителей NVIDIA H100 SXM с 80 ГБ памяти HBM3 каждый

- Пропускная способность памяти до 3,35 ТБ/с на каждый GPU

- NVLink 4.0 и NVSwitch с пропускной способностью до 900 ГБ/с

- Поддержка Multi-Instance GPU (MIG) для эффективной виртуализации

- Высокоскоростные сетевые интерфейсы InfiniBand и Ethernet

- Совместимость с NVIDIA AI Enterprise и ведущими AI-фреймворками

- Оптимален для масштабируемого AI обучения и HPC задач

подбор оборудования

до 90 дней