Внимание

Мы работаем в штатном режиме. Наши склады готовы поставлять оборудование клиентам из Российской Федерации несмотря на санкционные запреты ЕС и США. Оборудование в РФ ввозится легально благодаря новому законодательству с параллельным импортом. Звоните и уточняйте! Информация актуальна на 05.12.25В связи с участившимися случаями недобросовестной конкуренции обращаем ваше внимание, что мы не передаем персональные данные третьим лицам

Поиск по сайту

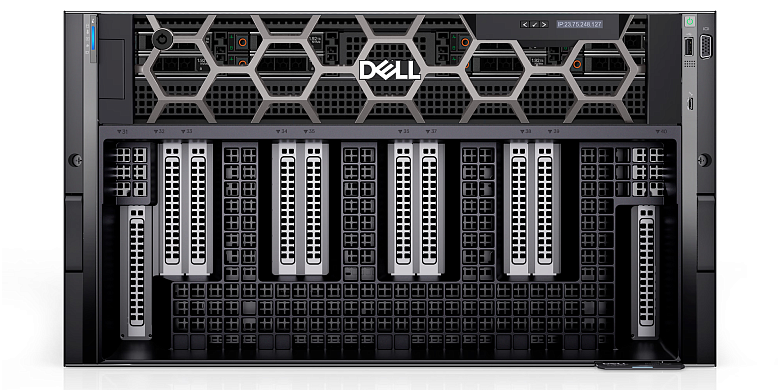

GPU‑сервер Dell с 8 ускорителями NVIDIA B200 (SXM)

Гарантия до 5 лет

Диагностика перед отправкой

С нами выгодно и удобно!

- Поддержка персонального менеджера

- Партнёрские скидки до 70%

- Онлайн-кабинет гарантийного сервиса

Как купить?

Раз, два и все делаРассчитаем стоимость

Присылайте спецификацию для подбора и расчета стоимости оборудования

Привезём и подключим

Подключим и настроим оборудование в вашем офисе или ЦОДе

Характеристики

Комплектующие для GPU‑сервера Dell с 8 ускорителями NVIDIA B200 (SXM)

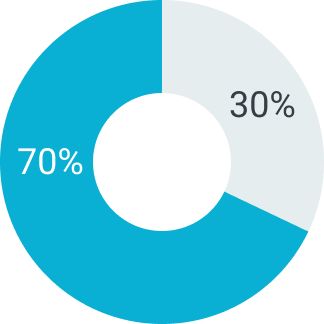

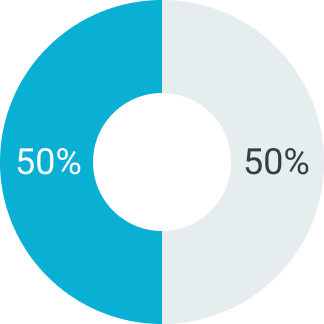

Отсрочка платежа

В зависимости от суммы поставляемого товара можем предоставить отсрочку платежа на срок от 5 до 90 дней. Условия отсрочки платежа рассматриваются индивидуально. Подробную информацию уточняйте у вашего менеджера.

Первый платеж

Второй платеж

Первый платеж

Второй платеж

Первый платеж

Второй платеж

Описание

GPU‑сервер Dell с 8 ускорителями NVIDIA B200 (SXM) представляет собой комплексное и мощное решение для выполнения энергоёмких задач искусственного интеллекта, машинного обучения и высокопроизводительных вычислений. Собран на базе современных процессоров Intel Xeon Platinum, эта система оснащена восемью ускорителями NVIDIA B200, каждый из которых имеет 192 ГБ памяти HBM3e, обеспечивая общую память свыше 1,5 ТБ и пропускную способность, необходимую для обработки самых крупных AI-моделей и рабочих нагрузок.

Архитектура NVIDIA B200 и особенности сервера Dell

Ускорители NVIDIA B200 выполнены по архитектуре Blackwell с 208 миллиардами транзисторов и памяти HBM3e общим объёмом 192 ГБ на каждый GPU, с пропускной способностью до 8 ТБ/с. Топология NVLink 5.0 в сочетании с NVSwitch позволяет сформировать единую высокоскоростную сеть между восьмью GPU с пропускной способностью передачи данных до 1,8 ТБ/с, что значительно ускоряет параллельные вычисления и распределённое обучение нейросетей.

Сервер оборудован высокоэффективной системой жидкостного охлаждения и поддерживает Multi-Instance GPU (MIG) для разделения ресурсов каждого GPU на до 7 независимых виртуальных инстансов, что повышает гибкость и масштабируемость вычислительных операций.

Инфраструктура, программное обеспечение и область применения

Dell PowerEdge с NVIDIA B200 оснащён до 4 ТБ DDR5 памяти, высокоскоростными NVMe SSD-дисками и современными сетевыми интерфейсами с пропускной способностью до 400 Гбит/с, включая InfiniBand и Ethernet. Платформа полностью совместима с NVIDIA AI Enterprise, предоставляющим полный набор инструментов CUDA, TensorRT, Triton и поддержку популярных AI-фреймворков, таких как PyTorch и TensorFlow. Система предназначена для дата-центров и научных лабораторий, которые требуют максимальной производительности и качества обработки больших моделей ИИ.

- 8 ускорителей NVIDIA B200 SXM с 192 ГБ HBM3e памяти каждый

- Общая память GPU свыше 1,5 ТБ с пропускной способностью до 8 ТБ/с на каждый ускоритель

- Топология NVLink 5.0 + NVSwitch с пропускной способностью до 1,8 ТБ/с

- Жидкостное охлаждение и энергоэффективное питание

- Multi-Instance GPU (MIG) с поддержкой виртуализации ресурсов

- Совместимость с NVIDIA AI Enterprise и ведущими AI-фреймворками

- Идеален для масштабируемого и распределённого обучения и инференса

подбор оборудования

до 90 дней

для бизнеса